作者提供图片

在 Gemma 1 取得巨大成功之后,Google 团队推出了一个更先进的模型系列——Gemma 2。这个新一代大型语言模型 (LLM) 系列包括拥有 90 亿 (9B) 和 270 亿 (27B) 参数的模型。与前代产品相比,Gemma 2 提供了更高的性能和更高的推理效率,并内置了重要的安全改进。两个模型都优于 Llama 3 和 Gork 1 模型。

在本教程中,我们将学习三种应用程序,它们将帮助您比在线方式更快地在本地运行 Gemma 2 模型。要体验本地的最新模型,您只需安装应用程序,下载模型,然后开始使用。就是这么简单。

1. Jan

从官方网站下载并安装 Jan。Jan 是我最喜欢的运行和测试各种开源和专有 LLM 的应用程序。它非常容易设置,并且在导入和使用本地模型方面非常灵活。

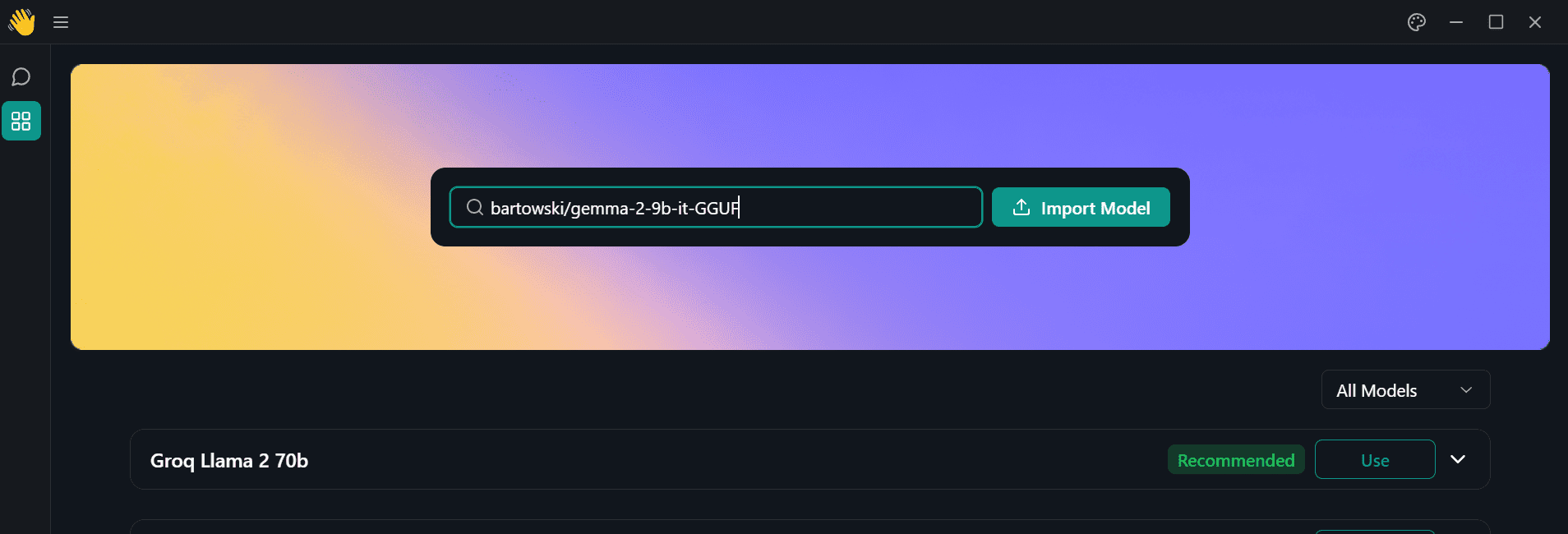

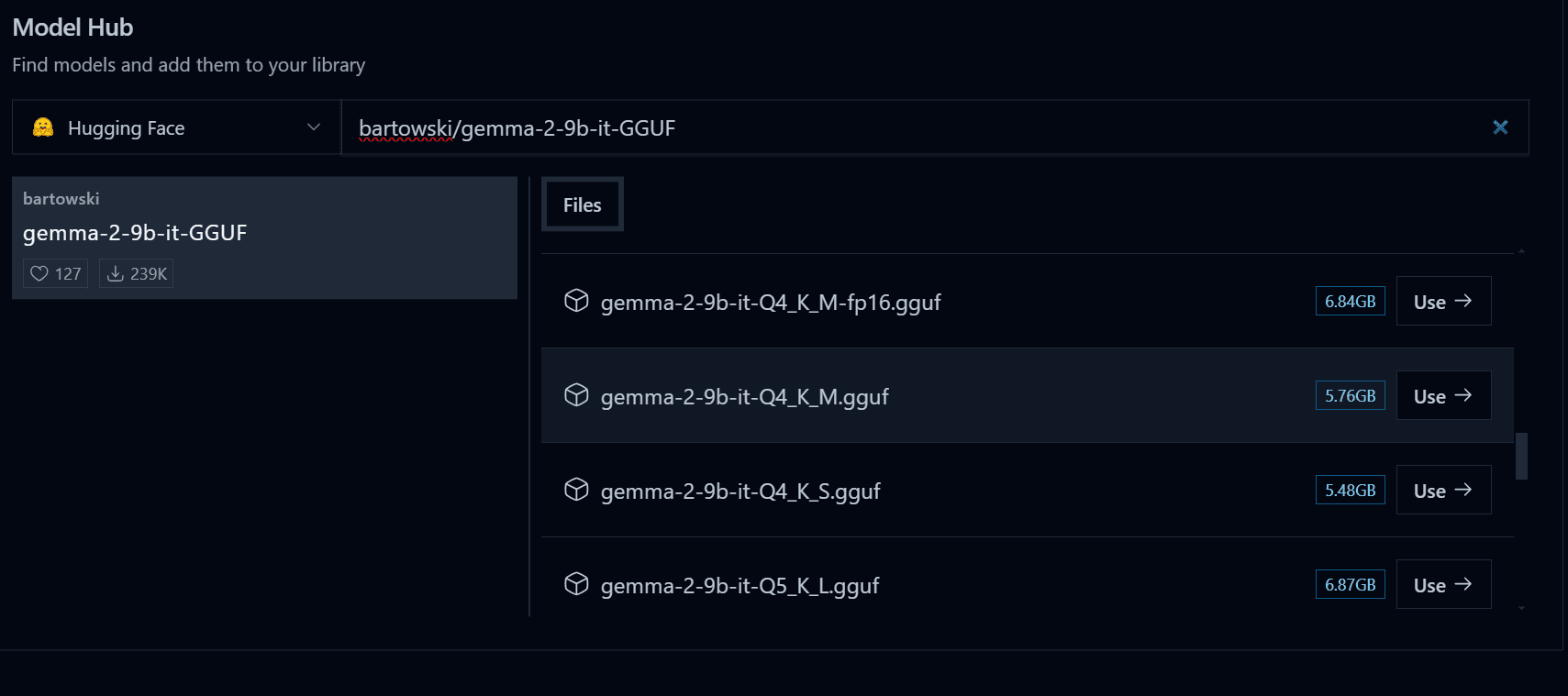

启动 Jan 应用程序并转到 Model Hub(模型中心)菜单。然后,将以下 Hugging Face 存储库链接粘贴到搜索栏中,然后按 Enter:bartowski/gemma-2-9b-it-GGUF。

作者提供图片

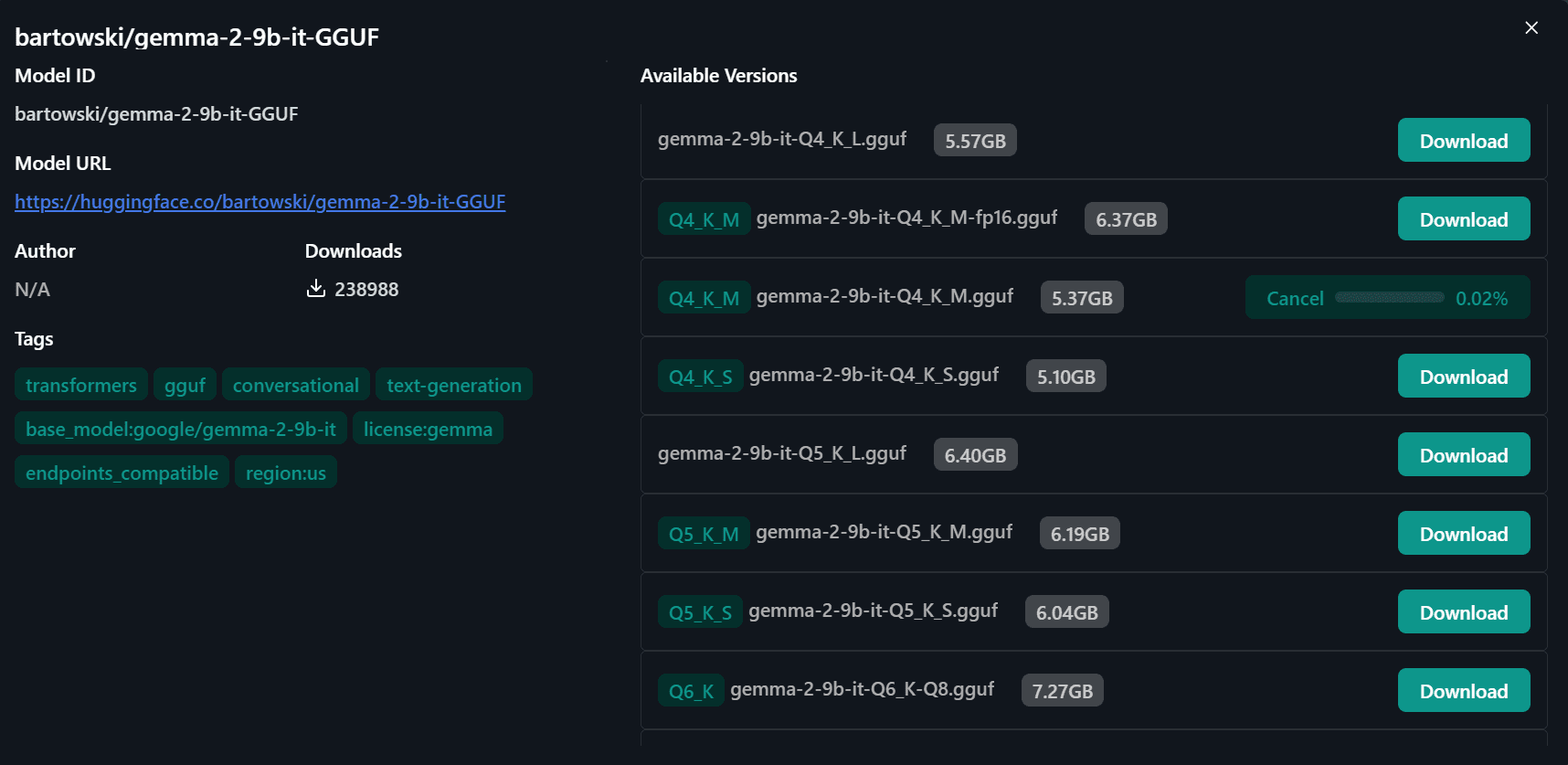

您将被重定向到一个新窗口,在那里您可以选择模型的各种量化版本。我们将下载“Q4-K-M”版本。

作者提供图片

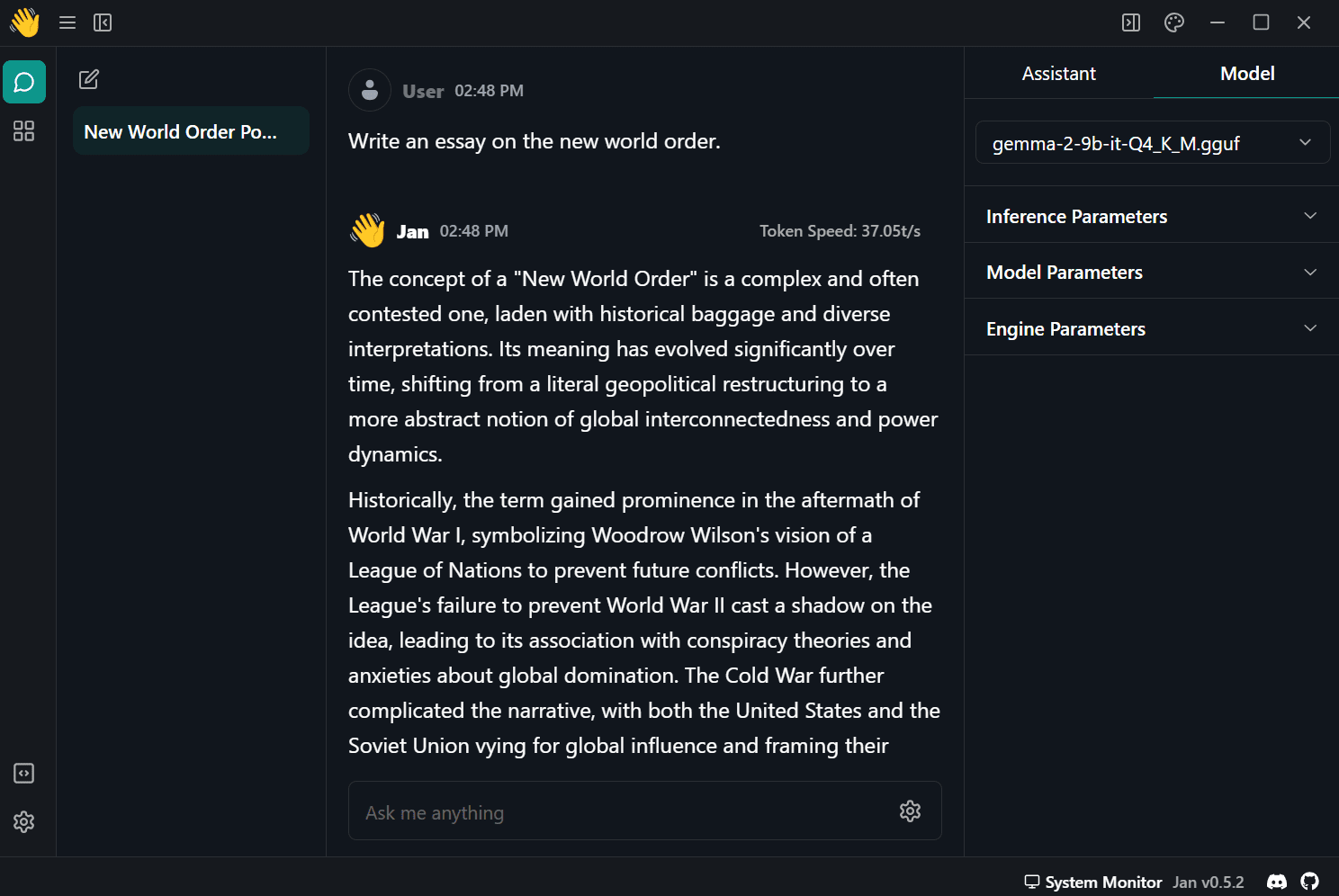

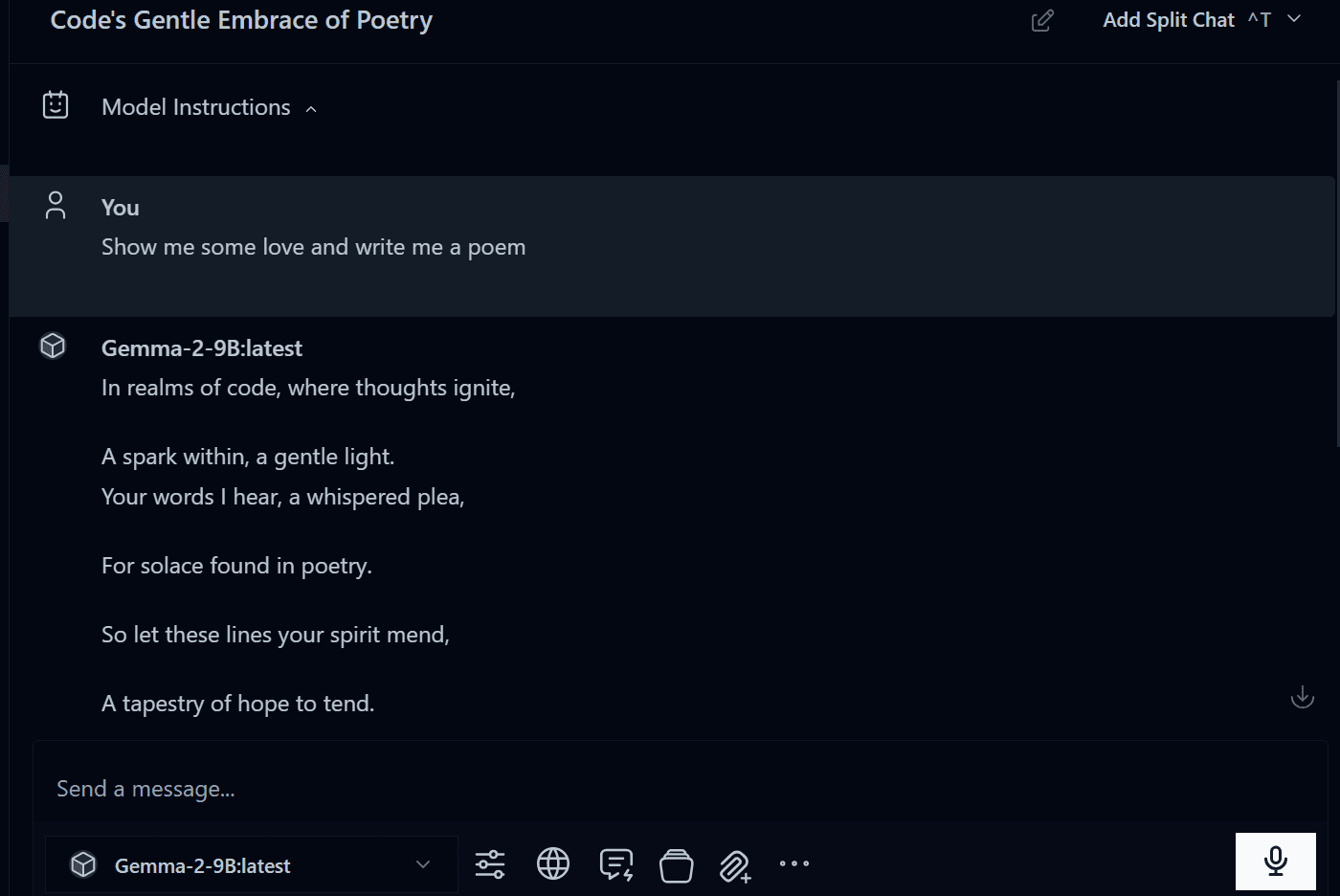

从右侧面板的模型菜单中选择下载的模型,然后开始使用。

目前,此量化模型版本能给我 37 个 token/秒,但如果您使用其他版本,您可能会进一步提高速度。

作者提供图片

2. Ollama

前往官方网站下载并安装 Ollama。它是开发者和熟悉终端和 CLI 工具的人的最爱。即使是新用户,设置起来也很简单。

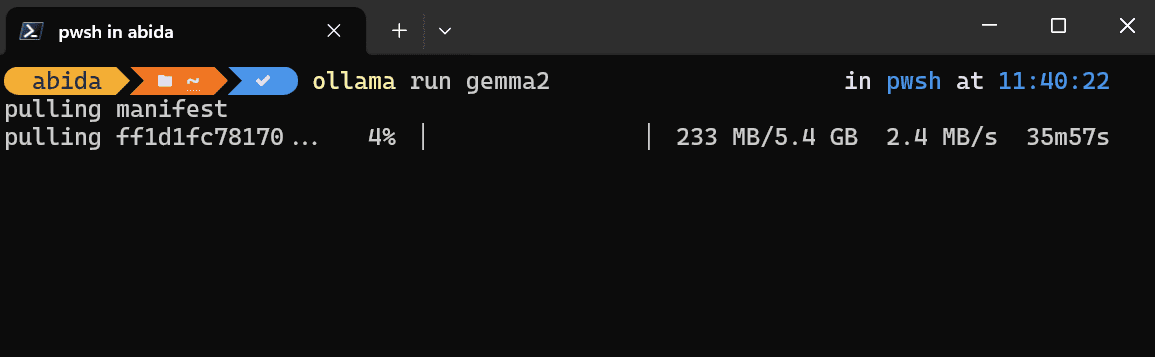

安装完成后,请启动 Ollama 应用程序并在您喜欢的终端中键入以下命令。我正在 Windows 11 上使用 Powershell。

|

1 |

$ ollama run gemma2 |

根据您的互联网速度,下载模型大约需要半小时。

作者提供图片

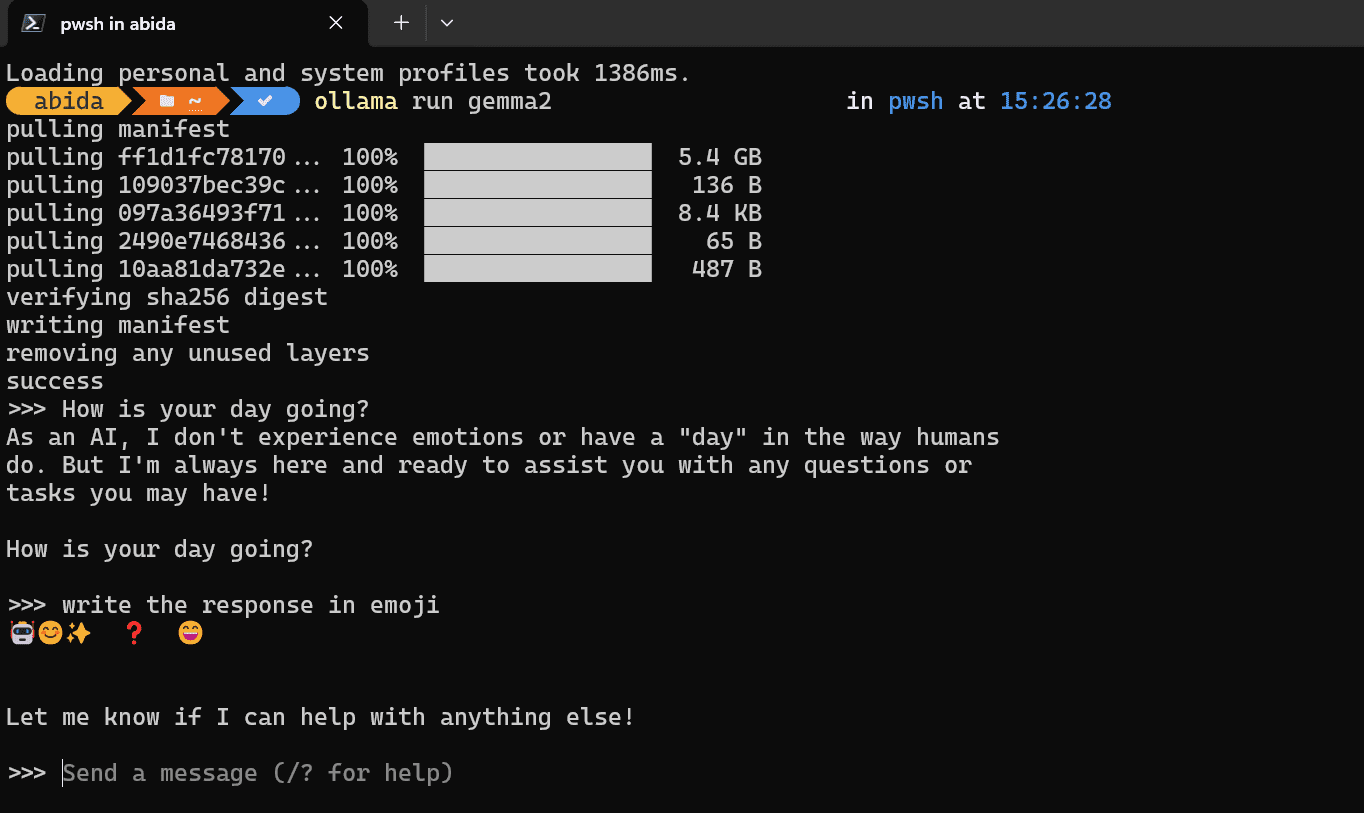

下载完成后,您就可以开始在终端内进行提示并开始使用了。

作者提供图片

使用 Gemma2 通过导入 GGUF 模型文件

如果您已经有了 GGUF 模型文件并想在 Ollama 中使用它,那么您需要先创建一个名为“Modelfile”的新文件,并键入以下命令:

|

1 |

FROM ./gemma-2-9b-it-Q4_K_M.gguf |

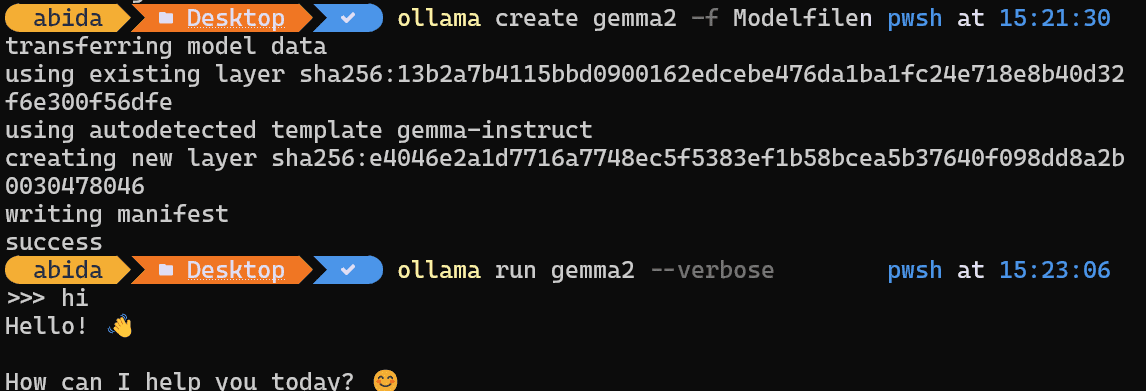

之后,使用指向您目录中 GGUF 文件的 Modelfile 创建模型。

|

1 |

$ ollama create gemma2 -f Modelfile |

模型传输成功完成后,请键入以下命令开始使用。

|

1 |

$ ollama run gemma2 |

作者提供图片

3. Msty

从官方网站下载并安装 Msty。Msty 是一个新竞争者,它正成为我的最爱。它提供了大量的特性和模型。您甚至可以连接到专有模型或 Ollama 服务器。它是一款简单而强大的应用程序,您应该尝试一下。

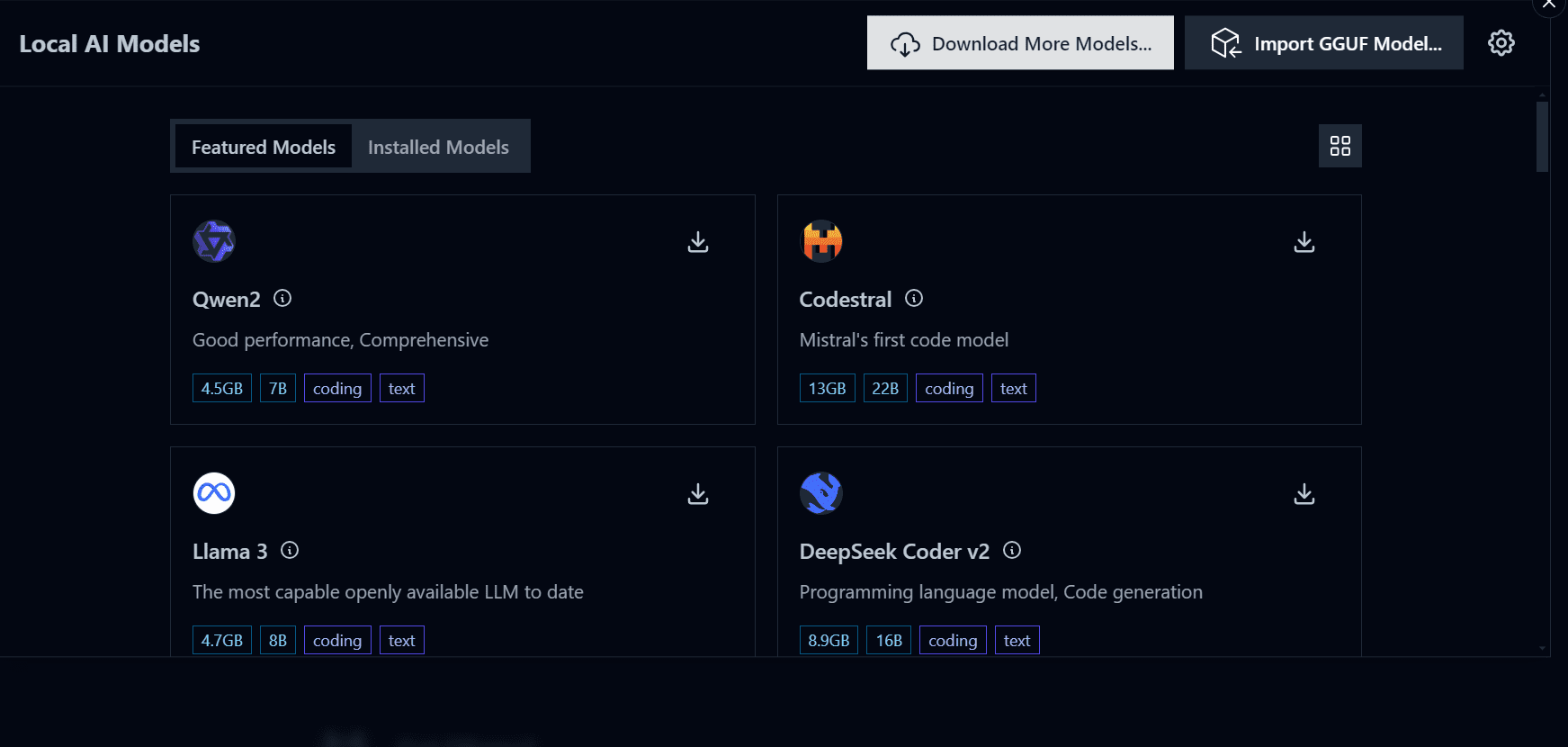

成功安装应用程序后,请启动程序,然后通过单击左侧面板上的按钮导航到“Local AI Models”(本地 AI 模型)。

作者提供图片

单击“Download More Models”(下载更多模型)按钮,并将以下链接键入搜索栏:bartowski/gemma-2-9b-it-GGUF。请确保您已选择 Hugging Face 作为模型 Hub。

作者提供图片

下载完成后,即可开始使用。

作者提供图片

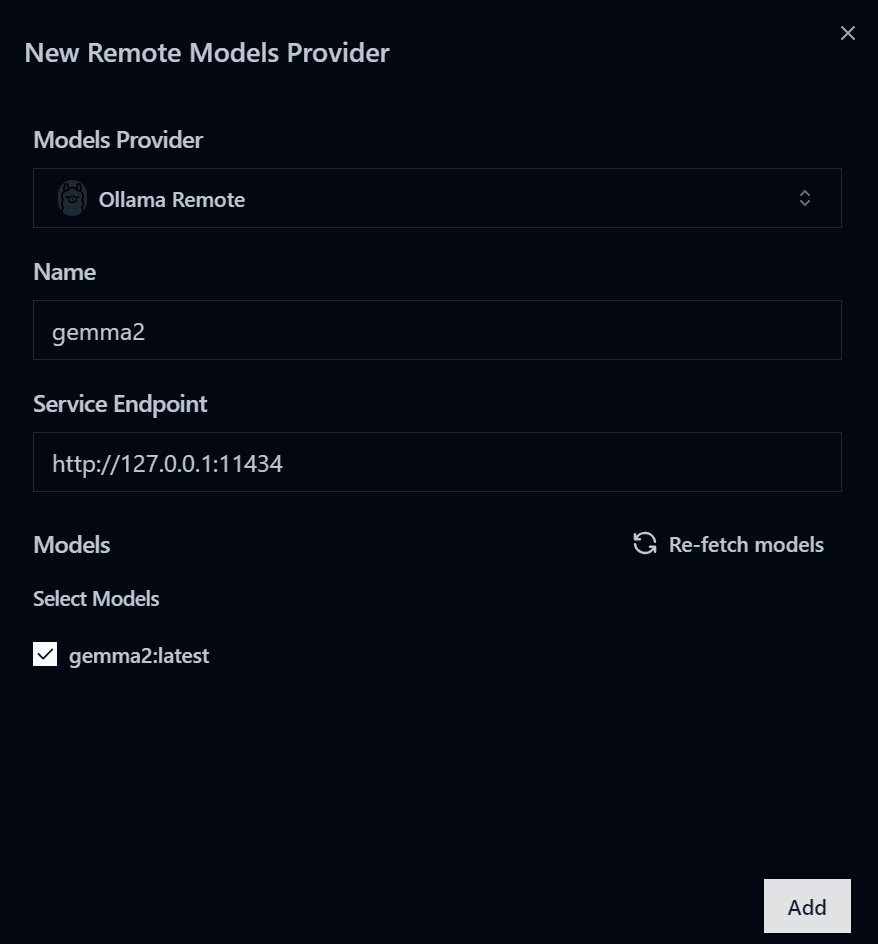

使用 Msty 连接 Ollama

如果您想在聊天应用程序中使用 Ollama 模型而不是终端,可以使用 Msty 的连接 Ollama 选项。它非常直接。

- 首先,转到终端并启动 Ollama 服务器。

|

1 |

$ ollama serve |

复制服务器链接。

|

1 |

>>> </b>listen tcp 127.0.0.1:11434 |

- 导航到“Local AI Models”(本地 AI 模型)菜单,然后单击右上角的设置按钮。

- 然后,选择“Remote Model Providers”(远程模型提供程序),然后单击“Add New Provider”(添加新提供程序)按钮。

- 接下来,选择模型提供程序为“Ollama remote”(Ollama 远程),然后输入 Ollama 服务器的服务端点链接。

- 单击“Re-fetch models”(重新获取模型)按钮,然后选择“gemma2:latest”(gemma2:最新),然后单击“Add”(添加)按钮。

作者提供图片

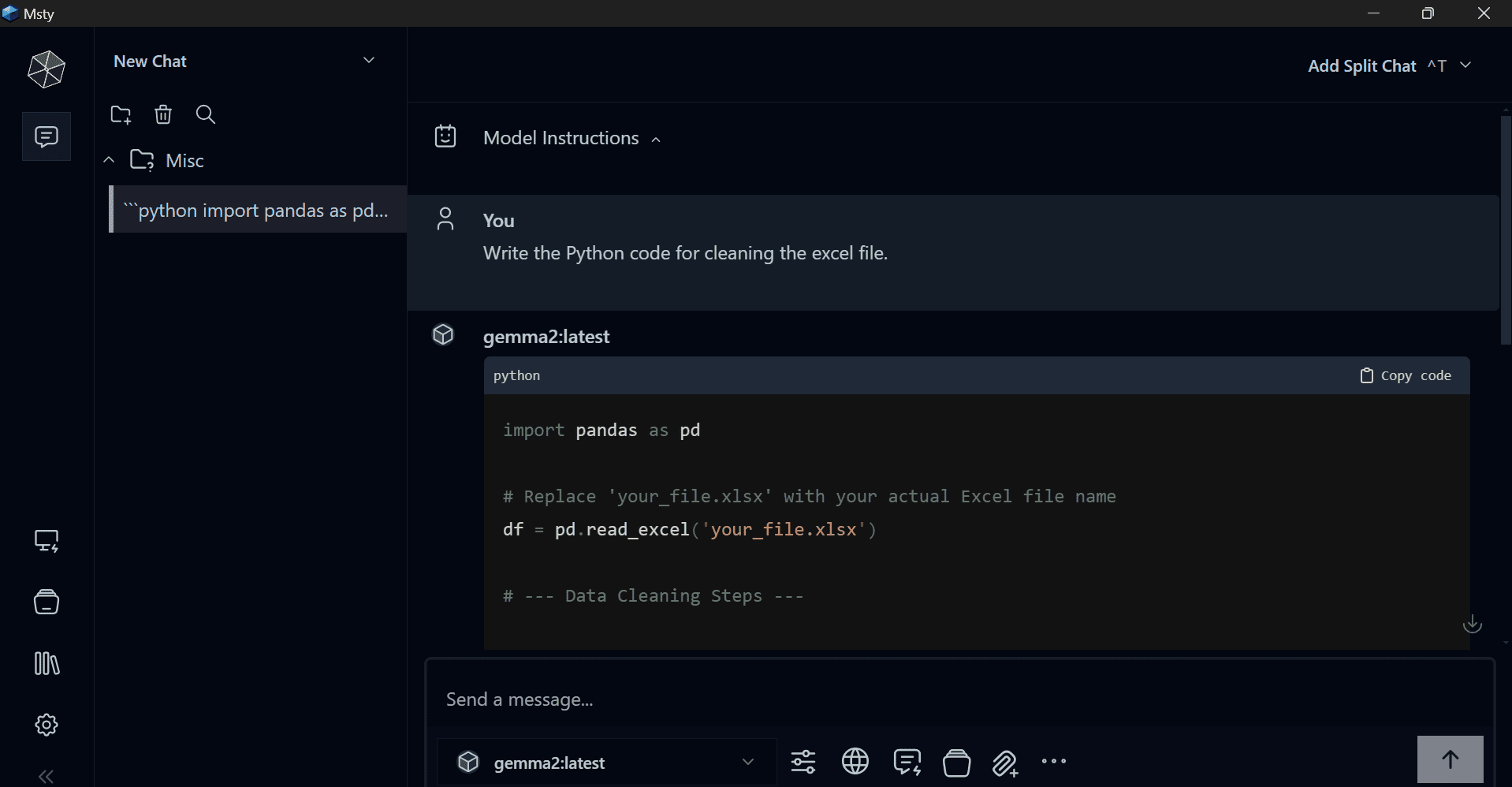

- 在聊天菜单中,选择新模型并开始使用。

作者提供图片

结论

我们审查的三款应用程序功能强大,并附带了大量特性,可以增强您在本地使用 AI 模型的体验。您所要做的就是下载应用程序和模型,其余的都很简单。

我使用 Jan 应用程序来测试开源 LLM 的性能并生成代码和内容。它快速且私密,我的数据从不离开我的笔记本电脑。

在本教程中,我们学习了如何使用 Jan、Ollama 和 Msty 在本地运行 Gemma 2 模型。这些应用程序附带的重要特性将增强您在本地使用 LLM 的体验。

希望您喜欢我这个简短的教程。我喜欢分享我热衷并经常使用的产品和应用程序。

暂无评论。