训练大型语言模型时要避免的 5 个常见错误

图片作者 | Midjourney

引言

训练大型语言模型(LLM)是一个复杂的过程,需要周密的计划、计算资源和领域专业知识。数据科学家、机器学习从业者和AI工程师都可能陷入一些常见的训练或微调模式,这些模式可能会影响模型的性能或可扩展性。

本文旨在识别训练LLM时需要避免的五个常见陷阱,并提供可操作的见解以确保最佳结果。

🎯 命中要点

在训练LLM时,请牢记这些潜在的陷阱,以保持目标一致。

- 训练数据预处理不足

- 低估资源需求

- 忽视模型过拟合和欠拟合

- 忽视偏见和伦理考量

- 忽视微调和持续学习

1. 训练数据预处理不足

原始数据——无论其数量或多样性如何——在未经刻意和特定的预处理时,很少适合用于训练LLM。与**所有**类型的模型训练一样,常见的错误包括在数据集中遗留嘈杂、不相关或格式不正确的数据。这些数据可能导致模型的性能过拟合或产生不良偏见。

最低限度,预处理应包括

- 删除重复项

- 标准化文本格式

- 过滤掉露骨、冒犯性、不相关或其他不受欢迎的内容

- 将数据保留在易于被特定分词过程中处理的状态,确保在为模型准备和输入模型时能正常使用。

分词错误,例如特殊字符或表情符号管理不当,会明显影响训练过程。始终使用探索性数据分析工具分析数据集的质量,并确保其符合模型的预期用途。

请记住,正如所有形式的机器学习一样,**训练数据的质量直接影响模型质量**。

2. 低估资源需求

训练LLM需要大量的计算能力、内存和存储。一个常见的错误是低估这些需求,这可能导致频繁中断或无法完成训练过程。

为避免此问题,请根据以下因素计算资源需求:

- 模型架构

- 数据集大小

- 预期训练时长

考虑使用分布式计算框架或云解决方案来有效扩展资源,并具备某种形式的内置容错或热恢复功能。在训练过程中监控硬件利用率,以识别瓶颈。

及早规划资源需求可以确保更平稳的训练,并避免时间和成本的浪费,而这些因素如果管理不当会迅速累积。

3. 忽视模型过拟合和欠拟合

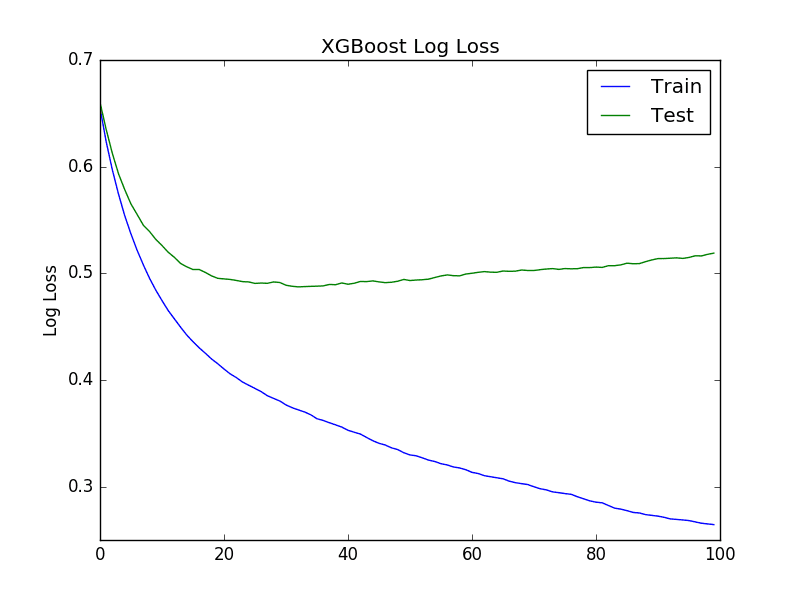

**过拟合**是指模型记住了训练数据但无法泛化,而**欠拟合**是指模型过于简单,无法捕捉数据模式。这两种情况都会导致在未见过的数据上表现不佳。

使用验证数据集定期评估模型的性能,并监控困惑度或交叉熵损失等指标。为缓解过拟合,请采用以下技术:

- dropout(丢弃)——在训练期间随机关闭一些神经元,以防止网络过度依赖任何单一连接,有助于确保所有可用路径都被利用。

- early stopping(早停)——当验证数据上的性能开始变差时停止训练。

- regularization(正则化)——对复杂模型增加惩罚项,鼓励更简单的解决方案。

对于欠拟合,应增加模型复杂度或优化超参数。平衡这些因素对于实现强大的LLM至关重要。

4. 忽视偏见和伦理考量

LLM中的偏见是一个可能延续刻板印象或伤害特定社区的问题。在不平衡或无代表性的数据集上训练模型可能导致有偏见的输出,损害模型的公平性。从纯粹的实际角度来看,一个不能反映现实的模型不是一个有用的模型。

为解决此问题

- 策划多样化且具有代表性的数据集,涵盖广泛的人口统计和主题。

- 在测试期间使用工具检测和衡量模型预测中的偏见。

- 实施去偏算法或使用包容性数据进行微调等技术,以最小化伤害。

伦理责任在LLM训练中与技术准确性同等重要。

5. 忽视微调和持续学习

一旦基础模型训练完成,许多开发者就止步于此,忽视了微调和领域特定调整。这限制了模型在专业任务或动态环境中的可用性。

在较小的、特定领域的数据集上进行微调,可以显著提升特定用例的性能。同样,采用持续学习策略可以让您的模型适应新数据或随时间的变化。利用迁移学习来利用预训练模型并降低资源需求。

定期更新可确保您的LLM保持相关性和有效性。

总结

训练LLM既是一门艺术,也是一门科学,需要仔细关注数据质量、计算资源、模型评估、伦理考量以及训练后过程。通过避免这些常见陷阱,您可以创建不仅准确高效,而且在现实应用中符合伦理且实用的模型。请记住,成功训练LLM取决于计划、警惕和持续改进。

暂无评论。