Q-Learning 入门介绍

图片由 Editor | ChatGPT 提供

引言

强化学习是人工智能(AI)的一个相对鲜为人知的领域,与当今非常受欢迎的子领域(如机器学习、深度学习和自然语言处理)相比。然而,它在解决复杂的决策问题方面具有巨大的潜力,在这些问题中,“智能”软件实体(称为智能体)必须通过与环境的交互来学习解决问题。

强化学习使智能体能够通过经验学习,通过根据所做的决策执行一系列动作来随着时间的推移最大化累积奖励。强化学习中最广泛使用的算法之一是Q学习,它研究智能体如何在不要求对其运行环境进行完整建模的情况下,学习不同状态下动作的价值。

本文以清晰且具说明性的语气,对 Q 学习、其原理及其算法的基本特征进行了温和的介绍。

在继续深入之前,如果您对强化学习不熟悉,我们建议您阅读这篇入门文章,其中涵盖了一些后面使用的基本概念,如价值函数、策略等。

Q 学习基础

Q 学习属于一类称为时间差学习或简称为TD 学习的强化学习算法。在 TD 学习中,智能体通过重复采样来直接从经验中学习,以估计价值函数,但同时它也进行自举——也就是说,它基于其他学习到的估计来更新其价值估计,而不是等待最终结果,从而不需要对环境或未来奖励的完全了解。

例如,考虑一个仓库中的配送机器人,它必须学会从入口到各种存储箱的最有效路径,同时避开障碍物并最小化旅行时间。通过实现 TD 学习,机器人会采样可能的动作——例如,向前移动、向左移动等——通过仓库导航:它选择方向,观察路径的结束位置,并为每个移动接收时间或惩罚反馈。此外,它通过根据其导航到的下一个位置的估计值来更新其当前位置的价值估计来自举,而不是等到配送轨迹完成才评估每个决策的好坏。

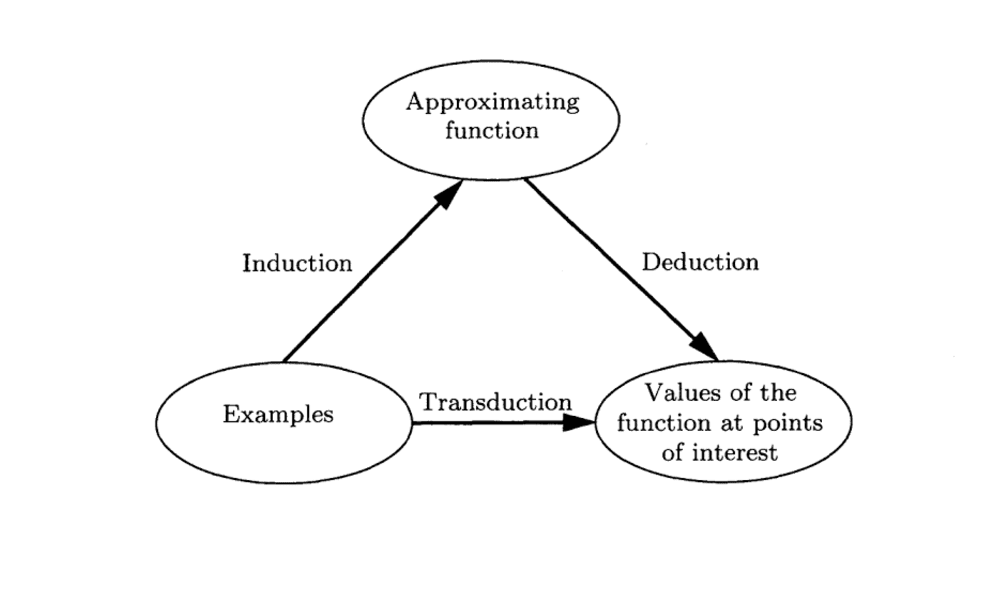

Q 学习是一种强化学习方法,它不需要其环境的模型,通过尝试各种选项并从后续结果中学习,帮助智能体找出为了获得最大回报而应做出的最佳选择。“Q”在其名称中代表质量,因为目标是学习在不同情况下哪些动作序列最有回报。与其他需要预先了解“世界”(例如,前一个例子中的物理仓库)如何运作的方法不同,Q 学习直接从经验中学习。此外,虽然一些其他算法从它们正在使用的确切策略中学习,但 Q 学习表现得更灵活——它通过比较备选策略的结果而不是仅仅关注它当前遵循的策略,从而采取更广泛的学习方法。

一个简单的例子:仓库网格

以下示例以温和的语气和不涉及复杂数学的方式说明了 Q 学习的工作原理。请注意,要完全理解 Q 学习背后的数学原理(例如贝尔曼方程),您可能需要查阅其他资料,例如这篇。

回到之前提到的仓库配送机器人示例场景,假设仓库设施用 3x3 的物理位置网格表示,如下所示:

[ A ] [ B ] [ C ]

[ D ] [ E ] [ F ]

[ G ] [ H ] [ 目标 ]

假设机器人从 A 位置开始,并希望到达右下角的“目标”位置。每次移动都会花费时间,从而产生少量惩罚或损失。此外,由于设施的性质和需要解决的问题,撞墙或向错误方向移动是不被鼓励的,而到达目标会带来奖励。

在每个步骤和位置(状态),机器人可以尝试四种可能的动作之一:向上、向下、向右或向左移动。

Q 学习的一个关键要素是一个“查找表”,类似于一个记忆笔记本,机器人会在其中记录在每个状态下每种可能动作的奖励。奖励以数值表示:数值越高越好。此外,它们是动态更新的:机器人根据其经验迭代地更新或微调这些值。假设经过几次试验,机器人已经学会了它到目前为止经历过的某些状态下某些动作的奖励如下:

| 位置 | 向右 | 向下 | 向左 | 向上 |

|---|---|---|---|---|

| A | 0.1 | 0.3 | — | — |

| B | 0.0 | 0.1 | 0.2 | — |

| E | 0.4 | 0.7 | 0.2 | 0.1 |

| H | 1.0 | — | 0.5 | 0.3 |

需要澄清的是,一开始机器人一无所知,所有奖励值将默认为零或其他初始值。它必须先尝试随机动作,观察会发生什么,然后再建立一个对环境的大致了解。

- 假设它从 A 开始并尝试向下走,最终到达 D。如果那是一条充满障碍物的繁忙路线,可能会花费很多时间,这可能不是当前最佳行动。

- 如果它稍后尝试从 A 向右移动到 B,然后向下移动到 E,再到 H,并最终在合理的时间内到达目标状态,它可能会更新表中的值以反映这些状态-动作选择是好的。在 Q 学习中,不仅考虑了所选动作的短期影响,还将在一定程度上考虑后续动作的传播影响。

总而言之,每次机器人(智能体)尝试一条路径时,它都会在表中略微更新值,根据迄今为止表现更好的情况对其进行越来越精确的校准。

长远来看,通过应用这种行为,智能体最终可以从自己的经验中学习,更新所谓的 Q 表以反映产生更好结果的行动方案。它不仅学习从初始位置到最佳路线(们),而且还学习要避免什么,例如撞墙、进入角落等。所有这些都无需对环境进行完全的知识表示,或者换句话说,无需详细的仓库地图。

结论

Q 学习等同于学习玩一个游戏,在这个游戏中必须通过多次游玩来不断做出选择,记住什么产生了更好的结果,并逐渐将最初的随机选择调整为更智能的选择以改善结果。本文对强化学习的这一领域进行了温和且不涉及数学的介绍,这在该领域的早期是其突破之一。

我刚开始进入 AI 领域。你有什么建议给初学者,如何最好地利用 AI?我的意思是,如何在该领域取得进步。

你好 Peter……我们建议建立一个作品集:https://machinelearning.org.cn/ultimate-guide-building-machine-learning-portfolio-lands-jobs/