训练深度神经网络传统上具有挑战性,因为梯度消失意味着靠近输入层的权重不会响应训练数据集上计算出的错误而更新。深度学习领域的一项创新和重要里程碑是贪婪层级预训练,它使非常深的神经网络能够 […]

训练深度神经网络传统上具有挑战性,因为梯度消失意味着靠近输入层的权重不会响应训练数据集上计算出的错误而更新。深度学习领域的一项创新和重要里程碑是贪婪层级预训练,它使非常深的神经网络能够 […]

深度学习神经网络使用随机梯度下降优化算法进行训练。作为优化算法的一部分,必须反复估计模型当前状态的误差。这需要选择一个误差函数,通常称为损失函数,可用于估计 […] 的损失。

神经网络使用随机梯度下降进行训练,并且在设计和配置模型时需要选择一个损失函数。有很多损失函数可供选择,了解选择哪一个,甚至损失函数是什么以及它在训练 […] 中的作用,都可能很困难。

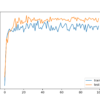

深度学习神经网络使用随机梯度下降优化算法进行训练。学习率是一个超参数,它控制在每次更新模型权重时,模型会根据估计的误差改变多少。选择学习率很困难,因为值太小可能会导致 […]

神经网络的权重无法通过解析方法计算。取而代之的是,必须通过一个称为随机梯度下降的经验优化过程来发现权重。随机梯度下降在神经网络中解决的优化问题具有挑战性,解决方案空间(权重集合)可能包含许多好的 […]

神经网络使用梯度下降进行训练,其中用于更新权重的误差估计是根据训练数据集的子集计算的。用于误差梯度估计的训练数据集中的示例数量称为批次大小,并且是一个重要的超参数,它 […]

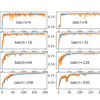

批归一化是一种旨在自动标准化深度学习神经网络层输入的技巧。实施后,批归一化可以显著加速神经网络的训练过程,在某些情况下还能通过适度的正则化效果提高模型的性能。在本教程中, […]

实用深度学习是一个入门颇具挑战性的主题。它通常采用自下而上的方式进行教学,要求您首先熟悉线性代数、微积分和数学优化,然后才能学习神经网络技术。这可能需要数年时间,而且大多数背景理论都不会帮助您 […]

训练具有数十层的深度神经网络具有挑战性,因为它们可能对初始的随机权重和学习算法的配置很敏感。造成这种困难的一个可能原因是在权重更新后,网络深层输入的分布可能会在每个 mini-batch 后发生变化。这 […]

开发神经网络通常被称作一门神秘的艺术。原因是精通开发神经网络模型需要经验。没有可靠的方法可以通过解析方法计算如何为您的特定数据集设计一个“好”或“最佳”的模型。您必须依靠经验并进行实验 […]