梯度消失问题是您在训练深度神经网络时可能遇到的不稳定行为的一个例子。它描述了深度多层前馈网络或循环神经网络无法将有用的梯度信息从模型的输出端反向传播到靠近 [...] 的层的情况。

梯度消失问题是您在训练深度神经网络时可能遇到的不稳定行为的一个例子。它描述了深度多层前馈网络或循环神经网络无法将有用的梯度信息从模型的输出端反向传播到靠近 [...] 的层的情况。

在神经网络中,激活函数负责将节点加权的加权输入转换为该节点的激活或该输入的输出。ReLU(Rectified Linear Unit)激活函数,简称 ReLU,是一个分段线性函数,如果输入为正,则直接输出输入值,否则 [...]。

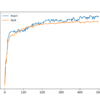

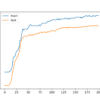

神经网络的训练过程是一个具有挑战性的优化过程,往往会失败而无法收敛。这意味着训练结束时的模型可能不是稳定或表现最佳的权重集,无法用作最终模型。解决此问题的一种方法是使用平均 [...]。

模型集成可以实现比单一模型更低的泛化误差,但由于训练每个单一模型的计算成本,因此使用深度学习神经网络开发集成模型具有挑战性。一种替代方法是在单次训练运行中训练多个模型快照,并组合它们的预测以做出集成预测。这有一个局限性 [...]。

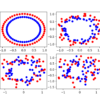

监督学习具有挑战性,尽管这种挑战的深度往往在学习后被遗忘或被故意忽略。事实必然如此,因为长时间沉浸在这种挑战中可能会导致悲观的展望。尽管存在挑战,我们仍在使用监督学习算法,并且它们在实践中表现良好。根本 [...]。

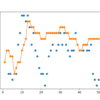

模型平均是一种集成技术,其中多个子模型对组合预测做出相等的贡献。通过按子模型的预期性能对每个子模型对组合预测的贡献进行加权,可以改进模型平均。通过训练一个全新的模型来学习如何最佳地组合 [...],可以进一步扩展这一点。

模型平均集成将每个模型的预测平均组合,并且通常比单个模型产生更好的平均性能。有时,有一些非常好的模型,我们希望它们对集成预测做出更大的贡献,也许还有一些可能有用的模型,但应该对 [...] 做出较小的贡献。

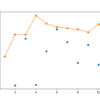

训练数据集相对于未标记示例数量较小时的预测建模问题具有挑战性。神经网络可以在这些类型的问题上表现良好,但它们可能会出现模型性能高方差的问题,如在训练集或保留验证集上测量的那样。这使得选择使用哪个模型作为 [...] 变得困难。

集成学习是结合多个模型预测的方法。在集成学习中,组成集成的模型必须是好的,并且做出不同的预测错误是很重要的。以不同方式表现良好的预测可以产生比任何一个模型的预测都更稳定且通常更好的预测。

深度学习神经网络模型是高度灵活的非线性算法,能够学习近乎无限数量的映射函数。这种灵活性的一个令人沮丧之处在于最终模型的方差很高。在相同数据集上训练的相同神经网络模型每次都可能找到许多可能的“足够好”的解决方案之一 [...]。