集成学习是一种通用的机器学习元方法,旨在通过组合多个模型的预测来获得更好的预测性能。尽管您可以为预测建模问题开发数量看似无限的集成模型,但有三种方法在集成学习领域占主导地位。非常重要,以至于 […]

集成学习是一种通用的机器学习元方法,旨在通过组合多个模型的预测来获得更好的预测性能。尽管您可以为预测建模问题开发数量看似无限的集成模型,但有三种方法在集成学习领域占主导地位。非常重要,以至于 […]

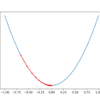

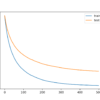

梯度下降是一种优化算法,它沿着目标函数的负梯度方向移动,以找到函数的最小值。这是一种简单而有效的技术,只需几行代码即可实现。它还为许多可以产生 [...] 的扩展和修改提供了基础。

梯度是优化和机器学习中常用的术语。例如,深度学习神经网络通过随机梯度下降进行拟合,而用于拟合机器学习算法的许多标准优化算法都使用梯度信息。为了理解什么是梯度,您需要理解导数是什么,它来自 [...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向移动,以找到函数的最小值。梯度下降的一个限制是它为每个输入变量使用相同的步长(学习率)。AdaGradn 和 RMSProp 是梯度下降的扩展,它们添加了自适应 [...]

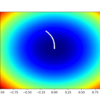

半监督学习是一个涉及少量标记示例和大量未标记示例的学习问题。这类学习问题具有挑战性,因为有监督和无监督学习算法都无法有效利用标记数据和未标记数据的混合。因此,专门的半监督学习算法 [...]

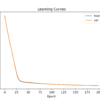

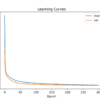

为新数据集开发神经网络预测模型可能具有挑战性。一种方法是首先检查数据集并对可能适用的模型产生想法,然后探索简单模型在数据集上的学习动态,最后开发并调整模型以适应具有稳健 [...] 的数据集。

某些预测问题需要为同一输入同时预测数值和类别标签。一种简单的方法是在同一数据上分别开发回归和分类预测模型,然后顺序使用这些模型。另一种通常更有效的方法是开发一个单一的神经网络模型,该模型可以预测 [...]

迭代局部搜索是一种随机全局优化算法。它涉及对先前找到的良好解决方案的修改版本重复应用局部搜索算法。通过这种方式,它类似于随机重启的随机爬山算法的巧妙版本。该算法背后的直觉是随机重启 [...]

为新数据集开发神经网络预测模型可能具有挑战性。一种方法是首先检查数据集并对可能适用的模型产生想法,然后探索简单模型在数据集上的学习动态,最后开发并调整模型以适应具有稳健 [...] 的数据集。

XGBoost 是梯度提升集成算法的一种强大而有效的实现。配置 XGBoost 模型的超参数可能很棘手,这通常会导致使用大型网格搜索实验,这些实验既耗时又计算成本高昂。配置 XGBoost 模型的另一种方法是评估 [...] 的性能。