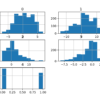

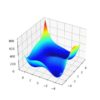

函数优化是一个研究领域,旨在找到一个函数的输入,该输入能够产生函数的最大值或最小值。有大量的优化算法,研究和理解简单易视化的测试函数上的优化算法非常重要。二维函数接受两个 […]

函数优化是一个研究领域,旨在找到一个函数的输入,该输入能够产生函数的最大值或最小值。有大量的优化算法,研究和理解简单易视化的测试函数上的优化算法非常重要。二维函数接受两个 […]

机器学习算法有超参数,可以允许算法针对特定数据集进行定制。虽然超参数的影响可能被普遍理解,但它们对特定数据集的特定影响以及在学习过程中的交互作用可能不为人知。因此,作为机器学习的一部分,调整算法超参数的值非常重要 […]

XGBoost 是梯度提升集成算法的强大且流行的实现。配置 XGBoost 模型的一个重要方面是选择在模型训练期间最小化的损失函数。损失函数必须与预测建模问题类型相匹配,正如我们必须选择适当的 […]

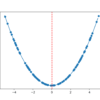

梯度下降是一种优化算法,它沿着目标函数的负梯度方向移动,以找到函数的最小值。梯度下降的一个限制是,如果梯度变得平坦或曲率很大,搜索的进展可能会变慢。可以向梯度下降添加动量, […]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向移动,以找到函数的最小值。梯度下降的一个限制是,它可能会陷入平坦区域,或者如果目标函数返回嘈杂的梯度,则会来回振荡。动量是一种加速 […]

为新数据集开发神经网络预测模型可能具有挑战性。一种方法是首先检查数据集并构思可能适用的模型,然后探索简单模型在该数据集上的学习动态,最后开发并调整一个具有稳健性的模型以适应数据集 […]

Extreme Gradient Boosting (XGBoost) 是一个开源库,它提供了梯度提升算法的高效实现。在开发和初始发布后不久,XGBoost 就成为了一系列机器学习竞赛问题的首选方法,通常是获胜解决方案的关键组成部分。回归预测建模问题涉及预测 […]

盆地跳跃是一种全局优化算法。它被开发用于解决化学物理学中的问题,尽管它是一种适用于具有多个最优解的非线性目标函数的有效算法。在本教程中,您将了解盆地跳跃全局优化算法。完成本教程后,您将知道:盆地跳跃优化是一种全局 […]

函数优化需要选择一个算法来有效地采样搜索空间并找到一个好的或最佳的解决方案。有许多算法可供选择,尽管建立一个基线来了解问题可能或可能存在的解决方案类型很重要。这可以通过使用一个朴素的 […]

用于预测建模的深度学习神经网络模型可能需要更新。这可能是因为自模型开发和部署以来数据发生了变化,或者自模型开发以来已提供了额外的标记数据,并且预计额外的 […]