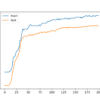

模型平均是一种集成技术,其中多个子模型对组合预测做出相等的贡献。通过根据子模型的预期性能对每个子模型对组合预测的贡献进行加权,可以改进模型平均。通过训练一个全新的模型来学习如何最佳地组合 [...],还可以进一步扩展这一点。

模型平均是一种集成技术,其中多个子模型对组合预测做出相等的贡献。通过根据子模型的预期性能对每个子模型对组合预测的贡献进行加权,可以改进模型平均。通过训练一个全新的模型来学习如何最佳地组合 [...],还可以进一步扩展这一点。

模型平均集成将每个模型的预测平均组合起来,通常比给定的单个模型能获得更好的平均性能。有时我们希望一些非常好的模型对集成预测做出更多贡献,而一些可能有用但应贡献较少的模型 [...]。

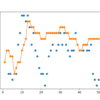

训练数据集相对于未标记示例数量较小的预测建模问题具有挑战性。神经网络可以在这些类型的问题上表现良好,尽管它们可能会受到模型性能高方差的影响,如在训练集或保留验证集上衡量的那样。这使得选择哪个模型 [...]。

集成学习是结合多个模型预测的方法。在集成学习中,组成集成模型是好的并且做出不同的预测错误是很重要的。以不同方式好的预测可以导致一个既更稳定又通常优于任何 [...] 预测的预测。

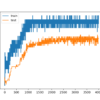

深度学习神经网络模型是高度灵活的非线性算法,能够学习几乎无限数量的映射函数。这种灵活性的一个令人沮丧的地方是最终模型的方差很高。每次在相同数据集上训练的相同神经网络模型都可能找到许多可能的“足够好”的解决方案之一 [...]。

如何通过组合多个模型的预测来提高性能。深度学习神经网络是非线性方法。它们提供了更高的灵活性,并且可以随着可用训练数据的量成比例地扩展。这种灵活性的缺点是它们通过随机训练算法进行学习,这意味着它们对 [...] 很敏感。

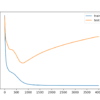

训练一个能够很好地泛化到新数据的深度神经网络是一个具有挑战性的问题。容量过小的模型无法学习问题,而容量过大的模型可以学得太好并导致训练数据集过拟合。这两种情况都会导致模型泛化能力不佳。一个 [...]。

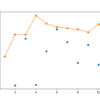

向具有小训练数据集的欠约束神经网络模型添加噪声可以起到正则化的作用并减少过拟合。Keras 通过一个名为 GaussianNoise 的独立层支持添加高斯噪声。此层可用于为现有模型添加噪声。在本教程中,您将发现如何 [...]。

用小数据集训练神经网络可能导致网络记住所.有训练示例,进而导致过拟合和在保留数据集上性能不佳。鉴于高维输入空间中的点采样稀疏或不连续,小数据集也可能代表神经网络学习的更难的映射问题 [...]。

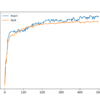

训练神经网络的一个问题是选择训练轮数。过多的轮数会导致训练数据集过拟合,而过少的轮数可能导致模型欠拟合。早停是一种方法,允许您指定任意多的训练轮数 [...]。