为新数据集开发神经网络预测模型可能具有挑战性。一种方法是首先检查数据集并构思可能适用的模型,然后探索简单模型在该数据集上的学习动态,最后为该数据集开发和调整一个具有强大功能的模型 [...]

为新数据集开发神经网络预测模型可能具有挑战性。一种方法是首先检查数据集并构思可能适用的模型,然后探索简单模型在该数据集上的学习动态,最后为该数据集开发和调整一个具有强大功能的模型 [...]

某些预测问题需要为相同的输入同时预测数值和类别标签。一种简单的方法是在相同的数据上分别开发回归和分类预测模型,然后顺序使用这些模型。另一种更有效的方法是开发一个单一的神经网络模型,该模型可以预测 [...]

迭代局部搜索是一种随机全局优化算法。它涉及对先前找到的良好解决方案的修改版本重复应用局部搜索算法。通过这种方式,它类似于一种巧妙的随机爬山算法,带有随机重启。该算法背后的直觉是随机重启 [...]

为新数据集开发神经网络预测模型可能具有挑战性。一种方法是首先检查数据集并构思可能适用的模型,然后探索简单模型在该数据集上的学习动态,最后为该数据集开发和调整一个具有强大功能的模型 [...]

XGBoost 是梯度提升集成算法的一个强大而有效的实现。配置 XGBoost 模型的超参数可能具有挑战性,这通常会导致使用耗时且计算成本高昂的大型网格搜索实验。配置 XGBoost 模型的另一种方法是评估 [...]

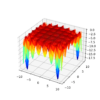

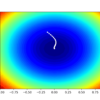

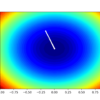

函数优化是研究领域,旨在寻找使函数输出最大或最小的输入。存在大量的优化算法,并且研究和开发在简单且易于可视化的测试函数上的优化算法的直觉非常重要。二维函数需要两个 [...]

机器学习算法具有允许根据特定数据集定制算法的超参数。尽管通常可以理解超参数的影响,但它们在数据集上的特定效果以及它们在学习过程中的相互作用可能不为人知。因此,在机器学习过程的一部分中,调整算法超参数值非常重要 [...]

XGBoost 是梯度提升集成算法的一个强大且流行的实现。配置 XGBoost 模型的一个重要方面是在模型训练过程中最小化的损失函数的选择。损失函数必须与预测建模问题类型相匹配,就像我们必须选择合适的 [...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向前进,以找到函数的最小值。梯度下降的一个限制是,如果梯度变得平坦或曲率很大,搜索进度可能会减慢。动量可以添加到梯度下降中, [...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向前进,以找到函数的最小值。梯度下降的一个限制是,它可能会卡在平坦的区域,或者如果目标函数返回嘈杂的梯度,则会来回震荡。动量是一种加速 [...]