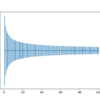

模拟退火是一种随机全局搜索优化算法。这意味着它在搜索过程中使用随机性。这使得该算法适用于其他局部搜索算法效果不佳的非线性目标函数。就像随机爬山局部搜索算法一样,它修改单个解,[...]

模拟退火是一种随机全局搜索优化算法。这意味着它在搜索过程中使用随机性。这使得该算法适用于其他局部搜索算法效果不佳的非线性目标函数。就像随机爬山局部搜索算法一样,它修改单个解,[...]

“没有免费午餐”定理在优化和机器学习领域经常被提及,但人们往往对其含义或暗示理解不足。该定理指出,当所有优化算法在所有可能的问题上进行平均时,它们的表现都 equally。它意味着不存在一个单一的最佳优化 [...]

随机优化是指在目标函数或优化算法中使用随机性。具有挑战性的优化算法,例如高维非线性目标问题,可能包含多个局部最优解,确定性优化算法可能会被卡住。随机优化算法提供了一种替代方法,允许做出不太优的局部决策 [...]

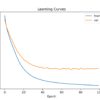

为新数据集开发神经网络预测模型可能具有挑战性。一种方法是首先检查数据集并构思哪些模型可能有效,然后探索简单模型在数据集上的学习动态,最后开发并调整模型以适应数据集,并具有强大的 [...]

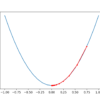

回归模型使用线性回归和局部搜索优化算法在训练数据上进行拟合。像线性回归和逻辑回归这样的模型是通过最小二乘法优化的,这是找到最小化模型误差的系数的最有效方法。尽管如此,也可以使用其他优化算法来拟合 [...]

优化涉及找到目标函数的输入,从而得到函数的最小或最大输出。用于科学计算的开源 Python 库 SciPy 提供了一套优化算法。其中许多算法被用作其他算法的基础,尤其是机器学习算法中的 [...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向搜索,以找到函数的最小值。梯度下降的一个问题是,在具有大量曲率或嘈杂梯度的优化问题上,它可能会在搜索空间中震荡,并且可能会陷入 [...]

在开发深度学习神经网络模型时,权重初始化是一个重要的设计选择。历史上,权重初始化涉及使用小的随机数,尽管在过去十年中,已经开发出更具体的启发式方法,这些方法利用了信息,例如正在使用的激活函数的类型以及节点的输入数量。 [...]

对于初学者来说,关于用于训练深度学习神经网络模型的算法存在很多困惑。人们经常听到神经网络使用“误差反向传播”算法或“随机梯度下降”来学习。有时,这些算法中的任何一个都被用作神经网络拟合方式的简写 [...]

优化是指找到目标函数的输入集,这些输入集可以使目标函数产生最大或最小的输出。通常将优化问题描述为局部优化与全局优化。类似地,将优化算法或搜索算法描述为局部优化与 [...] 也很常见。