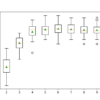

特征选择是识别和选择与目标变量最相关的输入变量子集的过程。也许特征选择最简单的情况是输入变量为数值,目标变量为用于回归预测建模的数值。这是因为两者之间的关系强度[…]

特征选择是识别和选择与目标变量最相关的输入变量子集的过程。也许特征选择最简单的情况是输入变量为数值,目标变量为用于回归预测建模的数值。这是因为两者之间的关系强度[…]

特征选择是识别和选择与目标变量最相关的输入特征子集的过程。在处理实值输入和输出数据时,特征选择通常很简单,例如使用皮尔逊相关系数,但在处理数值输入数据和分类[…]时则可能具有挑战性。

数据集可能包含缺失值,这会给许多机器学习算法带来问题。因此,在对预测任务进行建模之前,最好识别并替换输入数据中每个列的缺失值。这被称为缺失数据插补,或简称插补。一种复杂的处理方法是定义[…]

测试时增强,简称 TTA,是一种提高预测模型技能的技术。它通常用于提高深度学习模型在图像数据集上的预测性能,在这种情况下,会计算测试数据集中每个图像的多个增强版本的平均预测值。尽管在图像数据集和神经网络[…]中很受欢迎

在预测建模任务中,输入特征之间经常以出乎意料且通常是非线性的方式相互作用。这些交互作用可以被学习算法识别和建模。另一种方法是创建新特征来暴露这些交互作用,看看它们是否能提高模型性能。此外,像将输入变量提高到某个幂次的变换[…]

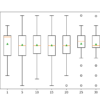

许多机器学习算法在数值输入变量被缩放到标准范围时表现更好。这包括使用输入加权和的算法,如线性回归,以及使用距离度量的算法,如 K 最近邻。标准化是一种流行的缩放技术,它从值中减去均值并除以[…]

递归特征消除,简称 RFE,是一种流行的特征选择算法。RFE 流行是因为它易于配置和使用,并且能有效地从训练数据集中选择在预测目标变量方面更相关或最相关的特征(列)。有两个重要的配置选项[…]

数值输入变量可能具有高度偏斜或非标准化的分布。这可能是由于数据中的异常值、多峰分布、高度指数分布等原因造成的。许多机器学习算法在数值输入变量具有标准概率分布时更喜欢或表现更好。离散化变换提供了一种自动改变数值[…]

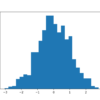

数值输入变量可能具有高度偏斜或非标准化的分布。这可能是由于数据中的异常值、多峰分布、高度指数分布等原因造成的。许多机器学习算法在数值输入变量甚至回归情况下的输出变量具有标准概率分布时更喜欢或表现更好,例如[…]

像线性回归和高斯朴素贝叶斯这样的机器学习算法假定数值变量具有高斯概率分布。你的数据可能没有高斯分布,而是具有类似高斯的分布(例如,接近高斯但带有异常值或偏斜)或完全不同的分布(例如,指数分布)。因此,你可能需要[…]