深度学习神经网络模型的容量控制着它能够学习的映射函数类型的范围。容量过小的模型无法学习训练数据集,这意味着它将欠拟合;而容量过大的模型可能会记住训练数据集,这意味着它将过拟合 […]

深度学习神经网络模型的容量控制着它能够学习的映射函数类型的范围。容量过小的模型无法学习训练数据集,这意味着它将欠拟合;而容量过大的模型可能会记住训练数据集,这意味着它将过拟合 […]

像 Keras 这样的现代深度学习库允许您在几分钟内用几行代码定义并开始拟合各种神经网络模型。然而,为新的预测建模问题配置神经网络以获得良好性能仍然具有挑战性。获得良好性能的挑战 […]

深度学习神经网络的一个有趣好处是它们可以在相关问题上重复使用。迁移学习是指一种用于在不同但某种程度上相似的问题上进行预测建模的技术,然后可以部分或全部重复使用以加速训练并提高模型在该问题上的性能 […]

鉴于误差函数、学习率甚至目标变量尺度的选择,神经网络的训练可能会变得不稳定。训练期间对权重的巨大更新可能导致数值溢出或下溢,通常被称为“梯度爆炸”。梯度爆炸问题在循环神经网络中更常见,例如 […]

深度学习神经网络从训练数据集中的示例学习如何将输入映射到输出。模型的权重被初始化为小的随机值,并通过优化算法根据训练数据集上的误差估计进行更新。考虑到模型中使用的小权重以及 […]

训练深度神经网络传统上具有挑战性,因为梯度消失意味着靠近输入层的权重没有根据训练数据集上计算的误差进行更新。贪婪逐层预训练是深度学习领域的一项创新和重要里程碑,它允许非常深的神经网络 […]

深度学习神经网络使用随机梯度下降优化算法进行训练。作为优化算法的一部分,必须反复估计模型当前状态的误差。这需要选择一个误差函数,通常称为损失函数,可用于估计模型的损失 […]

神经网络使用随机梯度下降进行训练,在设计和配置模型时需要选择一个损失函数。有许多损失函数可供选择,并且很难知道如何选择,甚至不知道损失函数是什么以及它在训练模型时扮演的角色 […]

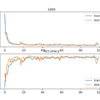

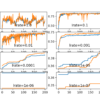

深度学习神经网络使用随机梯度下降优化算法进行训练。学习率是一个超参数,它控制每次更新模型权重时,模型响应估计误差的变化程度。选择学习率具有挑战性,因为值过小可能导致 […]

神经网络的权重无法使用分析方法计算。相反,权重必须通过称为随机梯度下降的经验优化过程发现。随机梯度下降解决的神经网络优化问题具有挑战性,解空间(权重集)可能包含许多好的 […]