Fbeta 分数是一种可配置的单一分数指标,用于根据对正类的预测来评估二元分类模型。Fbeta 分数使用精确率和召回率计算。精确率是一种计算正类正确预测百分比的指标。召回率计算正类正确预测的百分比……

Fbeta 分数是一种可配置的单一分数指标,用于根据对正类的预测来评估二元分类模型。Fbeta 分数使用精确率和召回率计算。精确率是一种计算正类正确预测百分比的指标。召回率计算正类正确预测的百分比……

许多不平衡分类任务需要一个能够预测清晰类别标签的熟练模型,其中两个类别同等重要。在需要类别标签且两个类别同等重要的情况下,不平衡分类问题的一个例子是卫星图像中的漏油或油污检测。漏油的检测……

开发概率模型通常具有挑战性,尽管当案例分布不均时,即所谓的“不平衡数据集”,这一挑战会更大。Haberman 数据集描述了 20 世纪 50 年代和 60 年代乳腺癌患者的五年或更长的生存率,其中大部分患者都存活下来。……

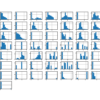

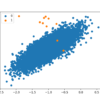

不平衡分类作为预测建模任务具有挑战性,主要是由于类别分布严重失衡。这是传统机器学习模型和假设类别分布均衡的评估指标表现不佳的原因。尽管如此,分类数据集还有一些其他特性,这些特性不仅对预测建模提出了挑战……

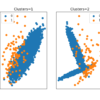

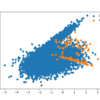

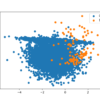

异常值或离群点是与数据其余部分不符的罕见样本。识别数据中的异常值称为异常值或离群点检测,而专注于此问题的机器学习子领域称为单类分类。这些是无监督学习算法,试图构建“正常”……

Bagging 是一种集成算法,它在训练数据集的不同子集上训练多个模型,然后将所有模型的预测结合起来。随机森林是 bagging 的扩展,它还随机选择每个数据样本中使用的特征子集。Bagging 和随机森林在各种……方面都已被证明是有效的。

分类预测建模通常涉及预测类别标签。尽管如此,许多机器学习算法都能够预测类成员的概率或得分,并且在将其映射到清晰的类别标签之前必须对其进行解释。这通过使用阈值(例如 0.5)来实现,所有值等于或……

大多数机器学习算法都假设模型的所有误分类错误都是相等的。对于不平衡分类问题,情况通常并非如此,在这种问题中,漏掉一个正类或少数类样本比错误地将一个样本从负类或多数类中分类更糟糕。有很多现实世界的例子,例如检测垃圾邮件……

XGBoost 算法对广泛的回归和分类预测建模问题都有效。它是随机梯度提升算法的一个高效实现,并提供了一系列超参数,可以对模型训练过程进行精细控制。尽管该算法通常表现良好,即使在不平衡分类数据集上,它……

深度学习神经网络是一类灵活的机器学习算法,在各种问题上表现良好。神经网络使用误差反向传播算法进行训练,该算法包括计算模型在训练数据集上产生的误差,并根据这些误差的比例更新模型权重。局限性……