模型评估涉及使用可用数据集来拟合模型并估算其在对看不见的示例进行预测时的性能。这是一个具有挑战性的问题,因为用于拟合模型的训练数据集和用于评估模型的测试集都必须足够大,并且能够充分代表潜在问题,因此 [...]

模型评估涉及使用可用数据集来拟合模型并估算其在对看不见的示例进行预测时的性能。这是一个具有挑战性的问题,因为用于拟合模型的训练数据集和用于评估模型的测试集都必须足够大,并且能够充分代表潜在问题,因此 [...]

分类预测建模涉及为示例预测类标签,尽管某些问题需要预测类别成员的概率。对于这些问题,不需要清晰的类标签,而是需要每个示例属于每个类的可能性,然后进行解释。因此,小的相对概率可以携带 [...]

分类器的优劣取决于用于评估它的指标。如果您选择错误的指标来评估您的模型,您很可能会选择一个糟糕的模型,或者在最坏的情况下,对模型的预期性能产生误解。在应用的机器学习中,选择一个合适的指标通常具有挑战性 [...]

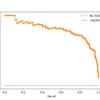

大多数不平衡分类问题涉及两个类别:负例(大多数示例)和正例(少数示例)。ROC 曲线和精确率-召回率曲线是帮助解释二元(两类)分类预测模型的两个诊断工具。可以创建曲线图并用于理解 [...]

分类准确率是正确预测的总数除以数据集上进行的预测总数。作为性能度量,准确率不适用于不平衡分类问题。主要原因是占绝大多数的类别(或类别)中的示例数量会压倒性地超过 [...] 中的示例数量。

分类准确率是一种度量,它将分类模型的性能概括为正确预测的数量除以预测总数。它易于计算且易于理解,使其成为评估分类器模型最常用的度量。当示例的分布 [...] 时,这种直觉就失效了。

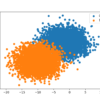

不平衡分类问题是指在预测类标签时,训练数据集中类标签分布不均衡的问题。许多现实世界的分类问题都存在类别分布不平衡的情况,因此机器学习从业者熟悉处理这些类型的问题非常重要。在本教程中 [...]

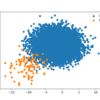

不平衡分类问题是指在预测类标签时,训练数据集中类标签的分布不相等的。初学者在处理不平衡分类问题时面临的一个挑战是,特定的倾斜类分布意味着什么。例如,1:10 与 [...] 之间的区别和影响是什么?

分类是预测建模问题,涉及为给定示例预测类标签。通常假定训练数据集中示例的分布在所有类别中是均匀的。在实践中,这很少是这种情况。那些类别标签中的示例分布 [...] 的分类预测模型。

分类预测建模涉及为给定观测值预测类标签。不平衡分类问题是分类问题的一个例子,其中已知类别中的示例分布存在偏差或倾斜。分布可以从轻微偏差到严重不平衡,其中 [...] 中有一个示例。