LSTM自编码器是一种使用编码器-解码器LSTM架构实现的序列数据自编码器。一旦拟合完成,模型的编码器部分可用于编码或压缩序列数据,这些数据反过来又可用于数据可视化或作为监督学习模型的特征向量输入。在 [...]

LSTM自编码器是一种使用编码器-解码器LSTM架构实现的序列数据自编码器。一旦拟合完成,模型的编码器部分可用于编码或压缩序列数据,这些数据反过来又可用于数据可视化或作为监督学习模型的特征向量输入。在 [...]

梯度爆炸是指在训练过程中,巨大的误差梯度累积,导致神经网络模型权重更新过大的问题。这会导致你的模型不稳定,无法从训练数据中学习。在这篇文章中,你将了解深度人工神经 [...] 中梯度爆炸的问题。

教师强制是一种快速高效地训练循环神经网络模型的方法,它使用前一个时间步的真实值(ground truth)作为输入。这种网络训练方法对于开发深度学习语言模型至关重要,这些模型被用于机器翻译、文本摘要、图像字幕等众多应用中。在 [...]

编码器-解码器模型为使用循环神经网络解决具有挑战性的序列到序列预测问题(如机器翻译)提供了一种模式。编码器-解码器模型可以在Keras Python深度学习库中开发,Keras博客上已描述了一个使用此模型开发的神经机器翻译系统示例,并提供了示例 [...]

编码器-解码器模型为使用循环神经网络解决具有挑战性的序列到序列预测问题(如机器翻译)提供了一种模式。注意力机制是编码器-解码器模型的扩展,可以提高该方法在处理更长序列时的性能。全局注意力是注意力机制的一种简化,可能更容易在声明式深度 [...] 中实现。

Keras深度学习库提供了长短期记忆(LSTM)循环神经网络的实现。作为此实现的一部分,Keras API提供了对返回序列(return sequences)和返回状态(return state)的访问。在设计复杂的循环神经网络模型时,例如[...],这些数据的使用和区别可能会令人困惑。

循环神经网络的编码器-解码器架构在自然语言处理领域的众多序列到序列预测问题上表现出强大的能力。注意力机制解决了编码器-解码器架构在处理长序列时的局限性,并且通常能够加速学习并提升 [...] 的技能。

循环神经网络的编码器-解码器架构在自然语言处理领域的众多序列到序列预测问题上(如机器翻译和字幕生成)表现出强大的能力。注意力机制解决了编码器-解码器架构在处理长序列时的局限性,并且通常能够加速 [...]

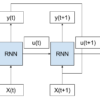

循环神经网络是一种将前一时间步的输出作为当前时间步输入的神经网络。这会创建带有循环的网络图或电路图,从而可能难以理解信息在网络中是如何流动的。在这篇文章中,你将了解 [...]

序列预测不同于其他类型的监督学习问题。序列对观测值施加了顺序,在训练模型和进行预测时必须保留这种顺序。通常,涉及序列数据的预测问题被称为序列预测问题,尽管有一系列问题因 [...] 的不同而有所差异。