本文提供了一份全面的分步指南,旨在帮助您应对为生产环境优化机器学习(ML)模型的挑战。它着眼于模型开发生命周期的所有阶段,即模型部署到生产环境之前、期间和之后。本指南以一种与模型和机器学习技术无关的口吻编写,[...]

本文提供了一份全面的分步指南,旨在帮助您应对为生产环境优化机器学习(ML)模型的挑战。它着眼于模型开发生命周期的所有阶段,即模型部署到生产环境之前、期间和之后。本指南以一种与模型和机器学习技术无关的口吻编写,[...]

机器学习优化速成课程。在7天内用Python找到函数最优解。所有机器学习模型都涉及优化。作为从业者,我们为最合适的超参数或特征子集进行优化。决策树算法为分裂点进行优化。神经网络为权重进行优化。我们很可能使用计算算法来[...]

粒子群优化(PSO)是受生物启发的算法之一,它是一种在解空间中搜索最优解的简单算法。它与其他优化算法的不同之处在于,它只需要目标函数,并且不依赖于梯度或任何微分[...]

差分进化是一种用于非线性和不可微连续空间函数全局优化的启发式方法。差分进化算法属于更广泛的进化计算算法家族。与其他流行的直接搜索方法(如遗传算法和进化策略)类似,差分进化算法从一个初始种群开始[...]

本教程介绍了数据科学和自动化学习中的两个基本概念。一个是机器学习流水线,第二个是其优化。这两个原则是实现任何基于机器学习的成功智能系统的关键。机器学习流水线可以通过将所涉及的一系列步骤组合在一起来创建[...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向寻找函数的最小值。梯度下降的一个局限性是它对每个输入变量使用相同的步长(学习率)。这在目标函数具有不同数量的情况下可能成为一个问题[...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向寻找函数的最小值。梯度下降的一个局限性是,所有输入变量都使用单一的步长(学习率)。像自适应矩估计(Adam)算法这样对梯度下降的扩展[...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向寻找函数的最小值。梯度下降的一个局限性是,所有输入变量都使用单一的步长(学习率)。像自适应矩估计(Adam)算法这样对梯度下降的扩展[...]

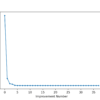

收敛指的是一个过程的极限,在评估优化算法的预期性能时,它可以是一个有用的分析工具。在探索优化算法的学习动态,以及使用优化算法训练的机器学习算法(如深度学习神经网络)时,它也可以是一个有用的经验工具[...]

机器学习涉及使用一种算法从历史数据中学习和泛化,以便对新数据进行预测。这个问题可以被描述为逼近一个将输入示例映射到输出示例的函数。逼近一个函数可以通过将问题框架化为函数优化来解决。这就是[...]