函数优化是一个基础研究领域,其技术几乎应用于所有量化领域。重要的是,函数优化是几乎所有机器学习算法和预测建模项目的核心。因此,理解函数优化是什么、该领域的术语以及构成 [...] 的要素至关重要。

函数优化是一个基础研究领域,其技术几乎应用于所有量化领域。重要的是,函数优化是几乎所有机器学习算法和预测建模项目的核心。因此,理解函数优化是什么、该领域的术语以及构成 [...] 的要素至关重要。

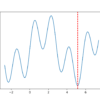

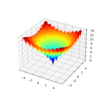

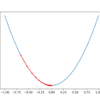

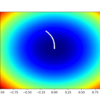

函数优化是一个研究领域,它寻求一个函数的输入,该输入会导致函数输出的最大值或最小值。有大量的优化算法,在简单易于可视化的测试函数上研究和培养对优化算法的直觉非常重要。单变量函数需要 [...]

线搜索是一种优化算法,可用于具有一个或多个变量的目标函数。它提供了一种方法,通过使用搜索来从已知点定位多变量目标函数中的最优步长,从而使用单变量优化算法,如二分查找 [...]

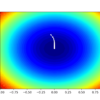

梯度下降是一种优化算法,它沿着目标函数的负梯度方向移动,以找到函数的最小值。梯度下降的一个限制是它对每个输入变量使用相同的步长(学习率)。AdaGrad(简称)是梯度下降优化算法的扩展 [...]

双退火是一种随机全局优化算法。它是广义退火算法的实现,广义退火算法是退火算法的扩展。此外,它还与一个在模拟退火过程结束时自动执行的局部搜索算法配对。这种有效的全局和局部搜索过程的结合提供了 [...]

Broyden, Fletcher, Goldfarb, and Shanno (BFGS) 算法是一种局部搜索优化算法。它是一种二阶优化算法,意味着它利用目标函数的二阶导数,并属于一类称为拟牛顿法的方法,这些方法近似二阶导数(称为 [...]

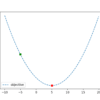

梯度下降是一种优化算法,它沿着目标函数的负梯度方向移动,以找到函数的最小值。这是一种简单有效的技术,只需几行代码即可实现。它也为许多扩展和修改提供了基础,这些扩展和修改可以产生 [...]

梯度是优化和机器学习中常用的术语。例如,深度学习神经网络通过随机梯度下降进行拟合,许多用于拟合机器学习算法的标准优化算法使用梯度信息。为了理解梯度是什么,您需要理解导数是什么 [...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向移动,以找到函数的最小值。梯度下降的一个限制是它对每个输入变量使用相同的步长(学习率)。AdaGradn 和 RMSProp 是梯度下降的扩展,它们添加了自适应 [...]

迭代局部搜索是一种随机全局优化算法。它涉及对先前找到的较好解决方案的修改版本重复应用局部搜索算法。这样,它就像一个智能版的带有随机重启的随机爬山算法。该算法的直觉是随机重启 [...]