“没有免费午餐”定理在优化和机器学习领域经常被提及,但往往对其含义或启示知之甚少。该定理指出,当针对所有可能的问题平均性能时,所有优化算法的表现都一样好。它意味着没有一个单一的最佳优化 [...]

“没有免费午餐”定理在优化和机器学习领域经常被提及,但往往对其含义或启示知之甚少。该定理指出,当针对所有可能的问题平均性能时,所有优化算法的表现都一样好。它意味着没有一个单一的最佳优化 [...]

随机优化是指在目标函数或优化算法中使用随机性。具有挑战性的优化算法,例如高维非线性目标问题,可能包含多个局部最优解,而确定性优化算法可能会陷入其中。随机优化算法提供了一种替代方法,该方法允许做出不太理想的局部决策 [...]

回归模型使用线性回归和局部搜索优化算法在训练数据上进行拟合。线性回归和逻辑回归等模型通过最小二乘优化进行训练,这是找到最小化模型误差的系数的最有效方法。尽管如此,仍有可能使用替代优化算法来拟合 [...]

优化涉及找到目标函数的输入,这些输入导致函数输出的最小值或最大值。名为 SciPy 的开源科学计算 Python 库提供了一套优化算法。其中许多算法被用作其他算法的基础,尤其是机器学习算法 [...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向前进,以找到函数的最小值。梯度下降的一个问题是,对于具有大量曲率或噪声梯度的优化问题,它可能会在搜索空间中来回震荡,并且可能陷入 [...]

优化是指找到目标函数的输入集,这些输入会导致目标函数的最大值或最小值。通常用局部优化与全局优化的方式来描述优化问题。类似地,也经常用局部与 [...] 来描述优化算法或搜索算法。

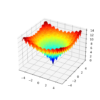

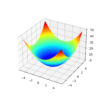

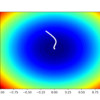

Nelder-Mead 优化算法是用于非可微目标函数的一种广泛使用的方法。因此,它通常被称为模式搜索算法,并用作局部或全局搜索过程,用于解决具有挑战性的非线性、可能嘈杂且多峰的函数优化问题。在本教程中,您将了解 Nelder-Mead 优化算法。 [...]

函数优化涉及找到导致目标函数最优值的输入。优化算法在搜索空间中导航输入变量,以定位最优解,而目标函数的形状和算法在搜索空间中的行为在实际问题中是不透明的。因此, [...]

梯度下降是一种优化算法,它沿着目标函数的负梯度方向前进,以找到函数的最小值。梯度下降的一个限制是,所有输入变量都使用相同的步长(学习率)。像 AdaGrad 和 RMSProp 这样的梯度下降扩展会更新该算法以 [...]

优化是数学的一个领域,涉及在众多候选解中寻找一个好的或最佳的解。它是机器学习所需的一个重要基础主题,因为大多数机器学习算法都使用优化算法在历史数据上进行拟合。此外,更广泛的问题,例如模型选择和超参数调优,也可以被构建为 [...]