结合XGBoost与嵌入:混合语义提升树?

图片由编辑 | Perplexity 提供

传统机器学习与现代表示学习的交叉正在开辟新的可能性。其中,将 XGBoost 与嵌入相结合已成为一种有前途的混合方法。**XGBoost** 因其在结构化数据上的性能和可解释性而受到广泛赞誉。另一方面,**嵌入**在捕捉文本、图像和分类变量等非结构化数据中的深层语义关系方面表现出色。

通常,这两种方法是分开使用的。但如果我们能将它们结合起来呢?

**混合语义增强树**正是这样做的。它们使用嵌入将非结构化数据转换为丰富、有意义的向量,然后将这些向量输入 XGBoost。这样,模型就能理解数据中的深层模式,同时仍然保持快速和可解释。

本文探讨了这种混合策略的动机、方法论和实际应用。

为什么使用 XGBoost 结合嵌入?

通过将嵌入集成到 XGBoost 中,我们可以获得几个优势:

- 增强的特征表示:嵌入可以捕捉非结构化数据中手动特征工程可能忽略的复杂模式和连接。

- 改进的预测能力:用嵌入增强表格特征可以提高模型准确性,尤其是在文本或视觉上下文相关的任务中。

- 模块化和灵活性:嵌入可以使用深度学习模型(如文本的 BERT 或图像的 ResNet)进行预训练,然后集成到下游的 XGBoost 模型中。

- 可解释性:深度学习模型很难理解,但将它们与 XGBoost 一起使用可以让您使用 SHAP 等工具来查看不同特征如何影响预测。

如何构建混合语义增强树

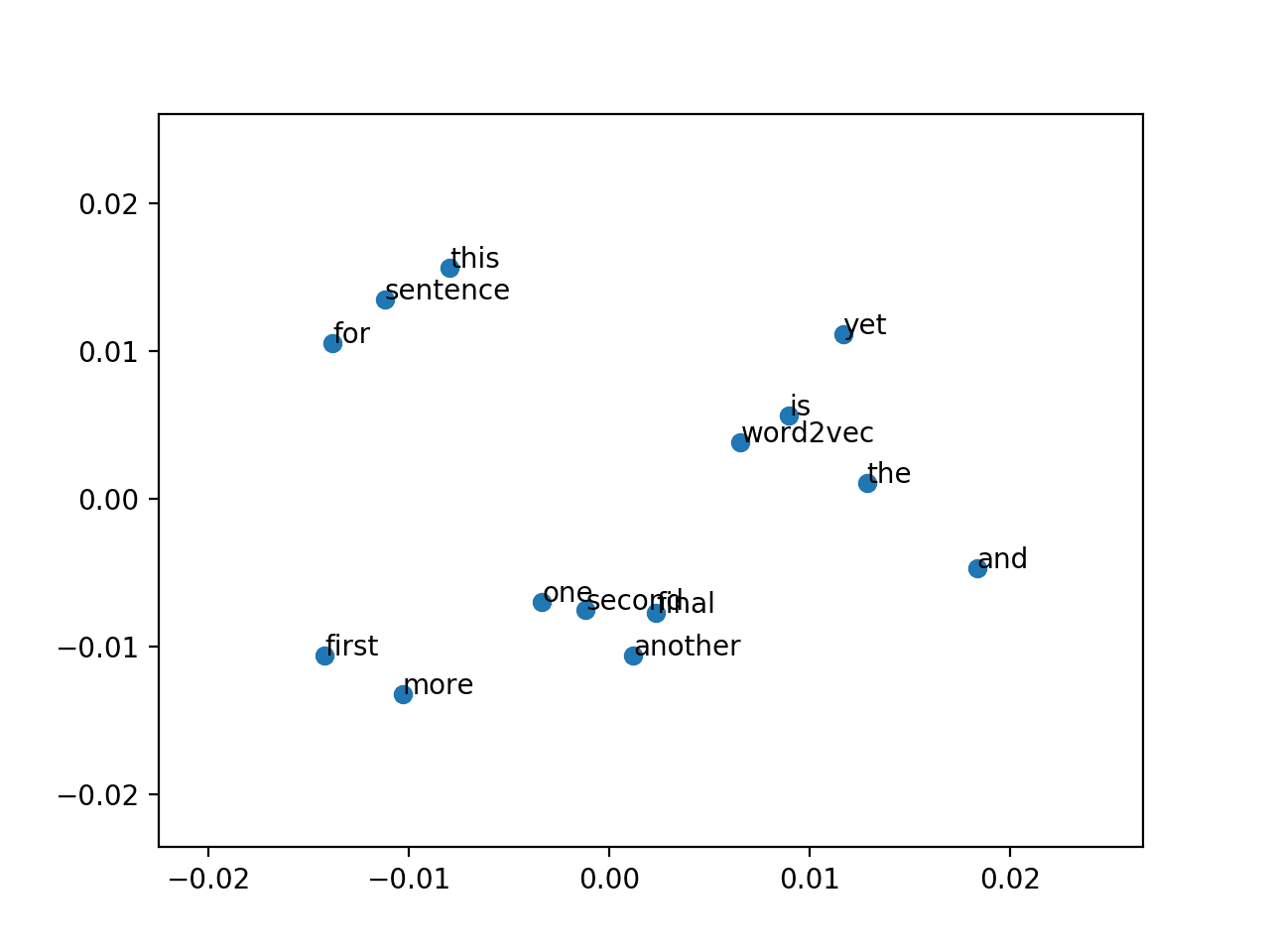

步骤 1:生成语义嵌入

使用词嵌入(Word2Vec、GloVe)、句子转换器(Sentence-BERT)或预训练语言模型等技术,将语义字段转换为密集数值向量。对于分类特征,生成实体嵌入或将值映射到外部知识图谱。

|

1 2 3 4 |

from sentence_transformers import SentenceTransformer model = SentenceTransformer('all-MiniLM-L6-v2') embeddings = model.encode(list_of_sentences) |

这将生成一个形状为 (num_samples, embedding_dim) 的矩阵,其中每一行都是一个嵌入向量。

步骤 2:与结构化数据集成

将语义向量与原始结构化数据合并,形成统一的特征集。如果维度过高,请应用 PCA 或 UMAP 等技术来减小尺寸,同时保留重要信息。

|

1 2 3 4 5 6 7 8 9 10 11 |

导入 pandas 为 pd import numpy as np # 表格数据 X_structured = pd.read_csv("structured_data.csv") # 文本/图像嵌入 X_embeddings = np.load("embeddings.npy") # 合并两者 X_combined = np.hstack((X_structured.values, X_embeddings)) |

确保保留结构化数据和嵌入之间行的对齐。

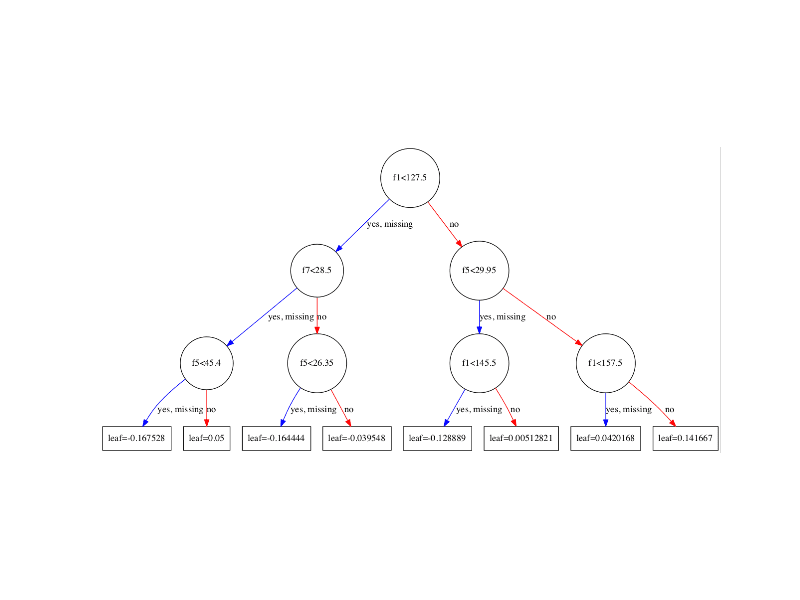

步骤 3:训练 XGBoost 模型

准备好混合特征矩阵后,现在可以训练 XGBoost 分类器或回归器了。

|

1 2 3 4 5 6 7 8 9 10 |

import xgboost as xgb dtrain = xgb.DMatrix(X_combined, label=y) params = { 'objective': 'binary:logistic', 'max_depth': 6, 'eta': 0.1, 'eval_metric': 'auc' } bst = xgb.train(params, dtrain, num_boost_round=100) |

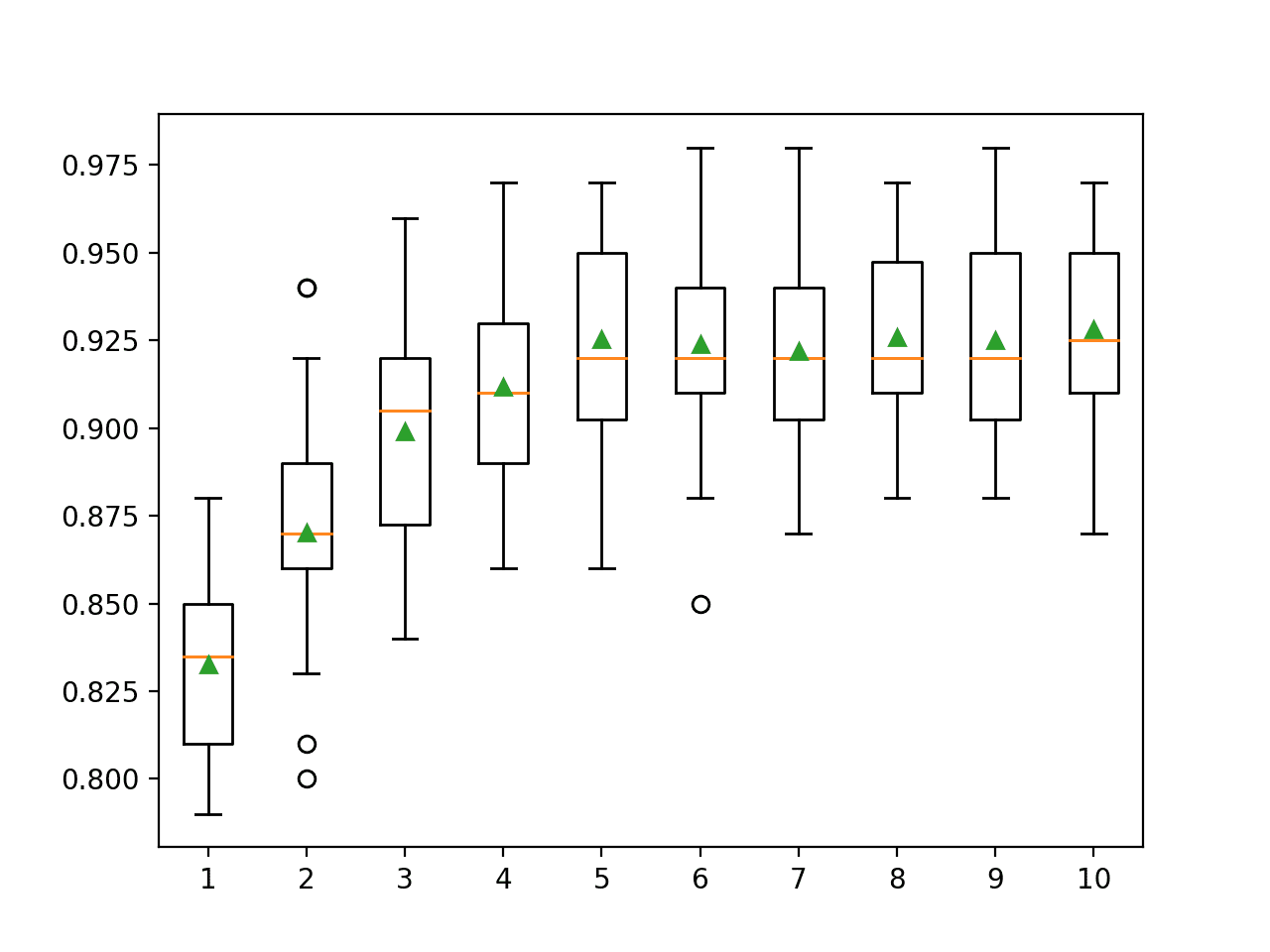

您可以使用交叉验证或 GridSearchCV 等调优策略来优化性能。

步骤 4:解释模型输出

使用 SHAP 值来解释模型预测,包括来自嵌入维度的贡献。

|

1 2 3 4 5 6 |

import shap explainer = shap.Explainer(bst) shap_values = explainer(X_combined) shap.summary_plot(shap_values, features=X_combined) |

这有助于我们理解嵌入的哪些部分对模型的预测影响最大。

用例

这种混合建模方法可以应用于广泛的潜在领域,包括以下领域:

- 客户支持自动化:通过将工单描述的文本嵌入与客户级别、产品类型和紧急程度等结构化元数据相结合,对客户支持工单进行分类和路由。

- 医疗保健预测建模:通过将临床记录中的嵌入与结构化健康记录相结合,预测患者的诊断、再入院风险或治疗结果。

- 欺诈检测:通过将交易描述或用户评论(文本嵌入)与交易金额、位置和频率等结构化特征相结合,检测异常或欺诈性交易。

- 电子商务推荐:在价格、类别和用户行为数据之外,利用产品描述或客户评论来改进推荐引擎。

挑战与考虑

虽然将嵌入与 XGBoost 结合具有优势,但也带来了一些需要管理的挑战:

- 维度:大型模型(例如 BERT)的嵌入可能具有高维度。将此类向量直接输入 XGBoost 可能导致过拟合和训练时间增加。在适当的情况下,应用降维(例如 PCA、UMAP)或特征选择技术。

- 过拟合风险:嵌入可能包含冗余或噪声信息,尤其是在未进行微调的情况下。XGBoost 中的正则化(例如 L1/L2 惩罚)、仔细验证和提前停止对于减轻此风险至关重要。

- 计算成本:从 BERT 或 CLIP 等大型模型生成嵌入可能耗时且资源密集。使用轻量级模型(例如 DistilBERT、MiniLM)或预先计算并缓存嵌入。

- 模型兼容性:XGBoost 期望输入为平坦表格格式的数值。确保正确连接嵌入和结构化特征,并正确对齐样本顺序和数据类型。

最佳实践

为了充分利用结合嵌入和 XGBoost 的混合方法,请考虑以下最佳实践:

- 标准化嵌入:嵌入向量的大小可能不同。对它们进行标准化,以确保跨维度的贡献一致。

- 降维:在将高维嵌入(尤其是来自 BERT 等大型模型的嵌入)输入 XGBoost 之前,使用 PCA、UMAP 或自动编码器进行降维。这可以提高速度和泛化能力。

- 交叉验证:始终使用交叉验证来验证模型,以确保性能提升不是由于特定训练/测试分割的过拟合。

总结

将嵌入与 XGBoost 集成,弥合了深度学习捕获复杂语义模式的能力与梯度提升在结构化数据建模和可解释性方面的优势之间的差距。通过将文本或图像等非结构化输入转换为密集向量,并将其与传统表格特征相结合,我们创建了一种混合模型,其性能可能优于任一单独的方法。

虽然存在维度和计算成本等挑战,但可以通过预处理、降维和严格验证来管理。最终,这种方法使从业者能够利用从医疗保健到金融等各个领域的丰富语义信息。

暂无评论。