如何诊断您的分类模型为何失败

图片由 Editor | ChatGPT 提供

引言

在分类模型中,失败发生于模型将错误的类别分配给新的数据观测时;换言之,当其分类准确率在一定预测数量上不够高时。当训练好的分类器在与它训练时使用的示例不同的新数据上泛化能力不佳时,也会出现这种情况。虽然模型失败通常以多种形式出现,包括上述形式,但根本原因有时可能更加多样化且微妙。

本文探讨了分类模型表现不佳的一些常见原因,并概述了如何检测、诊断和减轻这些问题。

分类模型的诊断要点

让我们探讨分类模型失败的一些常见原因,逐一概述并提供实用的诊断技巧。

1. 分析性能指标和混淆矩阵

您刚刚训练好了一个模型,使用单个性能指标(如准确率)在测试数据上对其进行了评估,发现正确预测的百分比不够高。虽然这是您的分类器可能未达到最佳工作状态的最明显迹象,但仅依赖准确率可能会产生误导,尤其是在诊断模型表现不佳的根本原因时。对于不平衡数据集而言,这一点更是如此,我们稍后会详细解释。

通过分析评估指标诊断模型的关键操作包括:

- 使用并理解一组分类指标 — 主要是精确率(precision)、召回率(recall)和 F1 分数(f1-score),它结合了前两者。为了更直观地了解模型的性能,ROC-AUC 是另一个值得考虑的指标。根据问题的性质以及不同类型分类错误(如假阳性与假阴性)的成本,您会优先考虑某个指标。

- 混淆矩阵有助于按类别查看分类性能。同样,Python 的 scikit-learn 库提供了一个名为

classification_report()的函数,该函数还会自动计算每个类别的精确率、召回率和 F1 分数,让您一目了然地了解数据集中哪些类别的性能优于其他可能更“棘手”需要正确分类的类别。 - 缓解性能问题的可能方法包括调整分类阈值、提高用于构建模型的训练数据的质量,或微调模型的超参数设置。

2. 检查类别不平衡

某些现实世界的数据集,例如描述信用卡交易或罕见疾病诊断数据的,天然呈现出一种称为类别不平衡的现象:绝大多数数据属于特定类别,其余的少数属于其他类别。从统计学角度来看,数据中存在高度倾斜的类别分布,这可能导致训练好的分类器在其预测中过度偏向多数类,使其几乎无法识别与少数类相关的相对不常见的案例。

要诊断此问题,首先检查您的类别频率分布,以确定是否存在类别不平衡,并仔细分析前面讨论的每个类别的性能指标。

更具体的补救措施包括使用 SMOTE 等过采样技术来解决不平衡问题、欠采样、类别加权以赋予与少数类相关的错误分类更大的重要性,或为这些类别收集更多数据。精确率-召回率曲线是分析不平衡数据分类器性能的另一种有用可视化工具。

仅依赖分类模型的准确率可能会产生误导,尤其是在诊断其表现不佳的根本原因时。

3. 检查数据质量和特征相关性

差劲的数据质量通常是机器学习模型表现不佳的主要原因,分类器也不例外。因此,一个重要的诊断点是分析输入模型(用于训练和测试)的数据质量。

使用诸如探索性数据分析(EDA)之类的方法,检查缺失值及其出现的频率。识别可能不相关且可以移除的特征—在此可以使用基于特征重要性的模型可解释性工具。您还应该检查标签分配不正确、数值特征的缩放问题,或者根本不适合模型类型或部署环境的数据。

总而言之,请确保特征工程和数据清理及验证过程都与当前的预测任务紧密对齐。

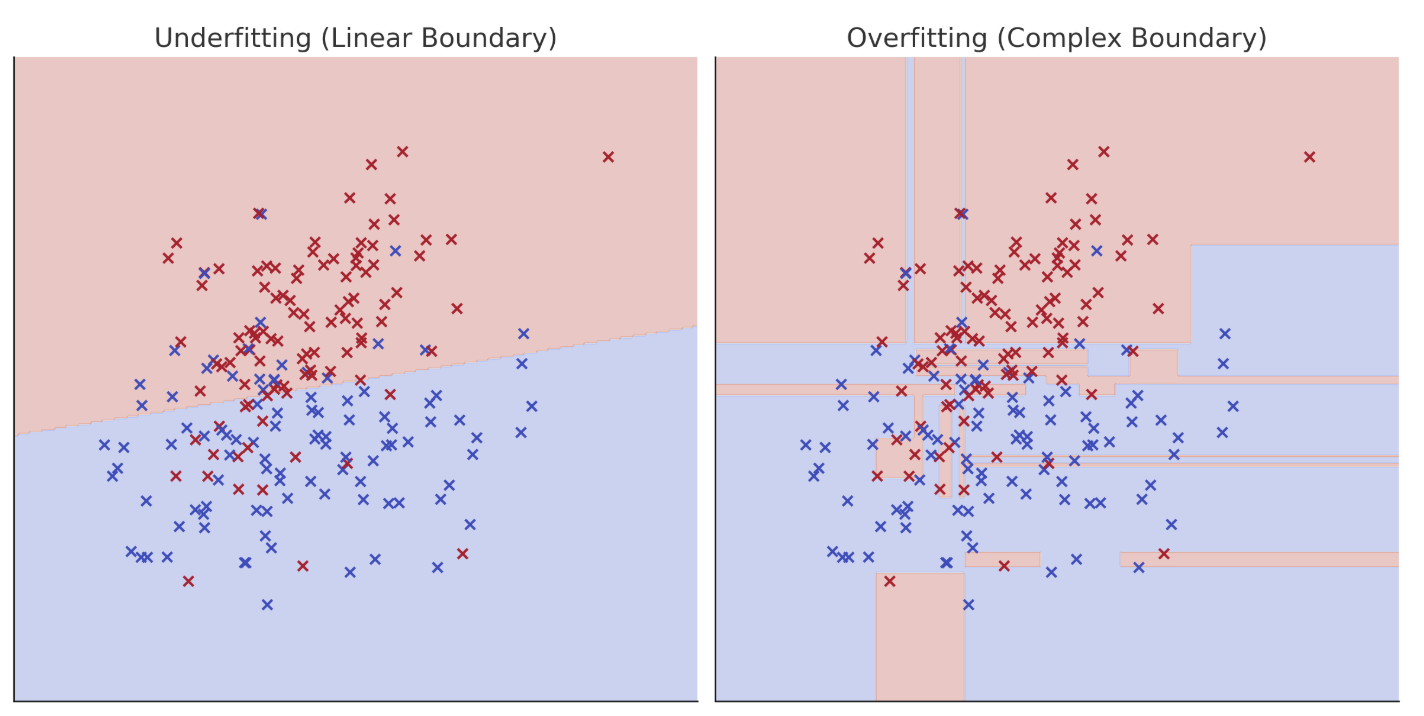

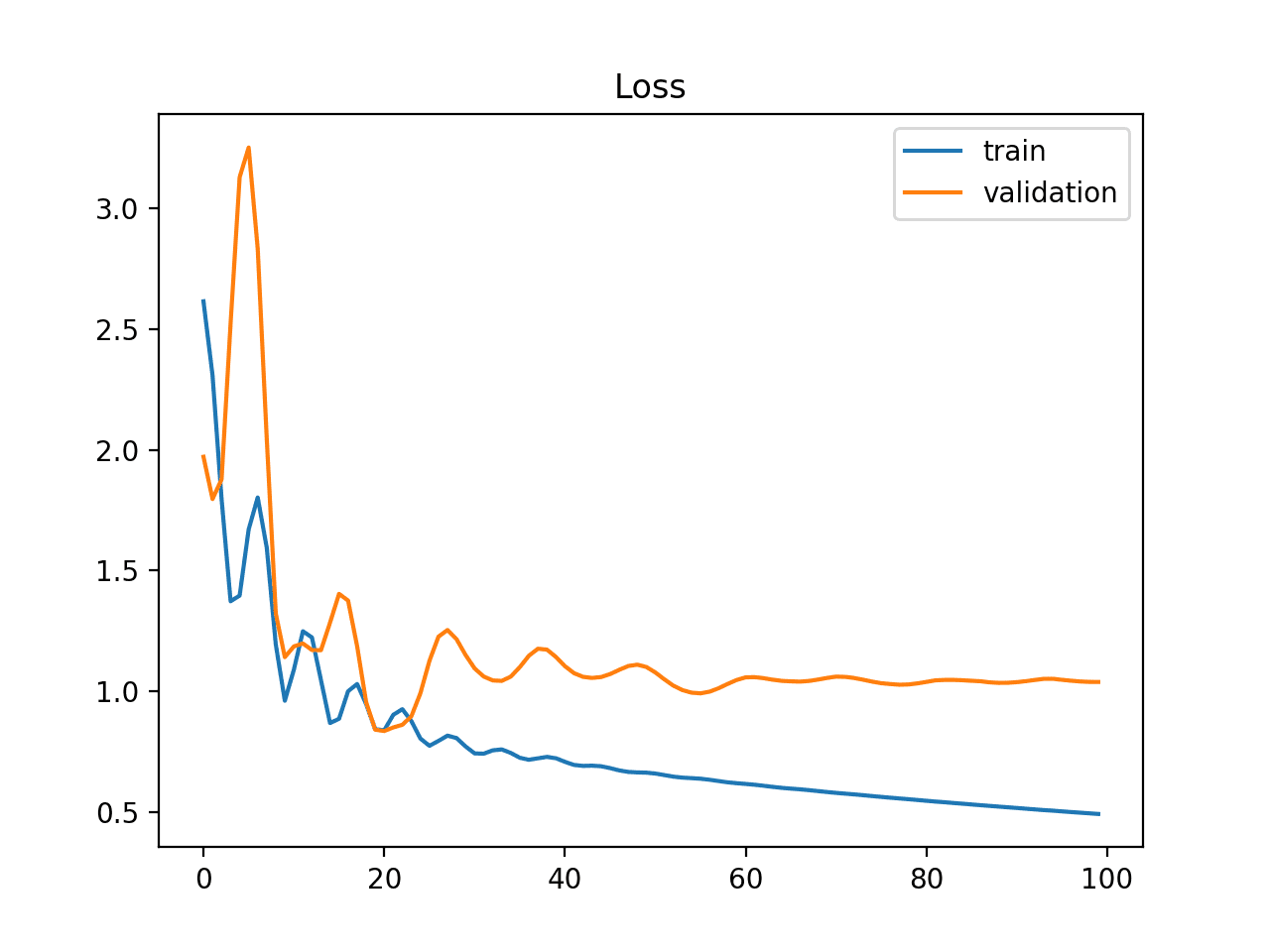

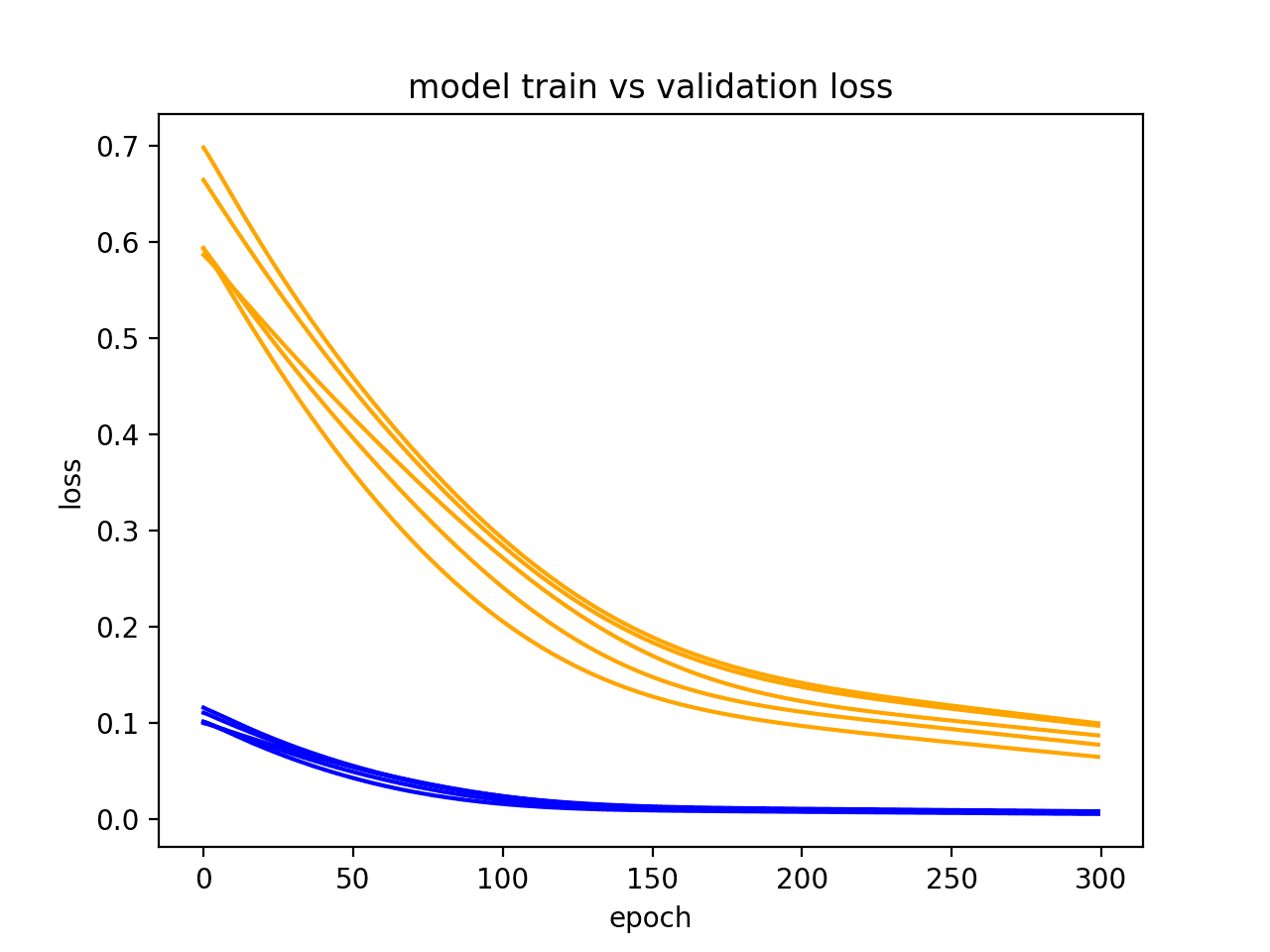

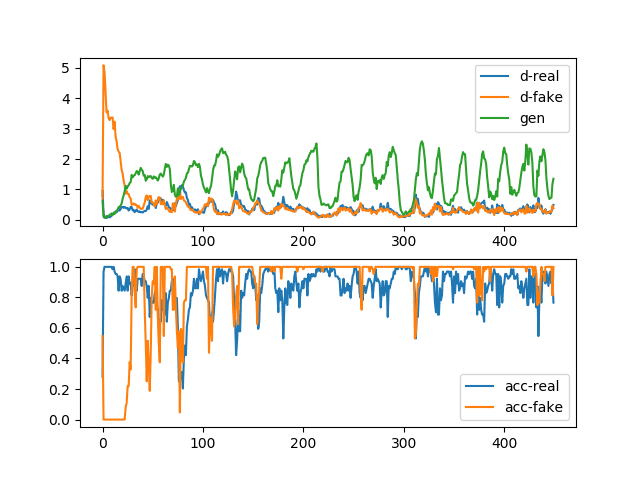

4. 过拟合、欠拟合和校准分析

一个关键的性能问题,也在关于诊断回归模型的近期文章中讨论过,就是过拟合和欠拟合。欠拟合是指模型未能很好地拟合训练数据,而过拟合是指模型拟合训练数据过度。两者都可能导致在验证集和测试集上出现严重的性能问题,使模型不适合实际部署。因此,解决这些问题是首要任务。此外,当模型将数据分类到不同类别的概率与实际真实标签的概率不匹配时,也可能出现校准问题。

分类模型的欠拟合和过拟合

要诊断和处理过拟合和欠拟合,请可视化训练与验证曲线(或简称为学习曲线),这对于使用 TensorFlow 训练的神经网络分类器很常见。可靠性图(Reliability diagrams)可以帮助重新校准概率并解决潜在的校准问题,而其他策略,如正则化,或调整决策树、支持向量机和神经网络等模型的复杂度,也有助于解决过拟合问题。

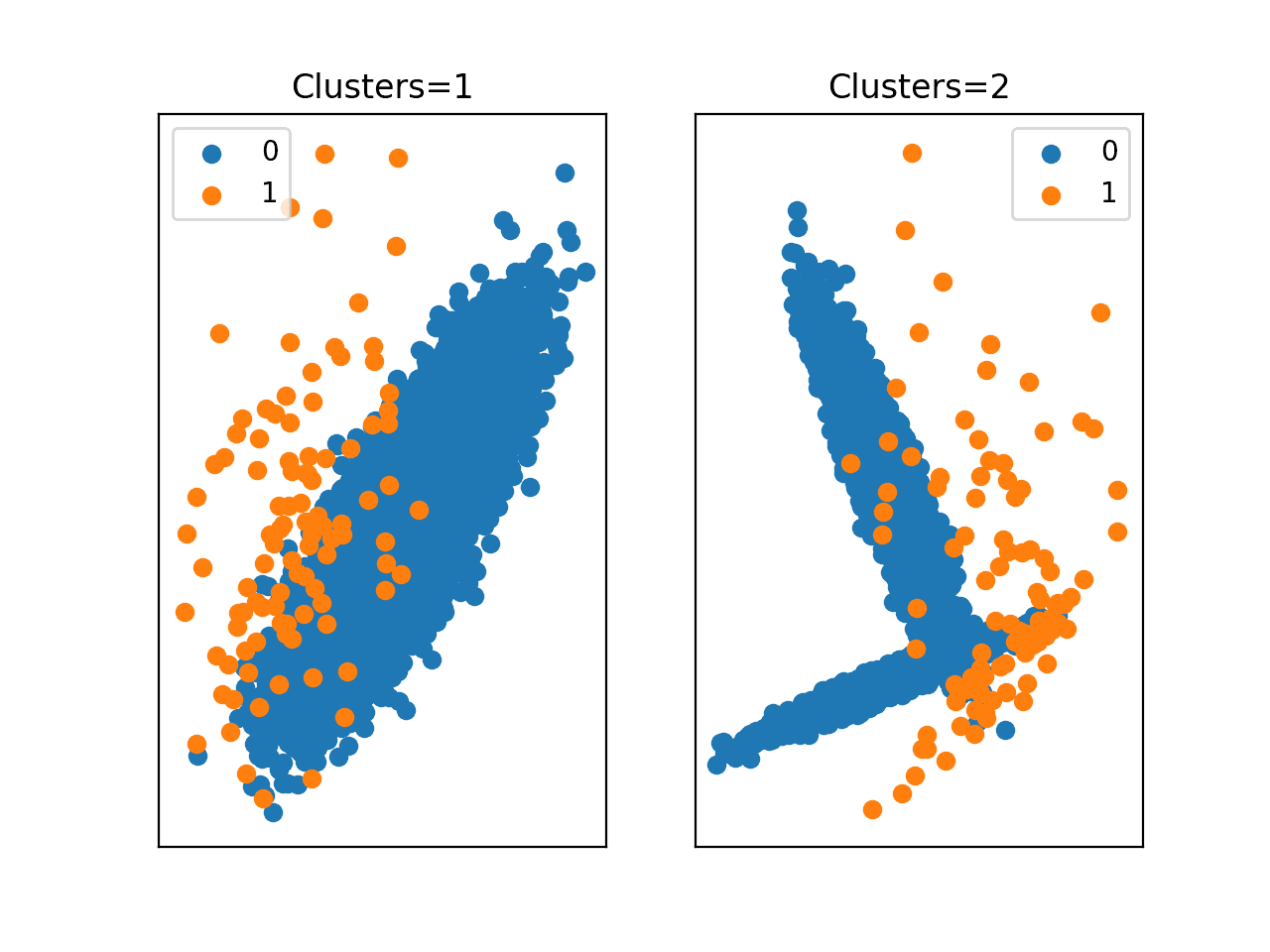

5. 检测和处理概念漂移

假设您的模型已经部署,因为适当的诊断帮助您达到了上述四个问题不再普遍存在的地步。一旦部署并投入生产,还有一个重要问题需要随着时间的推移进行监控、诊断和处理:数据漂移—换句话说,您的输入数据分布的统计特性与训练数据相比发生了变化。数据漂移的一个特定案例是概念漂移,即由于底层应用场景的变化,特征与类别标签之间的关系会随着时间演变。

要诊断概念漂移,请建立一个稳健的方案来监控训练数据和生产中的输入数据之间的特征分布统计信息,当生产数据中的分布与用于训练模型的数据分布存在显著差异时,发出警报。这是您的模型可能需要使用新的、更新的数据重新训练的可靠信号。此外,还要定期验证近期标记数据样本的性能。精心设计的漂移检测系统和构建自适应学习管道有助于管理生产环境中分类器的这一问题。

总结

本文探讨了机器学习分类模型可能表现不佳的几个常见原因,从数据质量问题到类别不平衡和投入生产后的数据漂移。讨论重点关注了使用解释性和基于证据的方法来诊断这些导致分类器性能不佳的各种根本原因。

暂无评论。