Keras 是一个深度学习库,它封装了高效的数值计算库 Theano 和 TensorFlow。

在本帖中,您将了解如何使用 Keras 为回归问题开发和评估神经网络模型。

完成本分步教程后,您将了解

- 如何加载 CSV 数据集并使其可供 Keras 使用

- 如何使用 Keras 为回归问题创建神经网络模型

- 如何使用 scikit-learn 和 Keras 通过交叉验证评估模型

- 如何进行数据准备以提高 Keras 模型的性能

- 如何使用 Keras 调整模型的网络拓扑结构

立即开始您的项目,阅读我的新书《Python 深度学习》,其中包含分步教程和所有示例的Python 源代码文件。

让我们开始吧。

- 2016 年 6 月:首次发布

- 2017 年 3 月更新:更新至 Keras 2.0.2、TensorFlow 1.0.1 和 Theano 0.9.0

- 更新于 2018 年 3 月:由于原始数据集下载链接已失效,已添加备用下载链接。

- 更新于 2018 年 4 月:将 nb_epoch 参数更改为 epochs。

- 2019 年 9 月更新:更新至 Keras 2.2.5 API

- 更新于 2022 年 7 月:使用 SciKeras 更新 TensorFlow 2.x 语法。

使用 Python Keras 深度学习库进行回归教程

照片由 Salim Fadhley 拍摄,保留部分权利。

1. 问题描述

本教程将要解决的问题是 波士顿房价数据集。

您可以下载此数据集并将其保存在当前工作目录中,文件名为 housing.csv (更新:在此处下载数据)。

该数据集描述了波士顿郊区房屋的 13 个数值属性,旨在对这些郊区房屋的价格进行建模,单位为千美元。因此,这是一个回归预测建模问题。输入属性包括犯罪率、非零售商业用地面积比例、化学浓度等。

这是机器学习中一个经过充分研究的问题。它易于处理,因为所有输入和输出属性都是数值型的,并且有 506 个样本可供使用。

使用均方误差 (MSE) 评估的模型,合理的性能目标约为 20(千美元的平方)(或取平方根为 4500 美元)。这是我们神经网络模型的一个不错的目标。

Python 深度学习需要帮助吗?

参加我的免费为期两周的电子邮件课程,发现 MLP、CNN 和 LSTM(附代码)。

立即点击注册,还将免费获得本课程的 PDF 电子书版本。

2. 开发基线神经网络模型

在本节中,您将为回归问题创建一个基线神经网络模型。

让我们开始包含本教程所需的所有函数和对象。

|

1 2 3 4 5 6 7 8 9 |

import pandas as pd from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from scikeras.wrappers import KerasRegressor from sklearn.model_selection import cross_val_score from sklearn.model_selection import KFold from sklearn.preprocessing import StandardScaler from sklearn.pipeline import Pipeline ... |

您现在可以从本地目录中的文件中加载数据集。

UCI 机器学习库中的数据集实际上不是 CSV 格式。属性由空格分隔。您可以使用 pandas 库轻松加载它。然后分割输入 (X) 和输出 (Y) 属性,以便更容易地使用 Keras 和 scikit-learn 进行建模。

|

1 2 3 4 5 6 7 |

... # 加载数据集 dataframe = pd.read_csv("housing.csv", delim_whitespace=True, header=None) dataset = dataframe.values # 分割为输入 (X) 和输出 (Y) 变量 X = dataset[:,0:13] Y = dataset[:,13] |

您可以使用 Keras 库提供的便捷包装器对象来创建 Keras 模型并使用 scikit-learn 进行评估。这是可取的,因为 scikit-learn 在评估模型方面表现出色,并且允许您使用强大的数据准备和模型评估方案,只需几行代码。

Keras 包装器需要一个函数作为参数。您必须定义的此函数负责创建要评估的神经网络模型。

下面,您将定义创建要评估的基线模型所需的函数。它是一个简单的模型,具有一个完全连接的隐藏层,其神经元数量与输入属性(13 个)相同。该网络使用了良好的实践,例如用于隐藏层的整流器激活函数。输出层不使用激活函数,因为这是一个回归问题,您有兴趣直接预测数值,而无需进行转换。

该模型使用了高效的 ADAM 优化算法,并优化了均方误差损失函数。这将是您用来评估模型性能的相同指标。这是一个理想的指标,因为它的平方根可以给出您可以直接理解的问题背景(千美元)下的误差值。

如果您不熟悉 Keras 或深度学习,请参阅此 Keras 教程。

|

1 2 3 4 5 6 7 8 9 10 |

... # 定义基本模型 def baseline_model(): # 创建模型 model = Sequential() model.add(Dense(13, input_shape=(13,), kernel_initializer='normal', activation='relu')) model.add(Dense(1, kernel_initializer='normal')) # 编译模型 model.compile(loss='mean_squared_error', optimizer='adam') return model |

在 scikit-learn 中用作回归估计器的 Keras 包装器对象称为 KerasRegressor。您创建一个实例,并将创建神经网络模型的函数名以及要稍后传递给模型 fit() 函数的一些参数(如 epochs 和 batch size)传递给它。这两者都设置为合理的默认值。

最后一步是评估此基线模型。您将使用 10 折交叉验证来评估模型。

|

1 2 3 4 |

... kfold = KFold(n_splits=10) results = cross_val_score(estimator, X, Y, cv=kfold, scoring='neg_mean_squared_error') print("Results: %.2f (%.2f) MSE" % (results.mean(), results.std())) |

将以上所有内容整合在一起,完整的示例如下。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 |

# 使用波士顿数据集的回归示例:基线 from pandas import read_csv from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from scikeras.wrappers import KerasRegressor from sklearn.model_selection import cross_val_score from sklearn.model_selection import KFold # 加载数据集 dataframe = read_csv("housing.csv", delim_whitespace=True, header=None) dataset = dataframe.values # 分割为输入 (X) 和输出 (Y) 变量 X = dataset[:,0:13] Y = dataset[:,13] # 定义基本模型 def baseline_model(): # 创建模型 model = Sequential() model.add(Dense(13, input_shape=(13,), kernel_initializer='normal', activation='relu')) model.add(Dense(1, kernel_initializer='normal')) # 编译模型 model.compile(loss='mean_squared_error', optimizer='adam') return model # 评估模型 estimator = KerasRegressor(model=baseline_model, epochs=100, batch_size=5, verbose=0) kfold = KFold(n_splits=10) results = cross_val_score(estimator, X, Y, cv=kfold, scoring='neg_mean_squared_error') print("Baseline: %.2f (%.2f) MSE" % (results.mean(), results.std())) |

运行此代码可估算模型在未知数据上的问题表现。

注意:您的 结果可能因算法或评估程序的随机性,或数值精度的差异而有所不同。请尝试运行示例几次并比较平均结果。

注意:均方误差为负,因为 scikit-learn 会将其反转,以便最大化度量而不是最小化。您可以忽略结果的符号。

结果报告了均方误差,包括交叉验证评估的十个折叠的平均值和标准差(平均方差)。

|

1 |

基线:-32.65 (23.33) MSE |

3. 标准化数据集建模

波士顿房价数据集中一个重要的考虑因素是输入属性的尺度各不相同,因为它们度量不同的量。

在通过神经网络模型进行建模之前,准备数据几乎总是最佳实践。

在上述基线模型的基础上,您可以使用标准化版本的数据集重新评估相同的模型。

您可以使用 scikit-learn 的 Pipeline 框架在交叉验证的每个折叠的模型评估过程中执行标准化。这确保了每个交叉验证测试集都没有数据泄露到训练数据中。

以下代码创建了一个 scikit-learn 管道,该管道首先标准化数据集,然后创建并评估基线神经网络模型。

|

1 2 3 4 5 6 7 8 9 |

... # 使用标准化数据集评估模型 estimators = [] estimators.append(('standardize', StandardScaler())) estimators.append(('mlp', KerasRegressor(model=baseline_model, epochs=50, batch_size=5, verbose=0))) pipeline = Pipeline(estimators) kfold = KFold(n_splits=10) results = cross_val_score(pipeline, X, Y, cv=kfold, scoring='neg_mean_squared_error') print("Standardized: %.2f (%.2f) MSE" % (results.mean(), results.std())) |

将以上所有内容整合在一起,完整的示例如下。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 |

# 使用波士顿数据集的回归示例:标准化 from pandas import read_csv from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from scikeras.wrappers import KerasRegressor from sklearn.model_selection import cross_val_score from sklearn.model_selection import KFold from sklearn.preprocessing import StandardScaler from sklearn.pipeline import Pipeline # 加载数据集 dataframe = read_csv("housing.csv", delim_whitespace=True, header=None) dataset = dataframe.values # 分割为输入 (X) 和输出 (Y) 变量 X = dataset[:,0:13] Y = dataset[:,13] # 定义基本模型 def baseline_model(): # 创建模型 model = Sequential() model.add(Dense(13, input_shape=(13,), kernel_initializer='normal', activation='relu')) model.add(Dense(1, kernel_initializer='normal')) # 编译模型 model.compile(loss='mean_squared_error', optimizer='adam') return model # 使用标准化数据集评估模型 estimators = [] estimators.append(('standardize', StandardScaler())) estimators.append(('mlp', KerasRegressor(model=baseline_model, epochs=50, batch_size=5, verbose=0))) pipeline = Pipeline(estimators) kfold = KFold(n_splits=10) results = cross_val_score(pipeline, X, Y, cv=kfold, scoring='neg_mean_squared_error') print("Standardized: %.2f (%.2f) MSE" % (results.mean(), results.std())) |

注意:您的 结果可能因算法或评估程序的随机性,或数值精度的差异而有所不同。请尝试运行示例几次并比较平均结果。

运行该示例,性能相比未经标准化的基线模型有所提高,误差有所下降。

|

1 |

标准化:-29.54 (27.87) MSE |

本节的进一步扩展是将输出变量也进行类似地重缩放,例如将其归一化到 0-1 范围,并在输出层使用 Sigmoid 或类似激活函数,将输出预测限制在同一范围内。

4. 调整神经网络拓扑

神经网络模型可以优化许多方面。

也许最重要的杠杆点是网络结构本身,包括层数和每层的神经元数量。

在本节中,您将评估两种额外的网络拓扑,以期进一步提高模型性能。您将同时考察更深层和更宽的网络拓扑。

4.1. 评估更深的网络拓扑

提高神经网络性能的一种方法是增加层数。这可能允许模型提取和重组数据中嵌入的高阶特征。

在本节中,您将评估在模型中增加一个隐藏层的效果。这就像定义一个新函数来创建这个更深层的模型一样容易,该函数复制了上面您基线模型。您可以将新的一行插入到第一个隐藏层之后——在本例中,神经元数量大约是原来的一半。

|

1 2 3 4 5 6 7 8 9 10 11 |

... # 定义模型 def larger_model(): # 创建模型 model = Sequential() model.add(Dense(13, input_shape=(13,), kernel_initializer='normal', activation='relu')) model.add(Dense(6, kernel_initializer='normal', activation='relu')) model.add(Dense(1, kernel_initializer='normal')) # 编译模型 model.compile(loss='mean_squared_error', optimizer='adam') return model |

您的网络拓扑现在看起来像这样

|

1 |

13 个输入 -> [13 -> 6] -> 1 个输出 |

您可以像上面一样评估此网络拓扑,同时还可以使用上述数据集的标准化来提高性能。

|

1 2 3 4 5 6 7 8 |

... estimators = [] estimators.append(('standardize', StandardScaler())) estimators.append(('mlp', KerasRegressor(model=larger_model, epochs=50, batch_size=5, verbose=0))) pipeline = Pipeline(estimators) kfold = KFold(n_splits=10) results = cross_val_score(pipeline, X, Y, cv=kfold, scoring='neg_mean_squared_error') print("Larger: %.2f (%.2f) MSE" % (results.mean(), results.std())) |

将以上所有内容整合在一起,完整的示例如下。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 |

# 使用波士顿数据集的回归示例:标准化和更深层 from pandas import read_csv from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from scikeras.wrappers import KerasRegressor from sklearn.model_selection import cross_val_score from sklearn.model_selection import KFold from sklearn.preprocessing import StandardScaler from sklearn.pipeline import Pipeline # 加载数据集 dataframe = read_csv("housing.csv", delim_whitespace=True, header=None) dataset = dataframe.values # 分割为输入 (X) 和输出 (Y) 变量 X = dataset[:,0:13] Y = dataset[:,13] # 定义模型 def larger_model(): # 创建模型 model = Sequential() model.add(Dense(13, input_shape=(13,), kernel_initializer='normal', activation='relu')) model.add(Dense(6, kernel_initializer='normal', activation='relu')) model.add(Dense(1, kernel_initializer='normal')) # 编译模型 model.compile(loss='mean_squared_error', optimizer='adam') return model # 使用标准化数据集评估模型 estimators = [] estimators.append(('standardize', StandardScaler())) estimators.append(('mlp', KerasRegressor(model=larger_model, epochs=50, batch_size=5, verbose=0))) pipeline = Pipeline(estimators) kfold = KFold(n_splits=10) results = cross_val_score(pipeline, X, Y, cv=kfold, scoring='neg_mean_squared_error') print("Larger: %.2f (%.2f) MSE" % (results.mean(), results.std())) |

注意:您的 结果可能因算法或评估程序的随机性,或数值精度的差异而有所不同。请尝试运行示例几次并比较平均结果。

运行此模型显示性能进一步提高,从 28 降至 24 千美元的平方。

|

1 |

更深层:-22.83 (25.33) MSE |

4.2. 评估更宽的网络拓扑

增加模型表示能力的另一种方法是创建更宽的网络。

在本节中,您将评估保持浅层网络结构并将隐藏层中的神经元数量几乎翻倍的效果。

同样,您需要做的就是定义一个新函数来创建您的神经网络模型。在这里,您将增加隐藏层中的神经元数量,与基线模型相比,从 13 个增加到 20 个。

|

1 2 3 4 5 6 7 8 9 10 |

... # 定义更宽的模型 def wider_model(): # 创建模型 model = Sequential() model.add(Dense(20, input_shape=(13,), kernel_initializer='normal', activation='relu')) model.add(Dense(1, kernel_initializer='normal')) # 编译模型 model.compile(loss='mean_squared_error', optimizer='adam') return model |

您的网络拓扑现在看起来像这样

|

1 |

13 个输入 -> [20] -> 1 个输出 |

您可以使用与上述相同的方案评估更宽的网络拓扑

|

1 2 3 4 5 6 7 8 |

... estimators = [] estimators.append(('standardize', StandardScaler())) estimators.append(('mlp', KerasRegressor(model=wider_model, epochs=100, batch_size=5, verbose=0))) pipeline = Pipeline(estimators) kfold = KFold(n_splits=10) results = cross_val_score(pipeline, X, Y, cv=kfold, scoring='neg_mean_squared_error') print("Wider: %.2f (%.2f) MSE" % (results.mean(), results.std())) |

将以上所有内容整合在一起,完整的示例如下。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 |

# 使用波士顿数据集的回归示例:标准化和更宽 from pandas import read_csv from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from scikeras.wrappers import KerasRegressor from sklearn.model_selection import cross_val_score from sklearn.model_selection import KFold from sklearn.preprocessing import StandardScaler from sklearn.pipeline import Pipeline # 加载数据集 dataframe = read_csv("housing.csv", delim_whitespace=True, header=None) dataset = dataframe.values # 分割为输入 (X) 和输出 (Y) 变量 X = dataset[:,0:13] Y = dataset[:,13] # 定义更宽的模型 def wider_model(): # 创建模型 model = Sequential() model.add(Dense(20, input_shape=(13,), kernel_initializer='normal', activation='relu')) model.add(Dense(1, kernel_initializer='normal')) # 编译模型 model.compile(loss='mean_squared_error', optimizer='adam') return model # 使用标准化数据集评估模型 estimators = [] estimators.append(('standardize', StandardScaler())) estimators.append(('mlp', KerasRegressor(model=wider_model, epochs=100, batch_size=5, verbose=0))) pipeline = Pipeline(estimators) kfold = KFold(n_splits=10) results = cross_val_score(pipeline, X, Y, cv=kfold, scoring='neg_mean_squared_error') print("Wider: %.2f (%.2f) MSE" % (results.mean(), results.std())) |

注意:您的 结果可能因算法或评估程序的随机性,或数值精度的差异而有所不同。请尝试运行示例几次并比较平均结果。

构建模型显示误差进一步降至约 21 千美元的平方。对于这个问题来说,这算是不错的结果。

|

1 |

更宽:-21.71 (24.39) MSE |

也许很难猜到更宽的网络会比更深的网络在此问题上表现更好。结果证明了经验测试在开发神经网络模型中的重要性。

总结

在本帖中,您了解了用于对回归问题进行建模的 Keras 深度学习库。

通过本教程,您学会了如何开发和评估神经网络模型,包括:

- 如何加载数据并开发基线模型

- 如何通过数据准备技术(如标准化)来提升性能

- 如何在问题上设计和评估具有不同拓扑结构的神经网络

您对 Keras 深度学习库或本帖有任何疑问吗?请在评论中提问,我将尽力回答。

您好,您在 cross_val_score 模块中处理过字符串变量吗?

数据集是数值型的,没有字符串值。

我们如何处理字符串值?

好问题,我有一个关于这个主题的完整章节。

https://machinelearning.org.cn/start-here/#nlp

出于某种原因,我的 MSE 是负数。为什么?

sklearn 会反转 MSE,以便可以最大化它。

One hot encoder 是一个选项。

你好,

我有

2 个输入集(即 2 列),而不是这个问题中的 13 列

8 个输出(8 列),而不是这个问题中的 1 列

506 个训练集中的 192 个,而不是这个问题中的 506 个

所以是多输入多输出预测建模

这段代码是否足够?还是我需要更改任何内容?

这是深度学习吗?因为我听说深度学习需要数千个训练集。

请原谅我,我对深度学习一无所知,并且将从这段代码开始。

我正在等待您的回复

如果您预测的是 8 个实值变量(而不是 8 个类别),您可以将输出层的节点数更改为 8。

感谢您的快速回复。

所以,我只需要更改输出层,对吗?

现在,我还有一些问题。

如果我使用此代码获得结果,我需要知道一些详细信息。

1)我猜这是最新的深度神经网络。这种神经网络叫什么名字?(例如,循环神经网络、多层感知机、玻尔兹曼机等)

2)在深度学习中,需要通过调整参数来调整参数。

这里的参数有哪些是我需要调整的?

3)您能否发送一张图片,显示神经网络的完整架构,包括输入层、隐藏层、输出层、传输函数等?

4)因为我将使用这段代码,所以我需要在要写的期刊中引用它。

我应该直接引用这个网站还是您建议我引用的任何论文?

为了帮助您调整模型,我建议从这里开始。

https://machinelearning.org.cn/start-here/#better

您可以在此处总结您模型的架构,了解更多信息。

https://machinelearning.org.cn/visualize-deep-learning-neural-network-model-keras/

我在这里展示了如何引用帖子或书籍。

https://machinelearning.org.cn/faq/single-faq/how-do-i-reference-or-cite-a-book-or-blog-post

布朗利先生,

如果我有一个多输入多输出的回归问题,例如 4 个输入和 4 个输出,那么我该如何处理?

模型可以定义为接受 4 个输入,然后您可以在输出层拥有 4 个节点。

非常感谢您的善意和及时的回复,Jason 先生。

不客气。

另外,在多输出的情况下,我们在 keras 中进行预测和准确率的方式与单输出情况相同吗?我刚接触深度学习,所以很抱歉我的问题可能有些天真。

您可以为所有输出以及/或每个单独的输出计算一个分数。

训练时,keras 将使用单个损失函数,但您的项目利益相关者在评估最终模型时可能有更多要求。

Jason 先生,如果我在我的系统上运行您的代码,我会收到一个错误。

TypeError: (‘Keyword argument not understood:’, ‘acitivation’)

您能解释一下为什么吗?

Ganesh

很抱歉听到这个消息,我在这里有一些建议。

https://machinelearning.org.cn/faq/single-faq/why-does-the-code-in-the-tutorial-not-work-for-me

您应该键入“activation”,而不是在“c”后面加上“i”。

# 使用波士顿数据集的回归示例:标准化和更宽

import pandas as pd

来自 keras.models import Sequential

from keras.layers import Dense

from keras.wrappers.scikit_learn import KerasRegressor

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import KFold

from sklearn.preprocessing import StandardScaler

from sklearn.pipeline import Pipeline

# 加载数据集

dataset = pd.read_csv(‘train1.csv’)

testthedata = pd.read_csv(‘test1.csv’)

# 分割为输入 (X) 和输出 (Y) 变量

X = dataset.drop(columns = [“Id”, “SalePrice”, “Alley”, “MasVnrType”, “BsmtQual”, “BsmtCond”, “BsmtExposure”,

“BsmtFinType1”, “BsmtFinType2”, “Electrical”, “FireplaceQu”, “GarageType”,

“GarageFinish”, “GarageQual”, “GarageCond”, “PoolQC”, “Fence”, “MiscFeature”])

y = dataset[‘SalePrice’].values

testthedata = testthedata.drop(columns = [“MSZoning”, “Utilities”, “Id”, “Alley”, “MasVnrType”, “BsmtQual”, “BsmtCond”, “BsmtExposure”,

“Exterior1st”, “Exterior2nd”, “BsmtFinType1”, “BsmtFinType2”, “Electrical”, “FireplaceQu”, “GarageType”,

“KitchenQual”, “SaleType”, “Functional”, “GarageFinish”, “GarageQual”, “GarageCond”, “PoolQC”, “Fence”, “MiscFeature”])

from sklearn.preprocessing import LabelEncoder, OneHotEncoder

le = LabelEncoder()

le1 = LabelEncoder()

X[‘MSZoning’] = le.fit_transform(X[[‘MSZoning’]])

X[‘Street’] = le.fit_transform(X[[‘Street’]])

X[‘LotShape’] = le.fit_transform(X[[‘LotShape’]])

X[‘LandContour’] = le.fit_transform(X[[‘LandContour’]])

X[‘LotConfig’] = le.fit_transform(X[[‘LotConfig’]])

X[‘LandSlope’] = le.fit_transform(X[[‘LandSlope’]])

X[‘Utilities’] = le.fit_transform(X[[‘Utilities’]])

X[‘Neighborhood’] = le.fit_transform(X[[‘Neighborhood’]])

X[‘Condition1’] = le.fit_transform(X[[‘Condition1’]])

X[‘Condition2’] = le.fit_transform(X[[‘Condition2’]])

X[‘BldgType’] = le.fit_transform(X[[‘BldgType’]])

X[‘HouseStyle’] = le.fit_transform(X[[‘HouseStyle’]])

X[‘RoofStyle’] = le.fit_transform(X[[‘RoofStyle’]])

X[‘RoofMatl’] = le.fit_transform(X[[‘RoofMatl’]])

X[‘Exterior1st’] = le.fit_transform(X[[‘Exterior1st’]])

X[‘Exterior2nd’] = le.fit_transform(X[[‘Exterior2nd’]])

X[‘ExterQual’] = le.fit_transform(X[[‘ExterQual’]])

X[‘ExterCond’] = le.fit_transform(X[[‘ExterCond’]])

X[‘Foundation’] = le.fit_transform(X[[‘Foundation’]])

X[‘Heating’] = le.fit_transform(X[[‘Heating’]])

X[‘HeatingQC’] = le.fit_transform(X[[‘HeatingQC’]])

X[‘KitchenQual’] = le.fit_transform(X[[‘KitchenQual’]])

X[‘Functional’] = le.fit_transform(X[[‘Functional’]])

X[‘PavedDrive’] = le.fit_transform(X[[‘PavedDrive’]])

X[‘SaleType’] = le.fit_transform(X[[‘SaleType’]])

X[‘SaleCondition’] = le.fit_transform(X[[‘SaleCondition’]])

#testing[‘MSZoning’] = le1.fit_transform(testing[[‘MSZoning’]])

testthedata[‘Street’] = le1.fit_transform(testthedata[[‘Street’]])

testthedata[‘LotShape’] = le1.fit_transform(testthedata[[‘LotShape’]])

testthedata[‘LandContour’] = le1.fit_transform(testthedata[[‘LandContour’]])

testthedata[‘LotConfig’] = le1.fit_transform(testthedata[[‘LotConfig’]])

#testthedata[‘LandSlope’] = le1.testthedata(testthedata[[‘LandSlope’]])

#testing[‘Utilities’] = le1.fit_transform(testing[[‘Utilities’]])

testthedata[‘Neighborhood’] = le1.fit_transform(testthedata[[‘Neighborhood’]])

testthedata[‘Condition1’] = le1.fit_transform(testthedata[[‘Condition1’]])

#testthedata[‘Condition2’] = le1.fit_transform(testthedata[[‘Condition2’]])

testthedata[‘BldgType’] = le1.fit_transform(testthedata[[‘BldgType’]])

testthedata[‘HouseStyle’] = le1.fit_transform(testthedata[[‘HouseStyle’]])

testthedata[‘RoofStyle’] = le1.fit_transform(testthedata[[‘RoofStyle’]])

#testthedata[‘RoofMatl’] = le1.fit_transform(testthedata[[‘RoofMatl’]])

#testing[‘Exterior1st’] = le1.fit_transform(testing[[‘Exterior1st’]])

#testing[‘Exterior2nd’] = le1.fit_transform(testing[[‘Exterior2nd’]])

testthedata[‘ExterQual’] = le1.fit_transform(testthedata[[‘ExterQual’]])

#testthedata[‘ExterCond’] = le1.fit_transform(testthedata[[‘ExterCond’]])

testthedata[‘Foundation’] = le1.fit_transform(testthedata[[‘Foundation’]])

testthedata[‘Heating’] = le1.fit_transform(testthedata[[‘Heating’]])

#testthedata[‘HeatingQC’] = le1.fit_transform(testthedata[[‘HeatingQC’]])

#testing[‘KitchenQual’] = le1.fit_transform(testing[[‘KitchenQual’]])

#testing[‘Functional’] = le1.fit_transform(testing[[‘Functional’]])

testthedata[‘PavedDrive’] = le1.fit_transform(testthedata[[‘PavedDrive’]])

#testing[‘SaleType’] = le1.fit_transform(testing[[‘SaleType’]])

testthedata[‘SaleCondition’] = le1.fit_transform(testthedata[[‘SaleCondition’]])

X[‘MSZoning’] = pd.to_numeric(X[‘MSZoning’])

ohe = OneHotEncoder(categorical_features = [1])

X = ohe.fit_transform(X).toarray()

对于这段代码,出现了错误,如何纠正它,先生?

File “”, line 1, in

X = ohe.fit_transform(X).toarray()

File “/Users/p.venkatesh/opt/anaconda3/lib/python3.7/site-packages/sklearn/preprocessing/_encoders.py”, line 629, in fit_transform

self._categorical_features, copy=True)

File “/Users/p.venkatesh/opt/anaconda3/lib/python3.7/site-packages/sklearn/preprocessing/base.py”, line 45, in _transform_selected

X = check_array(X, accept_sparse=’csc’, copy=copy, dtype=FLOAT_DTYPES)

File “/Users/p.venkatesh/opt/anaconda3/lib/python3.7/site-packages/sklearn/utils/validation.py”, line 496, in check_array

array = np.asarray(array, dtype=dtype, order=order)

File “/Users/p.venkatesh/opt/anaconda3/lib/python3.7/site-packages/numpy/core/_asarray.py”, line 85, in asarray

返回数组(a, dtype, copy=False, order=order)

ValueError: could not convert string to float: ‘Y’

也许这会有帮助。

https://machinelearning.org.cn/faq/single-faq/can-you-read-review-or-debug-my-code

如何衡量一个输出为连续变量的神经网络的性能,因为我显然不能使用准确率?

您可以使用误差指标。

https://machinelearning.org.cn/regression-metrics-for-machine-learning/

嗨,Jason,

很棒的教程(们),到目前为止它们对我来说非常有帮助,就像一个快速入门课程。

有没有办法让模型输出这个例子中的估计 Y 值?我想在我仍在学习 Keras 的时候更直接地评估模型。

谢谢!

你好 Paul,您可以通过调用 model.predict() 来进行预测。

嘿 Paul,

您是如何将 model.predict() 函数插入到上面的代码中以在测试数据上运行的?请告诉我。

你好,

这就是您插入 predict 并从模型中获取预测值的方式吗?

def mymodel()

model = Sequential()

model.add(Dense(13, input_dim=13, kernel_initializer=’normal’, activation=’relu’))

model.add(Dense(6, kernel_initializer=’normal’, activation=’relu’))

model.add(Dense(1, kernel_initializer=’normal’))

model.compile(loss='mean_squared_error', optimizer='adam')

model.fit(X,y, nb_epoch=50, batch_size=5)

predictions = model.predict(X)

return model

我实际上想将预测值写入文件?

DataScientistPM,

他正在使用 Scikit-Learn 的交叉验证框架,该框架必须在内部调用 fit。

正确。

你好,

但是如何获得单个 X 值的预测呢?

如果我尝试这样做

y_predict = mymodel.predict(x)

我收到此错误

AttributeError: ‘function’ object has no attribute ‘predict’。

我猜是因为我们调用了 Scikit-Learn,但不知道如何预测新值。

这是使用 sklearn 模型进行预测的方法。

https://machinelearning.org.cn/make-predictions-scikit-learn/

这是使用 Keras 模型进行预测的方法。

https://machinelearning.org.cn/how-to-make-classification-and-regression-predictions-for-deep-learning-models-in-keras/

您好,非常棒的帖子,谢谢!您能否提供一个如何使用 Keras LSTM 层来考虑此数据集上的时间影响的示例?

谢谢

谢谢你,Chris。

您可以在此处看到此数据集上 LSTM 的示例。

https://machinelearning.org.cn/time-series-prediction-lstm-recurrent-neural-networks-python-keras/

那太棒了,谢谢你 Jason。

不客气,Chris。

你好,

感谢教程。我有一个回归问题,输出有界(0-1)。是否有最佳方法来处理这个问题?

谢谢!

Marc

你好 Marc,我认为在线性激活函数上使用输出层就足够了。

这是一个很好的例子。但是,当考虑过拟合时,它与神经网络无关。为了监控过拟合状态,应将验证过程包含在 fit() 函数中。此外,可以基于内部验证步骤使用早停法。此示例仅适用于数据量相对于输入和隐藏节点总权重较大的情况。

非常感谢 James 的反馈,我同意。

它的目的是展示如何为回归开发网络,但数据集确实有点小。

感谢 Jason 和 James!有几个问题(以及如何在 python 中实现)

1) 如何监控深度学习中的过拟合状态?

2) 如何将交叉验证过程包含在 fit() 函数中以监控过拟合状态?

3) 如何基于内部验证步骤使用早停法?

4) 为什么这个示例仅适用于大型数据集?如果数据集很小,我们该怎么办?

Amir,这些都是很好的问题!

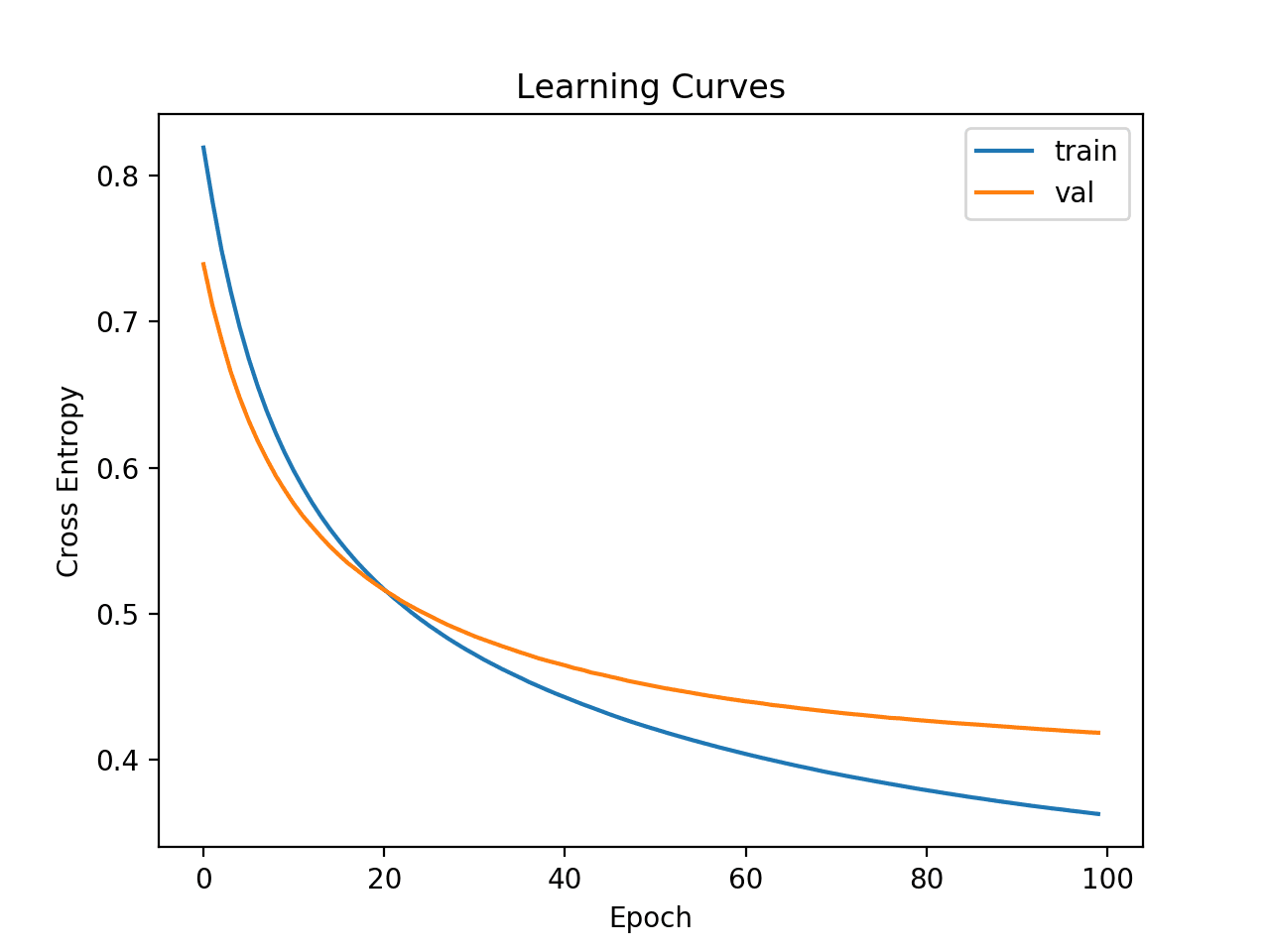

1. 监控模型在训练集和独立验证集上的性能。(甚至绘制这些学习曲线)。当验证集上的技能下降而训练集上的技能上升或持续上升时,您就过拟合了。

2. 交叉验证只是用于估算模型在未知数据上性能的一种方法。它封装了您准备数据和模型的所有操作,它不包含在 fit 中。

3. 如 1 所述,监控验证集上的技能,当验证集上的技能停止改进时,就停止训练。

4. 一般来说,神经网络需要比其他方法更多的数据来训练。

这是一个关于检查点的教程,您可以使用它来保存“早停”模型。

https://machinelearning.org.cn/check-point-deep-learning-models-keras/

你好,

如何在构建模型时使用 sklearn 对训练数据进行标准化,之后预测新数据点?

您可以保存用于标准化数据的对象,并在进行预测之前重用它来标准化新数据。这可能是 MinMaxScaler,例如。

您能举个例子说明如何做到这一点吗?

看这里

https://machinelearning.org.cn/standardscaler-and-minmaxscaler-transforms-in-python/

还有这个。

https://machinelearning.org.cn/how-to-save-and-load-models-and-data-preparation-in-scikit-learn-for-later-use/

你好,

我没有使用您所示的自动数据归一化,而是简单地计算训练数据中每个特征(数据列)的均值和标准差,然后手动执行 zscore((data – mean) / stdev)。通过归一化,我的意思是将数据处理成均值为 0,标准差为 1。我知道这个过程有几种名称,但为了便于讨论,我们称之为“归一化”。

所以我有 2 个问题:

1) 我也应该对输出列进行归一化吗?或者只是将其保留在我的训练/测试数据中?

2) 我取训练数据的均值和标准差,并用它们来归一化测试数据。但似乎它并没有使我的数据居中;无论我如何分割数据,也无论每个小批量如何平衡(具有相同的输出值分布),情况都是如此。我遗漏了什么/我能做什么?

你好 Guy,是的,这通常称为标准化。

通常,您可以从对输出列应用相同的转换中获得良好的结果。尝试一下,看看它如何影响您的结果。如果 MSE 或 RMSE 是性能度量,您可能需要小心解释结果,因为这些分数的尺度也会改变。

是的,这是一个常见问题。理想情况下,您需要一个非常大的训练数据集来有效估算这些值。您可以尝试使用 bootstrap 对训练数据集(或交叉验证的折叠内)进行操作,以创建更稳健的这些项的估算。Bootstrap 只是对数据集进行重复的子采样并估算统计量,然后取所有估算的平均值。它效果很好。

希望这能有所帮助。

你好 Jason,

如何将多个指纹图像加载到 keras 中。

您能否进一步指导?

此致,

Pranith

你好 Jason,教程很棒。是免费中最好的。

我可以使用 R² 作为我的指标吗?如果可以,如何使用?

此致

谢谢 Luciano。

您可以使用 R^2,请参阅此指标列表,您可以使用这些指标。

https://scikit-learn.cn/stable/modules/model_evaluation.html

results.mean() 应该打印准确率而不是误差,对吗?

我们为回归问题总结误差而不是准确率(x/y 正确)。希望这有帮助。

你好,

如果我有一个新的数据集 X_new,并且想进行预测,model.predict(X_new) 会显示错误 “NameError: name model is not defined”,而 estimator.predict(X_test) 会显示错误消息 ‘KerasRegressor object has no attribute model’。

您有什么建议吗?谢谢。

你好 David,这篇帖子将帮助您入门 Keras 模型生命周期。

https://machinelearning.org.cn/5-step-life-cycle-neural-network-models-keras/

嗨,Jason,

该页面不使用 KerasRegressor。如何从本教程的代码中保存模型及其权重?

谢谢!

我通过使用相同的种子标准化数据集时遇到了更多错误。这可能是什么原因?

同样,更深层的网络拓扑似乎没有帮助。它增加了 MSE。

没有标准化的更深层网络能产生更好的结果。标准化在某种程度上增加了更多噪声。

嘿,教程很棒。我尝试了 Theano 和 Tensorflow 后端,但对于 larger_model 我得到了非常不同的结果。使用 Theano 我得到了与您非常相似的结果,但使用 Tensorflow 我得到了大于 100 的 MSE。

您有什么线索吗?

Michele

Michele,这个问题很棒。

我初步猜测,这很可能是由于我们在 Python 深度学习堆栈中看到的重现性问题。要获得可重复的结果,几乎不可能固定使用的随机数生成器。

我不会排除某个实现中的错误,但对于如此简单的网络来说,这会让我非常惊讶。

您好,我有一个关于 sklearn 接口的问题。

尽管我们将 NN 模型发送到 sklearn 并评估了回归性能,但我们如何获得输入数据的确切预测值,就像我们通常使用 Keras 时可以调用 model.predict(X) 函数一样?顺便问一下,我的意思是模型在 sklearn 中,对吗?

你好 Kenny,

您可以使用 sklearn 的 model.predict() 函数以相同的方式对新输入数据进行预测。

嗨 Jason

我买了《Python 深度学习》这本书。感谢您出色的工作!

我经常看到关于“model.predict()”的问题。我也有这个问题。在上面的代码中,“model”是未定义的。那么哪个变量包含训练过的模型呢?我尝试了“estimator.predict()”,但遇到了以下错误:

‘KerasRegressor’ object has no attribute ‘model’

我认为这将帮助许多读者。

Silvan,感谢您的支持。

对于 keras 模型,您可以训练模型,将其分配给一个变量,然后调用 model.predict()。请参阅此帖子。

https://machinelearning.org.cn/5-step-life-cycle-neural-network-models-keras/

在上面的示例中,我们使用了管道,它也是一个 sklearn 估计器。我们可以直接调用 estimator.predict()(函数名相同,API 不同),更多信息请参见此处。

https://scikit-learn.cn/stable/modules/generated/sklearn.pipeline.Pipeline.html#sklearn.pipeline.Pipeline.predict

这有帮助吗?

嗨,Jason,

您是否能为本帖所示的示例提供一个直接使用 model.predict() 的示例?我关注您的帖子已经有几个月了,并且对 Keras 越来越熟悉了。但是,我仍然似乎无法在此示例中使用 .predict()。

谢谢!

你好 Dee,

此处有关 predict 函数的信息。

https://machinelearning.org.cn/5-step-life-cycle-neural-network-models-keras/

这篇帖子中有一个调用 predict 的示例。

https://machinelearning.org.cn/tutorial-first-neural-network-python-keras/

这有帮助吗?

你好 Dee,

Jason,如果我没理解错,上面的示例*不*提供训练过的模型作为输出。所以您将无法立即使用 .predict() 函数。

相反,您必须训练管道。

pipeline.fit(X,Y)

之后您才能进行预测。

pipeline.predict(numpy.array([[ 0.0273, 0. , 7.07 , 0. , 0.469 , 6.421 ,

78.9 , 4.9671, 2. , 242. , 17.8 , 396.9 ,

9.14 ]]))

# 将返回 array(22.125564575195312, dtype=float32)

是的,感谢您的更正。

抱歉造成混淆。

嘿 Silvan,

感谢您的提示!我曾认为 SciKit 的 crossval 并没有输出拟合的模型,而只是交叉验证成本函数的 RMSE 或 MSE。

我将尝试使用 .fit()!

谢谢!

Jason 和 Silvan,您好,

您能否告诉我“pipeline.fit(X,Y)”是否放置在正确的位置?

如果我错了,请纠正我。

numpy.random.seed(seed)

estimators = []

estimators.append(('standardize', StandardScaler()))

estimators.append((‘mlp’, KerasRegressor(build_fn=larger_model, nb_epoch=50, batch_size=5, verbose=0)))

pipeline = Pipeline(estimators)

pipeline.fit(X,Y)

kfold = KFold(n_splits=10, random_state=seed)

results = cross_val_score(pipeline, X, Y, cv=kfold)

print(“Larger: %.2f (%.2f) MSE” % (results.mean(), results.std()))

谢谢!

不需要 pipeline.fit,因为您正在使用 kfold 交叉验证来评估管道。

亲爱的 Jason,

我有几个问题。我正在对一个数据集运行更宽的神经网络,该数据集对应于更准确地模拟商店进出人数。我得到 Wider: 24.73 (7.64) MSE。<– 您能准确解释这些值是什么意思吗?

此外,您能否建议其他改进神经网络的方法?我是否必须根据不同的拓扑方法不断迭代和调整?

另外,您使用什么确切的函数来预测没有真实值的新数据?是 sklearn 的 model.predict(X),其中 X 是新数据集,维度少一维,因为没有输出?您能否详细阐述并解释?我将非常感激。

谢谢你

你好 Rahul,

该模型报告均方误差 (MSE)。它同时报告了 10 个交叉验证折的性能的平均值和标准差。这可以让你了解新数据上性能结果的预期范围。

我建议尝试不同的网络配置,直到找到适合您问题的设置。对于网络配置没有好的规则。

您可以使用 model.predict() 进行新预测。您说得对。

嘿!Jason。

在机器学习方面做得很好。我在这里学到了一切。

一个问题。

当我们说必须先训练模型,然后进行预测时,我们是否试图确定有多少层和多少神经元,以及其他 Keras 属性,以获得最佳拟合……然后将相同的属性用于预测数据集?

根本问题:我们是否试图在训练模型时确定哪些 Keras 属性适合我们的模型?

一般来说,我们想要一个能在新数据上做出良好预测的模型,而我们不知道答案。

我们会在测试数据上评估不同的模型和模型配置,以了解模型在进行新数据预测时会有何表现,这样我们就可以挑选出我们认为会表现良好的一个或几个模型。

这有帮助吗?

嗨,Jason,

感谢您提供的出色教程。

我在 Ubuntu 机器上重新运行了代码,并在 TITAN X GPU 上运行。虽然我在第 4.1 节的实验中得到了类似的结果,但第 4.2 节的结果与您的不同。

Larger: 103.31 (236.28) MSE

no_epoch 为 50,batch_size 为 5。

这种情况可能会发生,很难控制 Keras 中的随机数生成器。

请看这篇文章

https://machinelearning.org.cn/randomness-in-machine-learning/

嗨,Jason,

感谢分享这些有用的教程。两个问题:

1) 如果回归模型计算误差并将其作为结果返回(对此无疑),那么当“verbose=1”时,每个 epoch 打印出的“准确率”值是什么?

2) 使用那些预测值(fit.predict() 或 cross_val_predict),计算最接近预测结果的值并计算准确率是否有意义?(这样,可以计算多个准确率:最接近 2 个、最接近 3 个... 的准确率)

你好 A. Batuhan D.,

1. 对于回归问题,您不能打印准确率,这没有意义。它应该是损失或误差。

2. 同样,准确率对于回归没有意义。听起来您描述的是一个基于实例的回归模型,例如 kNN?

你好 jason,

1. 我知道,计算回归问题的准确率没有意义,但是在使用 Keras 库并设置 verbose=1 时,函数会与损失值一起打印准确率值。我想问一下这种情况的原因。这令人困惑。在您的示例中,verbose 参数设置为 0。

2. 我所做的是计算一些向量。作为输入,我使用向量(例如短语的嵌入词向量),并尝试计算一个向量(下一个词预测)作为输出(可能不属于字典中的任何已知向量,而且很可能不是)。之后,我通过余弦距离方法搜索字典中最接近网络计算出的向量。我个人认为,计算模型预测向量中与真实词向量(例如下一个词向量)最相似的向量比字典中的其他向量,可能可以得到合理的准确率。这是我的做法的简要总结。我认为这与基于实例的回归模型无关。

谢谢。

对于回归问题打印准确率非常奇怪。我从未见过,也许是 Keras 的一个新 bug?

您能否粘贴一个简短的代码+输出示例?

你好,

我尝试了这个教程 - 但它崩溃了,错误如下:

回溯(最近一次调用)

File “Riskind_p1.py”, line 132, in

results = cross_val_score(estimator, X, Y, cv=kfold)

File “C:\Python27\lib\site-packages\sklearn\model_selection\_validation.py”, line 140, in cross_val_score

for train, test in cv_iter)

File “C:\Python27\lib\site-packages\sklearn\externals\joblib\parallel.py”, line 758, in __call__

while self.dispatch_one_batch(iterator)

File “C:\Python27\lib\site-packages\sklearn\externals\joblib\parallel.py”, line 603, in dispatch_one_batch

tasks = BatchedCalls(itertools.islice(iterator, batch_size))

File “C:\Python27\lib\site-packages\sklearn\externals\joblib\parallel.py”, line 127, in __init__

self.items = list(iterator_slice)

File “C:\Python27\lib\site-packages\sklearn\model_selection\_validation.py”, line 140, in

for train, test in cv_iter)

File “C:\Python27\lib\site-packages\sklearn\base.py”, line 67, in clone

new_object_params = estimator.get_params(deep=False)

TypeError: get_params() got an unexpected keyword argument ‘deep’

有人在 StackOverflow 上发帖问了同样的问题。

任何帮助不胜感激。

听到这个消息我很难过。

您正在使用哪个版本的sklearn、Keras和tensorflow或theano?

在更新到Keras 1.2.1后,我也遇到了同样的问题。对我来说:theano是0.8.2,sklearn是0.18.1。

我可能是错的,但这可能是Keras最新版本的一个问题……

好的,我认为我已经解决了这些问题。我认为问题出在不同版本的包之间发生了冲突。解决所有问题的方法是创建一个环境。我已经在stack overflow上发布了一个解决方案,@Partha,在这里:http://stackoverflow.com/questions/41796618/python-keras-cross-val-score-error/41832675#41832675

我的版本分别是theano的0.8.2、sklearn的0.18.1和keras的1.2.1。

我在另一台机器上进行了新的anaconda安装,并在那里奏效了。

谢谢,

谢谢David,我会看看那篇文章。

你好David,我已经重现了该故障并了解了原因。

该错误是由Keras 1.2.1中的一个bug引起的,我有两个潜在的修复方案。

我在这里写了问题和解决方案

http://stackoverflow.com/a/41841066/78453

谢谢,我会调查并尝试重现。

你好,

是的,Jason的解决方案是正确的。我的解决方案之所以有效,是因为在环境中安装的Keras版本是1.1.1,而不是带有bug的版本(1.2.1)。

很棒的教程,非常感谢!

只是想知道如何训练一个标准化数据集(如第3节所示),但使用scikit-learn Pipeline生成实际的(即非标准化的)预测?

好问题Andy,

标准化发生在pipeline内部,它可以根据需要反转变换。这是使用sklearn Pipeline的好处之一。

很棒的教程,非常感谢!

如何在第3节中使用pipeline进行拟合后(pipeline.fit(X,Y)),恢复实际(非标准化)的预测?我相信pipeline.predict(testX)会产生一个标准化的预测Y?

我看到Pipeline有一个inverse_transform方法,但它似乎只用于还原转换后的X。

谢谢你的帖子……

我目前在回归问题上遇到一些麻烦,就像你这里描述的一样。

你似乎同时对输入和输出进行了归一化,但如果输出需要被另一个组件使用,你该怎么做?……取消归一化?如果是这样,误差是否也会按比例放大?

我目前正在进行将帧音频映射到MFCC特征的工作。

我尝试了许多不同的网络结构……CNN,多层……

我最近尝试在最后添加一个线性层……哇……效果惊人……它一直在下降,为什么?……你有什么想法吗?

你好James,是的,在输出被使用之前必须对其进行反归一化(反转任何数据预处理过程)。

如果数据预处理过程是分开的,你可以跟踪Python对象(或系数),并对预测进行临时反过程。

有没有办法使用pipeline,同时还能绘制kerasregressor的MSE随epoch变化的曲线?

据我所知Sarick没有。如果你找到了方法,请告诉我。

你能告诉我如何进行卷积神经网络回归吗?

好问题Aritra。

您可以使用标准的CNN结构,并通过修改示例来使用线性输出函数和合适的回归损失函数。

你好 Jason,

我假设如果您使用CNN,是否必须重塑输出,或者不呢?

如果数据是表格型数据,例如像Excel那样的表格,那么CNN就不合适了。

如果是序列数据,例如时间序列,那么本教程将向您展示如何操作。

https://machinelearning.org.cn/how-to-develop-convolutional-neural-network-models-for-time-series-forecasting/

嗨,Jason,

您能否告诉我如何决定batch_size?有没有什么经验法则?

好问题kono。

通常,我将其视为一个需要为问题优化的参数,就像学习率一样。

这些帖子可能会有帮助

随机梯度下降的批次大小应该有多大?

http://stats.stackexchange.com/questions/140811/how-large-should-the-batch-size-be-for-stochastic-gradient-descent

神经网络中的批次大小是什么?

http://stats.stackexchange.com/questions/153531/what-is-batch-size-in-neural-network

嗨,Jason,

我看到有些人使用fit_generator来训练MLP。您能否告诉我何时使用fit_generator(),何时使用fit()?

你好kono,当使用Data Generator时,例如图像增强,就会使用fit_generator()。

https://machinelearning.org.cn/image-augmentation-deep-learning-keras/

嗨,Jason,

感谢您的帖子。我使用了您的两个帖子,以及一个关于GridSearchCV的帖子,以获得带有Pipeline的keras回归工作流程。

我的问题是如何在pipeline上获取已拟合的keras regressor的权重矩阵和偏置向量?

(我的帖子不断被拒绝/消失,我是否违反了该网站的某些协议/规则?)

评论是经过审核的,这就是为什么您似乎没有立即看到它们。

要访问权重,我建议训练一个独立的Keras模型,而不是使用KerasClassifier和sklearn Pipeline。

你好,

感谢您提供的优秀示例!作为一个初学者,这是最好的开始。

但我有一些问题

在更宽的拓扑结构中,拥有更多的神经元意味着什么?

例如,在我的输入层我“接收”150个维度/特征(input_dim),并输出250个维度(output_dim)。那100个“额外”的神经元(它们会传播到下一个隐藏层)是什么?

祝好,

Pedro

你好Pedro,

神经元是单个学习单元。一层由神经元组成。

输入层的大小必须与输入变量的数量匹配。输出层的大小必须与输出变量的数量匹配,如果是分类问题,则匹配输出类的数量。

隐藏层的数量可以变化,隐藏层中神经元的数量也可以变化。这就是为特定问题配置神经网络的艺术。

这有帮助吗?

你好,

在您的更宽泛的示例中,输入层与输出的输入变量/特征数量不匹配

model.add(Dense(20, input_dim=13, init=’normal’, activation=’relu’))

所以我的问题是:除了13个输入特征之外,这个(输入)层输出的7个神经元里有什么?

你好Pedro,我不确定我是否理解,抱歉。

该示例将13个特征作为输入。输入层(input_dim)期望13个输入值。第一个隐藏层将这些加权输入组合20次或20种不同的方式(层中有20个神经元),每个神经元输出一个值。这些被组合成一个神经元(可怜的家伙!)它输出一个预测。

你好,

是的,我现在明白了(我不确定输入层也是隐藏层)。再次感谢

输入层与第一个隐藏层是分开的。Keras API会让人混淆,因为它们都在同一行上指定。

嗨,Jason,

你说激活函数不是必需的,因为我们想要一个数值作为我们网络的输出。我一直在看循环网络,特别是这个指南:https://deeplearning4j.org/lstm。它建议在输出处使用恒等激活函数。我想知道你的方法:使用Dense(1)作为输出层,与在网络输出处添加恒等激活函数:Activation(‘linear’)之间有什么区别?我应该在什么情况下使用恒等激活层?你能详细说明一下吗?

对于本教程,网络将具有身份函数

model = Sequential()

model.add(Dense(13, input_dim=13, init=’normal’, activation=’relu’))

model.add(Dense(6, init=’normal’, activation=’relu’))

model.add(Dense(1, init=’normal’))

model.add(Activation(‘linear’))

此致,

Bartosz

确实,示例默认使用线性激活函数。

嗨,Jason,

我目前的理解是,我们只在训练集上拟合+转换缩放,而在测试集上只转换不拟合。如果我们像您一样在CV中使用pipeline。我们是否确保对于每个CV,缩放只针对9个训练集进行拟合,而转换在没有拟合的情况下应用于测试集?

非常感谢!

绝佳的问题。

Pipeline为我们做了这件事。在每个CV折叠中,它会被拟合然后应用于训练集,然后拟合变换被应用于测试集以评估模型在折叠上的表现。这是sklearn内置的一个很棒的自动模式。

嗨!我运行了您的代码和您的数据,我们得到了不同的MSE。我应该担心吗?谢谢帮忙!

一般来说不应该担心,机器学习算法是随机的。

更多细节在此

https://machinelearning.org.cn/randomness-in-machine-learning/

嗨 Jason

运行上述代码时,我发现错误是

Y = dataset[:,25]

IndexError: index 25 is out of bounds for axis 1 with size 1

我已经声明了X和Y

X = dataset[:,0:25]

Y = dataset[:,25]

请帮我解决这个问题

嗨Jason,感谢您的精彩文章!

我正在处理相同的问题[样本数:460000,特征数:8],但是我的目标列输出具有非常大的值,例如在20000到90000之间!

我尝试了不同的NN架构[从大到小],使用了不同的批次大小和epoch,但仍然没有获得良好的准确性!

我需要标准化我的目标列吗?请帮我解决这个问题!

感谢您的时间!

是的,您必须对输入和输出数据进行重新缩放。

嗨Jason,感谢您的回复!

是的,我尝试了各种方法来重新缩放我的数据,使用了

https://machinelearning.org.cn/prepare-data-machine-learning-python-scikit-learn/

url但我仍然只获得了20%的准确率!

我尝试了不同的NN拓扑结构,使用了不同的批次大小和epoch,但没有取得好结果!

我的代码

inputFilePath = “path-to-input-file”

dataframe = pandas.read_csv(inputFilePath, sep=”\t”, header=None)

dataset = dataframe._values

# 分割为输入 (X) 和输出 (Y) 变量

X = dataset[:,0:8]

Y = dataset[:,8]

scaler = StandardScaler().fit(X)

X = scaler.fit_transform(X)

maxnumber = max(Y) #我找到的最大数字是:79882.0

Y=Y / maxnumber

# 创建模型

model = Sequential()

model.add(Dense(100, input_dim=8, init=’normal’, activation=’relu’))

model.add(Dense(100, init=’normal’, activation=’relu’))

model.add(Dense(80, init=’normal’, activation=’relu’))

model.add(Dense(40, init=’normal’, activation=’relu’))

model.add(Dense(20, init=’normal’, activation=’relu’))

model.add(Dense(8, init=’normal’, activation=’relu’))

model.add(Dense(6, init=’normal’, activation=’relu’))

model.add(Dense(6, init=’normal’, activation=’relu’))

model.add(Dense(1, init=’normal’,activation=’relu’))

model.compile(loss=’mean_absolute_error’, optimizer=’adam’, metrics=[‘accuracy’])

# 检查点

model.fit(X, Y,nb_epoch=100, batch_size=400)

# 4. 评估网络

loss, accuracy = model.evaluate(X, Y)

print(“\nLoss: %.2f, Accuracy: %.2f%%” % (loss, accuracy*100))

我尝试了MSE和MAE作为损失函数,以及adam和rmsprop优化器,但仍然没有获得准确率!

请帮帮我!谢谢

对于如此深的网络,100个epoch是不够的。可能需要数百万个。

你好Jason,感谢您的回复!

如何在数百万个epoch后确保获得输出,因为在10000个epoch后准确率仍然是0.2378!

如何动态决定神经网络的层数和神经元大小?有没有办法?

我已经使用了神经网络检查点机制来确保其在验证集上的准确性!

我的代码如下

model.compile(loss=’mean_absolute_error’, optimizer=’adam’, metrics=[‘accuracy’])

checkpoint = ModelCheckpoint(save_file_path, monitor=’val_acc’, verbose=1, save_best_only=True, mode=’max’)

callbacks_list = [checkpoint]

model.fit(X_Feature_Vector, Y_Output_Vector,validation_split=0.33, nb_epoch=1000000, batch_size=1300, callbacks=callbacks_list, verbose=0)

如果我遗漏了什么,请告诉我!

看起来不错。

有神经网络增长和修剪算法,但我没有教程,抱歉。

请看书:《神经网络史密斯》http://amzn.to/2oOfXOz

嗨,Jason,

感谢这篇很棒的教程。

我认为有一个小的错误,在提供epoch数量作为参数时,文档显示它应该提供为

estimator = KerasRegressor(build_fn=baseline_model, epochs=100, batch_size=5, verbose=0)。

当提供

estimator = KerasRegressor(build_fn=baseline_model, nb_epoch=100, batch_size=5, verbose=0)

时,函数不识别该参数,只是忽略它。

你能确认吗?

我正在使用您的“如何在Python中使用Keras进行深度学习模型的超参数网格搜索”教程,并在调整epoch数量时遇到问题。如果我通过一个简单的交叉验证检查网格搜索CV的结果,我得到的折叠次数相同,结果完全不同。那里可能有一个类似的错误?

感谢您的时间!

您可以传递任何您想要的参数

https://keras.org.cn/scikit-learn-api/

您每次运行都会得到不同的结果,因为神经网络的行为是随机的。这篇文章会有帮助。

https://machinelearning.org.cn/randomness-in-machine-learning/

https://keras.org.cn/scikit-learn-api/ 准确说明了epoch的数量应该通过epochs=n给出,而不是nb_epoch=n。当给出后者时,函数会忽略该参数。例如

np.random.seed(seed)

estimators = []

estimators.append(('standardize', StandardScaler()))

estimators.append((‘mlp’, KerasRegressor(build_fn=baseline_model, nb_epoch=’hi’, batch_size=50, verbose=0)))

pipeline = Pipeline(estimators)

kfold = KFold(n_splits=10, random_state=seed)

results = cross_val_score(pipeline, X1, Y, cv=kfold)

print(“Standardized: %.5f (%.2f) MSE” % (results.mean(), results.std()))

不会引发任何错误。

我是否错过了什么?

我得到的结果差异很大,而且我认为这不能归因于神经网络行为的随机性。

谢谢Charlotte,这看起来是Keras 2.0的一个近期更改。我将很快更新示例。

谢谢!

嗨,Jason,

我尝试了第一部分,并且基线得到了不同的结果。

我发现

estimator = KerasRegressor(build_fn=baseline_model, nb_epoch=100, batch_size=5, verbose=0)

对我来说不起作用,因为它默认取10个epoch。当我将其更改为epochs=100时,它就能工作。

我刚读了上面的评论,似乎他们在API中更改了这一点。

神经网络是一种随机算法,每次运行时都会产生不同的结果(除非您固定种子并使其他所有内容都相同)。

请看这篇文章

https://machinelearning.org.cn/randomness-in-machine-learning/

嗨,Jason,

我如何获得回归系数?

使用优化算法来“找到它们”。

随机梯度下降与线性回归可能是个开始

https://machinelearning.org.cn/simple-linear-regression-tutorial-for-machine-learning/

嗨,Jason,

如果不是线性回归,我该如何找到回归系数?以及如何推导出输入属性和输出之间的关系,而不一定是线性的关系?

只有对于线性回归等线性算法,您才有回归系数。

亲爱的 Jason,

感谢您的教程!!

我在一个粒子物理学项目中实现了它,我有2个问题。

1)假设我的目标是T=a/b(T=true_value/reco_value)。如果我同时将“a”和“b”作为特征输入回归模型,那么它应该能每次都找到正确的解决方案,对吧?或者是否有某种避免过度拟合的程序,不允许获得100%精确的结果?我问是因为我尝试了,并且获得了“良好”的表现,而不是我期望的最优表现(如果它有“a”和“b”,它应该能在测试集中也以100%的精度找到正确的T)。如果我移除了b,并添加其他特征,那么y_hat/y_test的值会达到0.75,这意味着回归模型存在偏差。你能帮我理解这两件事吗?

2)我想保存回归模型以便以后使用。训练后,我执行:a)estimator.model.save_weights 和 b)open(‘models/’+model_name, ‘w’).write(estimator.model.to_json())。

Estimator是“estimator = KerasRegressor(build_fn=baseline_model, nb_epoch=100, batch_size=50, verbose=1)”。我如何稍后使用这两个文件直接进行预测?

非常感谢,

Luca

抱歉,我不确定我是否理解您第一个问题,也许您可以简要重述一下?

请参阅这篇关于保存和加载keras模型的帖子。

https://machinelearning.org.cn/save-load-keras-deep-learning-models/

嗨,Jason,

我的观点是这样的。回归模型是在一组特征(一组浮点数)上训练的,它提供一个单一的输出(一个浮点数),即目标。在训练过程中,回归模型会学习如何根据特征来猜测目标。

当然,目标不应该是特征的函数,否则问题就太简单了,但我尝试测试这种情况作为初步检查。我所做的是(作为测试)定义一个目标,它就是两个特征的除法,即我将“a”和“b”提供给回归模型,并告知要找到的目标是a/b。在这种简单的情况下,回归模型应该足够聪明,在训练过程中就能理解我的目标就是a/b。所以,在测试中,它应该能够以100%的精度找到正确的值,即通过除以两个特征。我发现回归模型找到的值(y_hat)接近a/b,但并非完全等于a/b。所以我很想知道为什么回归模型的行为是这样的。

谢谢,

Luca

这是一个很棒的问题。

最多,机器学习可以近似一个函数,有些近似比其他近似更好。

这是我能给出的最好的答案。

嗨,Jason,

感谢您的帖子,我真的很喜欢它们。我有一个快速的问题:如果我想使用sklearn的GridSearchCV和

model.compile(loss=’mean_squared_error’

在我的模型中,最高的分数是否对应于具有*最高*MSE的组合?

如果是这样,我想 GridSearchCV 中有一个方法可以反转评分?

使用MSE时,您将希望找到导致最低误差的配置,即最低的均方误差。

亲爱的Jason

我有一个数据文件,包含7个变量,6个输入和一个输出

#from sklearn.cross_validation import train_test_split

#rain, test = train_test_split(data2, train_size = 0.8)

#train_y= train[‘Average RT’]

#train_x= train[train.columns.difference([‘Average RT’])]

##test_y= test[‘Average RT’]

#est_x= test[test.columns.difference([‘Average RT’])]

x=data2[data2.columns.difference([‘Average RT’])]

y=data2[‘Average RT’]

print x.shape

print y.shape

(1035, 6)

(1035L,)

# 定义基本模型

def baseline_model()

# 创建模型

model = Sequential()

model.add(Dense(7, input_dim=7, kernel_initializer=’normal’, activation=’relu’))

model.add(Dense(1, kernel_initializer=’normal’))

# 编译模型

model.compile(loss='mean_squared_error', optimizer='adam')

return model

# 设置随机种子以保证结果可复现

#seed = 7

#numpy.random.seed(seed)

# 使用标准化数据集评估模型

estimator = KerasRegressor(build_fn=baseline_model, nb_epoch=100, batch_size=5, verbose=0)

kfold = KFold(n_splits=5, random_state=seed)

results = cross_val_score(estimator, x,y, cv=kfold)

print(“Results: %.2f (%.2f) MSE” % (results.mean(), results.std()))

但遇到了以下错误

ValueError: Error when checking input: expected dense_15_input to have shape (None, 7) but got array with shape (828, 6)

我也尝试更改

model.add(Dense(7, input_dim=7, kernel_initializer=’normal’, activation=’relu’))

推广到

model.add(Dense(6, input_dim=6, kernel_initializer=’normal’, activation=’relu’))

因为总共有7个变量,其中6个是输入,第7个Average RT是输出。

你能帮帮我吗?

你能帮帮我吗?

输出和输入之间也存在非线性关系,因为我正在尝试使用Keras神经网络自行开发这种非线性关系。

如果您有6个输入和1个输出,您将有7行。

您可以这样分离您的数据:

然后,您可以配置神经网络的输入层,使其期望6个输入,方法是将“input_dim”设置为6。

这有帮助吗?

亲爱的Jason

如果我有2个输出,可以这样写吗?

y = data[:, 0:6]

y = data[:, 6:7]

?

不太对。

您可以从矩阵中检索2列并将其分配给y,使y现在是2列和n行。

也许先熟悉一下numpy数组切片?

先生,请给我一份“使用反向传播技术和Simodal激活函数进行成本估算”的代码。

请看这篇文章

https://machinelearning.org.cn/implement-backpropagation-algorithm-scratch-python/

嗨,Jason,

我是深度学习的新手,感谢这个令人印象深刻的教程。但是,我有一个关于深度学习方法的重要问题。

我们如何像Lasso或其他特征选择方法一样解释这些特征?

在我的项目中,我有大约20000个特征,并且我想使用深度学习方法选择或排名这些特征。我们该怎么做?

谢谢!

很好的问题。

我建议将特征选择作为预处理步骤。

以下是有关特征选择的更多信息。

https://machinelearning.org.cn/an-introduction-to-feature-selection/

你好,

非常感谢您的帖子。

在这个框架中是否有办法实现Tweedie回归?

A

抱歉,我没听说过“Tweedie回归”。

你好,

谢谢分享。

我遇到了一个问题,不知道如何处理。

当进入“results = cross_val_score(estimator, X, Y, cv=kfold)”时,我收到以下警告

C:\Program Files\Anaconda3\lib\site-packages\ipykernel\__main__.py:11: UserWarning: Update your

Densecall to the Keras 2 API:Dense(13, input_dim=13, kernel_initializer="normal", activation="relu")C:\Program Files\Anaconda3\lib\site-packages\ipykernel\__main__.py:12: UserWarning: Update your

Densecall to the Keras 2 API:Dense(1, kernel_initializer="normal")C:\Program Files\Anaconda3\lib\site-packages\keras\backend\tensorflow_backend.py:2289: UserWarning: Expected no kwargs, you passed 1

kwargs passed to function are ignored with Tensorflow backend

warnings.warn(‘\n’.join(msg))

我尝试更新Anaconda及其所有包,但无法修复。

嗨,Jason,

我有一个关于神经网络回归的经典问题,但我还没有找到明确的答案。我见过神经网络在图像分类等方面表现出的出色性能,但仍然对其在回归中的性能持怀疑态度。事实上,我测试了两种数据情况:线性和非线性,2个输入和1个输出,带有随机偏差,但性能不如SVM或Gradient Boosting等其他经典机器学习方法……那么,对于回归,我们应该应用哪种数据类型的神经网络?数据的复杂性越高,其性能是否会更好?

提前感谢您的回答。祝您有美好的一天🙂

深度学习在回归方面效果很好,但需要更大/更难的问题以及更多的数据。

对于小问题,更适合传统的线性甚至非线性方法。

谢谢你,Jason。

回到您的示例,我有一个关于每个隐藏层中神经元数量和隐藏层数量的问题。我读到了一些建议,例如隐藏层神经元的数量是输入层大小的2/3,并且神经元数量应该是(a)介于输入层和输出层大小之间,(b)设置为接近(输入+输出)* 2/3,或者(c)不超过输入层大小的两倍以防止过拟合。我对这些约束表示怀疑,因为我没有找到任何数学证明。

在您的示例中,我将层数增加到7层,并且在每层中使用大量神经元(大约300-200),在5000个epoch中得到了MSQ为0.1394。那么,您在构建网络时是否对这些数字有任何条件?

不,通常神经网络的配置是反复试验,并有一个强大的测试平台。

嗨Jason。我可以在Autoencoders上应用回归吗?

是的,但我没有示例,抱歉。

嗨 Jason

感谢您出色的教程代码!我有一些关于正则化和核初始化器的问题。

我想在更新权重时添加L1/L2正则化。我应该在哪里放置命令?

我还有一个关于分配“kernel_initializer=’normal’”的问题,有必要初始化正态核吗?

谢谢!

KK

这是一个关于权重正则化的例子

https://machinelearning.org.cn/use-weight-regularization-lstm-networks-time-series-forecasting/

我建议在您的项目上评估不同的权重初始化方案。

谢谢 Jason。

我还有一个问题。我将使用convolution2D和dropout。如果我的模型中有dropout,我还需要使用L1/L2正则化吗?

谢谢!

KK

尝试有和没有,并比较性能。

尊敬的博士,

我需要您帮忙,关于如何使用预训练的Keras顺序模型进行NER,输入文本。

例如,如果“word1 word2 word3.”是一个包含三个单词的句子,我如何将其转换为Keras期望的numpy数组,以便从加载的预训练Keras模型中为每个单词的NE标签集进行预测。

此致,

首先将单词转换为整数。

我每次都得到一个大于58的比率。

这是使用的确切代码

#Dependencies

from numpy.random import seed

seed(1)

import pandas

来自 keras.models import Sequential

from keras.layers import Dense

from keras.wrappers.scikit_learn import KerasRegressor

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import KFold

from sklearn.preprocessing import StandardScaler

from sklearn.pipeline import Pipeline

# 加载数据集

dataframe = pandas.read_csv(“housing.csv”, delim_whitespace=True, header=None)

dataset = dataframe.values

# 分割为输入 (X) 和输出 (Y) 变量

X = dataset[:,0:13]

Y = dataset[:,13]

# Basic NN model using Keras

def baseline_model()

# 创建模型

model = Sequential()

model.add(Dense(13, input_dim=13, kernel_initializer=’normal’, activation=’relu’))

model.add(Dense(1, kernel_initializer=’normal’))

# 编译模型

model.compile(loss='mean_squared_error', optimizer='adam')

return model

#seed = 1

# 使用标准化数据集评估模型

estimator = KerasRegressor(build_fn=baseline_model, nb_epoch=100, batch_size=5, verbose=0)

#kfold = KFold(n_splits=10, random_state=seed)

results = cross_val_score(estimator, X, Y, cv=10)

print(“Results: %.2f (%.2f) MSE” % (results.mean(), results.std()))

您说的“大于58的比率”是什么意思?

非常感谢,

如果我们想使用CNN,我们不能用CNN代替Dense层吗?如果我想使用CNN,我应该使用conv2d还是简单的conv?

在使用深度架构的回归问题中,我们可以像使用图像一样使用AlexNet、VGGNet等吗?

我将非常感谢您能在此方面提供示例。

此致

我不推荐CNN用于回归。我推荐MLP。

您的输入数据的形状(1D,2D,…)将决定使用哪种类型的CNN。

为什么你推荐MLP而不是CNN?

CNN用于序列数据或图像数据。

很棒的教程!我喜欢保存训练调整过的权重,我该如何做?

本教程将向您展示如何保存网络权重。

https://machinelearning.org.cn/save-load-keras-deep-learning-models/

非常感谢。

我有一个问题。

此教程是否适用于风速预测?

试试看吧。

嗨,感谢您的教程。这里有几个问题。

1. 当我们使用

KerasRegressor(build_fn=baseline_model, nb_epoch=100, batch_size=5, verbose=0)

和

model.fit(x_train, y_train, batch_size=batch_size,epochs=epochs,verbose=1,validation_data=(x_test, y_test))?据我所知,使用KerasRegressor时,我们可以进行CV,而在model.fit时不能。我说的对吗?两者都会导致相同的MSE等结果吗?

2. 如何使用Keras创建一个预测两个连续输出的神经网络?这里,我们只预测一个输出,那么两个或更多输出呢?如何实现?(多输出回归问题?)

正确,使用sklearn包装器可以让我们对小型模型使用CV等工具。

您可以通过更改输出层中的节点数来获得两个输出。

谢谢您的回复。

这是否意味着,在sklearn包装模型和model.fit(不带sklearn)模型中,如果它们接收相同训练、验证和测试数据集,都能获得相同的mse(假设sklearn包装器只运行第一个折叠)?或者模型背后存在一些差异?

我读了Keras Model类(函数式API)(https://keras.org.cn/models/model/)。Model类的实现,

model = Model(inputs=a1, outputs=[output1, output2])

与在输出层添加一个节点相同吗?如果不是,有什么区别?

底层是相同的keras模型。

from keras.layers.core import Dense,Activation,Dropout

from json import load,dump

from sklearn.metrics import mean_squared_error

from sklearn.metrics import mean_absolute_error

来自 keras.models import Sequential

from keras2pmml import keras2pmml

from pyspark import SparkContext,SparkConf

from pyspark.mllib.linalg import Matrix, Vector

from elephas.utils.rdd_utils import to_simple_rdd,to_labeled_point

from elephas import optimizers as elephas_optimizers

from elephas.spark_model import SparkModel

from CommonFunctions import DataRead,PMMLGenaration,ModelSave,LoadModel,UpdateDictionary,ModelInfo

from keras import regularizers

from sklearn.metrics import r2_score

from keras.optimizers import SGD

#from keras.models import model_from_config

#from keras.utils.generic_utils import get_from_module

class SNNReg

def train(self,sc,xml,data,hdfs_path)

## Variable initialization ##

hActivation = xml.HiddenActivation

#print hActivation

nodeList = map(int,(xml.NodeList.split(“,”)))

#print nodeList

Accuracy = xml.Accuracy

#print Accuracy

lossFn = xml.LossFunction

#print nodeList

optimi = xml.Optimizer

#print optimi

hCount = int(xml.HiddenNodeCount)

#print hCount

inputDim = int(xml.InputDimension)

opNodes = int(xml.OutputNodes)

print (‘opNodes’,opNodes)

nbEpoch = int(xml.NumEpoch)

batchSize = int(xml.BatchSize)

#settings default paramerters if not the provided the values for it

if hActivation==””

hActivation=”relu”

if lossFn==””

lossFn=”mean_squared_error”

if optimi==””

optimi=”adam”

if Accuracy==””

Accuracy=”Accuracy”

print “now going to read ”

#print(“lossFn”,lossFn)

X,Y = DataRead(self,xml.NeuralNetCategory,xml.NeuralNetType,data,xml.ColumnNames,xml.TargetColumnName,xml.InputDimension)

# Creating a sequential model for simple neural network

model=Sequential()

model.add(Dense(nodeList[0],input_dim = inputDim,init=’normal’,activation =hActivation ))

# Creating hidden model nodes based on the hidden layers count

if hCount > 1

for x in range(1,hCount)

model.add(Dense(nodeList[x],init=’normal’,activation = hActivation))

model.add(Dense(opNodes,activation=’linear’))

# 编译模型

print “model complilation stage”

model.compile(loss = lossFn, optimizer=optimi)

rdd =to_simple_rdd(sc,X,Y)

print rdd

#adam= elephas_optimizers.Adam()

adam = elephas_optimizers.Adam()

#adagrad = elephas_optimizers.Adagrad()

#adadelta = elephas_optimizers.Adadelta()

#print (“type of rdd”,type(rdd))

print “now going to create spark model using elphass”

# Creating Spark elephas model from the spark model

print(“no of workers”,int(sc._conf.get(‘spark.pangea.ae.workers’)))

sparkModel = SparkModel(sc,

model,

optimizer=adam,

frequency=’epoch’,

mode=’asynchronous’,

master_loss=lossFn,

num_workers=int(sc._conf.get(‘spark.pangea.ae.workers’)))

# Train Spark model

print “now it is going to run train fucntion”

sparkModel.train(rdd,nb_epoch=nbEpoch, batch_size=batchSize)

我试图以分布式方式在Python中使用elphas和keras在神经网络中实现回归,但在训练过程中,我得到了过高的损失值,我该怎么办,请给我任何建议。

抱歉,我无法帮助分布式Keras模型。

两个小点

1. 请在文本中注明需要安装TensorFlow。

2. CSV表示逗号分隔文件,但文件中的数据不是用逗号分隔的。不过这不是什么大问题。

感谢您的建议。

感谢您提供的精彩教程!在帖子中,您使用了“relu”,但我很好奇如何自定义激活函数?

如果您愿意,可以使用 sigmoid 或 tanh。

嗨,Jason,

感谢这个很棒的教程!

深度学习库Keras(假设以TensorFlow为后端)与sklearn的神经网络函数MLPRegressor相比有什么优势?在两种情况下,过程(输入)都非常相似,您需要决定使用哪种架构、激活函数和求解器。

谢谢,

Don

开发速度和社区规模。

感谢您的快速回复!

您能否进一步阐述一下?

当您提到开发速度时,您能举几个实际的例子说明何时重要或您具体指的是什么吗?当您提到社区规模时,您是指Keras/TensorFlow社区比sklearn的更大吗?如果不是,您的意思是什么?

此外,您能否谈谈epochs和batch_size参数?为什么使用epochs而不是公差,这对我来说更有意义?当增加epochs值时,分数有时会降低,这是否合理?

非常感谢!

Don

是的,我相信用Keras开发模型比目前可用的其他工具更容易/更快。

我相信Keras社区非常活跃,这对于保持库的更新和有用非常重要。Keras与sklearn、tensorflow和theano是互补的。

一个epoch是遍历所有训练样本一次。一个epoch由一个或多个批次组成。一个批次涉及在更新网络权重之前遍历一个或多个样本。

我有点困惑。如果你定义x为

X = dataset[:,0:13]

那么X中的最后一列与Y相同。X不应该是

X = dataset[:,0:12]

然后

Y = dataset[:,13]

如果你定义X包含输出,为什么它不会将dataset[0:12]的所有权重设置为零,然后完美地拟合数据,因为它已经知道答案了?

> X = [0,1,2,3,4]

> print(X[0:3])

[0, 1, 2]

结束索引不包含在内。

是的。我收到的类似这样的问题越多,我就越觉得需要一个关于基本numpy语法的帖子。

有哪些方法可以在keras中验证回归模型?您能否帮我一下?

您可以使用拟合模型时的验证数据集来估计模型在未见过的数据上的技能。

请参阅fit()函数的validation_split和validation_data参数。

https://keras.org.cn/models/sequential/

我们如何通过代码来识别keras回归模型和分类模型?

通过输出层激活函数和节点数的选择。

回归将使用线性激活,具有一个输出,并且可能使用mse损失函数。

分类将使用softmax、tanh或sigmoid激活函数,具有每个类一个节点(或二元分类一个节点),并使用log loss函数。

感谢您的教程,我觉得很有帮助。但是,我有一个问题。

当我使用 estimator.fit 中的 checkpoint 回调时,它会保存一个训练最佳的权重,作为一个 hd5 文件。

但我无法加载这个预训练的权重,因为 estimator 没有 keras 模型中的 load_weights 方法。我该怎么办,谢谢!!!

您必须将权重加载为 Keras 模型。

在此教程中了解更多信息

https://machinelearning.org.cn/check-point-deep-learning-models-keras/

你好,Jason

感谢精彩的教程!我从您的博客中学到了很多。

我有一个关于 np.random.seed 的问题。

‘np.random.seed’ 到底做了什么?

您在上面解释了它是为了可复现性,但我不太明白这是什么意思……

谢谢,希望您一切顺利!

祝好,

保罗

许多机器学习算法在设计上是随机的

https://machinelearning.org.cn/randomness-in-machine-learning/

我们可以通过确保每次运行代码时都有相同的随机性来消除教程中的随机性(纯粹为了演示目的)

https://machinelearning.org.cn/reproducible-results-neural-networks-keras/

这不推荐用于实际评估模型

https://machinelearning.org.cn/evaluate-skill-deep-learning-models/

这能帮到 Paul 吗?

您能推荐一下除 relu 之外用于回归神经网络的隐藏激活函数吗?

是的,在 relu 出现之前,sigmoid 和 tanh 已经使用了几十年了。

我给 keras 的回归模型使用了 tanh,但结果不理想,您说 tanh 也支持回归,请您给我一些建议。

不,回归问题请在输出层使用“线性”激活。

当然,输出层我只使用了线性激活函数,但说的是隐藏激活函数,我使用了 relu,如果我使用 tanh 结果就不理想。

很遗憾听到您遇到的问题。我在本帖中列出了一些尝试的建议。

https://machinelearning.org.cn/improve-deep-learning-performance/

嗨,Jason,

现在 Keras 和 Tensorflow 在 R (RStudio) 中可用了,您是否有计划用 R 来做上述教程?我在您的书中看到了您使用 cubist 处理波士顿房价数据集,我很想看到/运行直接的比较,以了解可能改进的空间。

也许将来会的,谢谢 Wayne 的建议。

我的问题是所有东西都隐藏在 Pipeline 对象中。我该如何提取出组件,比如模型的 predict 方法,然后提取出预测值来绘制输入值呢?

不要使用 Pipeline,而是手动传递对象之间的数据。

我已经训练了 keras 模型,我需要 model.predict() 的逻辑,我们如何预测测试数据的值,我有 predict_classes 的逻辑,但没有 predict 的逻辑,您能告诉我 model.predict 的逻辑吗?

def predict_proba(self, X)

a = X

for i in range(self._num_layers)

g = self._activations[i]

W = self._weights[i]

b = self._biases[i]

a = g(np.dot(a, W.T) + b)

print(len(a))

return a

def predict_classes(self, X)

probs = self.predict_proba(X)

print(np.argmax(probs,1))

return np.argmax(probs,1)

predict_classes 是用于分类的。

我需要回归的 predict 逻辑。

您可以使用 predict() 函数

嗨,Jason,

感谢您的博客。我尝试将示例用于我的案例,我尝试构建模型并为音频数据进行评估。我只使用频谱数据。原始数据是 .wav 格式的。

但是,我收到一个错误

“TypeError: can’t pickle NotImplementedType objects”

在 line results = cross_val_score(pipeline, X, Y, cv=kfold)

我的数据非常少,只有 5 个样本。

您对此错误有什么想法吗?

祝好,

Mustafa

我建议您与您获取被序列化数据的人员沟通。

您好 Mustafa,

您的 pipeline 是如何初始化/定义的?我遇到了完全相同的错误消息,是在使用 cross_val_score 和 KerasRegressor 估算器时。当您使用类似

estimator = KerasRegressor(build_fn=myModel, nb_epoch=100, batch_size=5, verbose=0)

与 Keras 模型“myModel”而不是一个名为“myModel”的函数来在编译后返回模型(如教程开头所示),您应该会遇到相同的 Pickle 错误。您可以通过 myModel=baseline_model() 来复现它。

希望这有帮助…

此致,

Heringsalat

为什么我们在回归问题中计算误差而不是准确率?为什么准确率在回归中没有意义?请解释一下。

我们没有使用准确率。我们计算的是误差,特别是均方误差(MSE)。

为什么我们在回归中计算 MSE 而不是准确率呢,先生?

因为这是一个回归问题,准确率只适用于分类问题。

在计算损失和 MSE 时,我在回归中得到的值是相同的,这是因为损失和 MSE 在回归中是相同的还是不同的?如果不同,它们有何不同?请解释一下。

损失是网络最小化的目标。如果您使用 MSE 作为损失,那么您就不需要将 MSE 跟踪为指标。它们将是同一件事。

你好!

我正在尝试训练一个 PPG 信号来估计心率,即 BPM。

您认为遵循此结构是否合适?

如果不合适,能否请您提供建议?

谢谢!

也许吧。也可以考虑时间序列的表述。评估您能想到的所有框架。

您好 Jason!🙂

感谢您发布的精彩帖子!🙂 我有一个关于 StandardScaler 和 Normalization 的问题。

它们有什么区别?另外,我可以使用 Min Max 缩放器而不是 StandardScaler 吗?

提前感谢。

祝好,

保罗

MinMaxScaler 的归一化将数据缩放到 0-1 之间。StandardScaler 的标准化减去均值,使分布的均值为 0,标准差为 1。

标准化适用于高斯分布,而归一化适用于其他情况。

啊哈!谢谢您的回复!🙂

我将尝试 MinMaxScaler()

祝好,

保罗

祝您好运 Paul。

嗨,Jason,

感谢教程,非常有意思。

您能否进一步解释一下为什么使用标准化而不是归一化?

特征是否具有高斯分布?您如何知道特征是否具有高斯分布?

我目前正在处理 Ames Housing 数据集的房价预测:您建议我使用标准化还是归一化?

不客气。

是的,请看这个

https://machinelearning.org.cn/standardscaler-and-minmaxscaler-transforms-in-python/

特征不一定具有高斯分布,但数据是高斯分布时使用标准化是个好主意。

嗨,Jason,

再次,这是一篇非常有信息量的博客。我正在 R 中实现 keras,但找不到 keras regressor 来拟合模型。您是否有解决方案,或者您能推荐一个替代方案吗?

抱歉,我不知道 R 中的 Keras。

嘿 Jason – 感谢这篇帖子。

我很想了解 Keras 提供的其他回归模型以及您对它们用例的看法。

谢谢,

James

James,您是什么意思?您有例子吗?

嗨 David,

感谢教程。这些对实现方面以及了解机器学习在各领域的可能性都非常有帮助。

我尝试运行第 2 部分的代码时遇到了以下错误

………………….

回溯(最近一次调用)

File “regression.py”, line 48, in

results = cross_val_score(estimator, X, Y, cv=kfold)

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/model_selection/_validation.py”, line 321, in cross_val_score

pre_dispatch=pre_dispatch)

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/model_selection/_validation.py”, line 195, in cross_validate

for train, test in cv.split(X, y, groups))

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/externals/joblib/parallel.py”, line 779, in __call__

while self.dispatch_one_batch(iterator)

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/externals/joblib/parallel.py”, line 625, in dispatch_one_batch

self._dispatch(tasks)

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/externals/joblib/parallel.py”, line 588, in _dispatch

job = self._backend.apply_async(batch, callback=cb)

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/externals/joblib/_parallel_backends.py”, line 111, in apply_async

result = ImmediateResult(func)

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/externals/joblib/_parallel_backends.py”, line 332, in __init__

self.results = batch()

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/joblib/parallel.py”, line 131, in __call__

return [func(*args, **kwargs) for func, args, kwargs in self.items]

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/sklearn/model_selection/_validation.py”, line 437, in _fit_and_score

estimator.fit(X_train, y_train, **fit_params)

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/keras/wrappers/scikit_learn.py”, line 137, in fit

self.model = self.build_fn(**self.filter_sk_params(self.build_fn))

File “regression.py”, line 35, in baseline_model

model.add(Dense(13, input_dim=13, kernel_initializer=’normal’, activation=’relu’))

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/keras/layers/core.py”, line 686, in __init__

super(Dense, self).__init__(**kwargs)

File “/home/mjennet/anaconda2/lib/python2.7/site-packages/keras/engine/topology.py”, line 307, in __init__

assert kwarg in allowed_kwargs, ‘Keyword argument not understood: ‘ + kwarg

AssertionError: Keyword argument not understood: kernel_initializer

……………….

我试图深入了解问题,发现 Mr. Partha 描述的问题与我的类似,因此我检查了 Keras 的版本。我使用的 Keras 版本是 1.1.1,后端是 tensorflow(1.2.1)。您能帮我解决这个问题吗?

我叫 Jason。

看起来您需要更新到 Keras 2。

抱歉,Jason 先生

我尝试升级 Keras 和其他依赖项,但仍然出现相同的错误。我目前正在使用 Keras 2.1.1,Numpy 1.13.3 和 scipy 1.0.0。

我很惊讶,因为您的错误表明 Keras 版本较旧。

我在这里列出了 Keras 的一些好用的求助渠道,您可以尝试一下。

https://machinelearning.org.cn/get-help-with-keras/

嗨,Jason,

感谢示例。我也遇到了同样的错误。Keras/Theano/sklearn: 2.1.2/0.90/0.19.1。Mohit,您能调试好吗?

很遗憾听到您遇到这个问题,我通常认为这是版本问题,但您看起来是最新的。

我没有什么好主意,如果您有新发现请告诉我?

你好 Jason,

我在上面的代码上使用了 r2 指标,并发现更宽的模型比更深的模型的得分更好。这是否意味着更宽的模型比更深的更好?r2 分数在这种情况下是否是一个评估回归模型的好指标?

一般来说,神经网络模型是随机的,这意味着它们每次运行的结果可能不同。

https://machinelearning.org.cn/randomness-in-machine-learning/

我通常推荐这种方法来有效评估神经网络。

https://machinelearning.org.cn/evaluate-skill-deep-learning-models/

您好 Jason,我正在使用您在第...

”

import numpy

import pandas

…

”

到这一节的代码

”

kfold = KFold(n_splits=10, random_state=seed)

results = cross_val_score(estimator, X, Y, cv=kfold)

print(“Results: %.2f (%.2f) MSE” % (results.mean(), results.std()))

”

但均值和标准差值总是高于您的结果。

”

结果:60.40 (41.96) MSE

”

问题出在哪里??

机器学习算法是随机的,这可能只是在不同硬件/库版本上的不同结果。

请看这篇文章

https://machinelearning.org.cn/randomness-in-machine-learning/

cross_val_score 的结果

”

[ 10.79553125, 7.68724794, 11.24587975, 27.62757629,

10.6425943 , 8.12384602, 4.93369368, 91.03362441,

13.37441713, 21.56249909]

”

是“均方误差”吗??还是其他什么?

如果是的话,

这个预测模型很糟糕,是吗?

分数是 MSE。您可以取平方根将其转换为 RMSE。

得分好坏取决于基线模型的技能(例如,它们是相对的),以及领域知识(例如,它们的解释)。

我在 cross_val_score 上遇到了问题。每次运行代码时,我都会收到错误

#TypeError: The added layer must be an instance of class Layer. Found

有什么建议吗?

谢谢!

完整输出

回溯(最近一次调用)

File “Y:\Tutorials\Keras_Regression_Tutorial\Keras_Regression_Tutorial\module1.py”, line 39, in

results = cross_val_score(estimator, X, Y, cv=kfold)

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\model_selection\_validation.py”, line 321, in cross_val_score

pre_dispatch=pre_dispatch)

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\model_selection\_validation.py”, line 195, in cross_validate

for train, test in cv.split(X, y, groups))

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\externals\joblib\parallel.py”, line 779, in __call__

while self.dispatch_one_batch(iterator)

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\externals\joblib\parallel.py”, line 625, in dispatch_one_batch

self._dispatch(tasks)

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\externals\joblib\parallel.py”, line 588, in _dispatch

job = self._backend.apply_async(batch, callback=cb)

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\externals\joblib\_parallel_backends.py”, line 111, in apply_async

result = ImmediateResult(func)

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\externals\joblib\_parallel_backends.py”, line 332, in __init__

self.results = batch()

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\joblib\parallel.py”, line 131, in __call__

return [func(*args, **kwargs) for func, args, kwargs in self.items]

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\joblib\parallel.py”, line 131, in

return [func(*args, **kwargs) for func, args, kwargs in self.items]

File “C:\Users\Gabby\y35\lib\site-packages\sklearn\model_selection\_validation.py”, line 437, in _fit_and_score

estimator.fit(X_train, y_train, **fit_params)

File “C:\Users\Gabby\y35\lib\site-packages\tensorflow\contrib\keras\python\keras\wrappers\scikit_learn.py”, line 157, in fit

self.model = self.build_fn(**self.filter_sk_params(self.build_fn))

File “Y:\Tutorials\Keras_Regression_Tutorial\Keras_Regression_Tutorial\module1.py”, line 25, in baseline_model

model.add(Dense(13, input_dim=13, kernel_initializer=’normal’, activation=’relu’))

File “C:\Users\Gabby\y35\lib\site-packages\tensorflow\contrib\keras\python\keras\models.py”, line 460, in add

‘Found: ‘ + str(layer))

TypeError: 添加的层必须是 Layer 类的实例。找到

Press any key to continue . . .

抱歉,我以前没有见过这个错误。

确认您的 Python 库(包括 Keras 和 sklearn)是最新的。

确认您已复制了示例中的所有代码。

您好!非常感谢您的精彩教程。非常有帮助!

但我的问题是:您知道如何在使用 CNN 和 2D 图像时,在 pipeline 中使用 StandardScaler 吗?我的 X 数据形状例如是 (39, 256, 256, 1)。

在没有 StandardScaler 的情况下,它工作得很好,但使用 StandardScaler 时,我会得到以下错误

ValueError: Found array with dim 4. StandardScaler expected <= 2。

您知道如何转换我的输入数据以及在哪里转换才能与 CNN、2D 图像和 StandardScaler 一起使用吗?

我建议使用 Keras 内置的图像数据缩放功能。

https://machinelearning.org.cn/image-augmentation-deep-learning-keras/

非常感谢您的快速回复!很高兴知道 Keras 已经有了用于增强图像的 ImageDataGenerator。

我还有一个问题,您知道如何将神经网络的输出恢复到原始尺度吗?我的意思是,如果 ImageDataGenerator 有类似 sci-kit learn 的 StandardScaler.inverse_transform() 的功能?

我不确定,我认为没有。

如果图像是输入,为什么需要反转操作?

在我的例子中,我的网络输出是基于实际像素值的。我想,在这种情况下,我将直接省略标准化。但感谢您提到 ImageDataGenerator,它在其他情况下对我很有帮助 🙂

你好,

非常感谢您的帖子

我使用了您上传的数据。

但是,当我打印 MSE 时,我注意到:Found input variables with inconsistent numbers of sample [506, 1]。这是数据中的最后一个样本。

请帮帮我

非常感谢

抱歉,我不明白,您能重述一下问题吗?

在第 2 步评估基线模型时,我无法打印,因为出现了那个错误

” Found input variables with inconsistent numbers of sample [506, 1]。这是数据中的最后一个样本。”

也许您应该仔细检查一下是否复制了所有代码?

我的错。我已经用 Excel 中的“文本到列”功能将数据分割成了列。

非常感谢您 🙂

非常感谢您提供的这些文章。有两个问题

1) 您提到“使用了均方误差损失函数……这将是我们用来评估模型性能的相同指标。”我看到了‘mean_squared_error’作为‘loss’传递,但没有传递‘metrics=[…]’参数。如果 Keras 没有指定指标,它是否会自动将‘loss’函数用作指标?

2) 我重新进行了这个实验,并在 KFold 函数中添加了“shuffle=True”参数。这似乎提高了性能,下降到 13.52 (6.99) MSE(更宽的模型)。您对此潜在的优化有什么看法?这似乎“好得不真实”。

谢谢!

是的,Keras 在训练期间会报告损失和指标,这篇帖子可能有助于您理解正在发生的事情。

https://machinelearning.org.cn/custom-metrics-deep-learning-keras-python/

做得很好。

结果可能不是真实的(例如,没有统计学意义),请考虑这种方法来评估深度学习模型的技能。

https://machinelearning.org.cn/evaluate-skill-deep-learning-models/

你好

您创建的 NN 模型包含 1 个输出。

我有一个关于超过 1 个输出的问题。

我想通过修改它来应用此代码。可以吗?

您能提供一些解决方案或注意事项来解决这个问题吗?

非常感谢

是的,您可以更改输出的数量。

你好 Jason,

对于多个输出,我是否仍然使用“model.compile(loss=’mean_squared_error’, optimizer=’adam’)”来编译模型?在多个输出的情况下,代码如何计算均方误差?

谢谢

是的。

您可以选择为每个时间步的输出计算误差,或者为所有时间步一起计算。我在这里对此有所介绍。

https://machinelearning.org.cn/multi-step-time-series-forecasting-long-short-term-memory-networks-python/

如果每个时间步的输出具有不同的单位(或者在简单的密集前馈网络的情况下,在最后有多个输出,每个输出具有不同的测量单位?)。在这种情况下,由于单位不同且输出的数量级范围可能不同,简单地取 RMSE 等可能没有意义。您会建议如何将这些不同的输出合并到一个损失函数中?

我建议在拟合模型之前将输出重新缩放到有意义的范围(例如 0-1)。

嗨,Jason,

我运行此代码时遇到错误。我安装了 karas 2 和 scikit learn .17。我一直收到这个错误

Connected to pydev debugger (build 172.3968.37)

使用 TensorFlow 后端。

回溯(最近一次调用)

File “/home/b/pycharm-community-2017.2.3/helpers/pydev/pydevd.py”, line 1599, in

globals = debugger.run(setup[‘file’], None, None, is_module)

File “/home/b/pycharm-community-2017.2.3/helpers/pydev/pydevd.py”, line 1026, in run

pydev_imports.execfile(file, globals, locals) # 执行脚本

File “/home/b/PycharmProjects/ANN1a/ANN2-Keras1a”, line 6, in

from sklearn.model_selection import cross_val_score

ImportError: No module named model_selection

Backend TkAgg is interactive backend. Turning interactive mode on.

这是说我没有 Sklearn 模块,是因为我只有 .17 而不是当前版本(我认为是 .19)吗?我在更新我的 scikit-learn 包时遇到了很多麻烦。

您需要将 sklearn 更新到 0.18 或更高版本。

嘿 Jason,我需要一些关于这个错误消息的帮助。我不确定它是什么意思。

‘ValueError: could not convert string to float: Close’

我认为它可能指的是我的 dataset.csv 文件中的一个列,名为‘Close’。

代码如下:

import numpy

import pandas

来自 keras.models import Sequential

from keras.layers import Dense

from keras.wrappers.scikit_learn import KerasRegressor

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import KFold

from sklearn.preprocessing import StandardScaler

from sklearn.pipeline import Pipeline

# 加载数据集

dataframe = pandas.read_csv(“PTNprice.csv”, delim_whitespace=True, header=None, usecols=[1,2,3,4])

dataset = dataframe.values

# 分割为输入 (X) 和输出 (Y) 变量

X = dataset[:,0:4]

Y = dataset[:,1]

# 定义模型

def larger_model()

# 创建模型

model = Sequential()

model.add(Dense(100, input_dim=4, kernel_initializer=’normal’, activation=’relu’))

model.add(Dense(50, kernel_initializer=’normal’, activation=’relu’))

model.add(Dense(1, kernel_initializer=’normal’))

# 编译模型

model.compile(loss='mean_squared_error', optimizer='adam')

return model

# 设置随机种子以保证结果可复现

seed = 7

numpy.random.seed(seed)

# 使用标准化数据集评估模型

numpy.random.seed(seed)

estimators = []

estimators.append(('standardize', StandardScaler()))

estimators.append((‘mlp’, KerasRegressor(build_fn=larger_model, epochs=50, batch_size=5, verbose=0)))

pipeline = Pipeline(estimators)

kfold = KFold(n_splits=10, random_state=seed)

results = cross_val_score(pipeline, X, Y, cv=kfold)

print(“Standardized: %.2f (%.2f) MSE” % (results.mean(), results.std()))

您是否使用了教程中的代码和数据?

您是否精确地复制了所有内容,包括缩进?

Jason,

不,我的代码已修改,以尝试处理新的文本数据。我认为数据与原始数据集非常相似。我实际上已经成功运行了,没有错误。我只是将 header=none 改为了 header=1。

代码

# 加载数据集

dataframe = pandas.read_csv(“PTNprice.csv”, delim_whitespace=True, header=1, usecols=[1,2,3,4])

dataset = dataframe.values

# 分割为输入 (X) 和输出 (Y) 变量

X = dataset[:,0:4]

Y = dataset[:,1]

脚本完成时间比预期要长。我正在尝试让它也进行预测,但我的输出不太令人满意。这是它给我的结果。您认为这意味着什么?

输出

Larger: 0.00 (0.00) MSE

[ 0.78021598 0.79241288 0.81000006 …, 3.64232779 3.59621549

3.79605269]

我的数据只是十年期间的股票价格,例如:0.75674 0.9655 3.753 1.0293

列的设置如下。

您可能需要为您的特定问题调整模型,这里有一些关于如何获得更好技能的建议。

https://machinelearning.org.cn/improve-deep-learning-performance/

嗨,Jason,

非常感谢,这些课程很棒,非常有帮助!

我写了代码,跟着您的思路,但唯一的区别是我没有使用 Pipeline,而是单独处理了缩放。

seed = 7

np.random.seed(seed)

X = (X – X.mean(axis=0))/X.std(axis=0)

estimator = KerasRegressor(build_fn=baseline_model, nb_epoch = 100, batch_size=5,verbose=0)

kfold = KFold(n_splits=10,random_state=seed)

results = cross_val_score(estimator, X, y, cv=kfold)

出于某些原因,我无法理解,您的方法总是产生更好的结果。有什么想法为什么它表现更好吗?

非常感谢

这可能是一个统计上的巧合,尝试改变随机种子并重复实验 10 到 30 次,然后取每个模型的平均得分。

这篇帖子提供了更多关于有效评估随机算法的思路。

https://machinelearning.org.cn/evaluate-skill-deep-learning-models/

非常感谢,我会这样做的。

Jason,

只是想来感谢您!

这三天来我一直在调整我的学习模型,这是我的成果

Larger: 0.12 (0.36) MSE

这已经相当不错了吧?我使用的是与您不同的数据集,但结构非常相似。我曾有一个模型欠拟合的问题,错误率高达 500%(500%)。我意识到我需要让它变得更复杂一些。所以我把特征数量增加了三倍,让层更深更宽,并将 epoch 数量增加到 50000,batch size 增加到 10000。我还将分割数量从 10 增加到 25。

问题:我能否获得更低的错误率,或者“Larger: 0.12 (0.36) MSE”是最低的预期值了吗?

再次感谢 Jason,

Brence

干得不错。

我不确定这个问题的极限,只要您有时间和兴趣,就继续尝试吧。在实践中,“好”是相对于您之前取得的成就而言的。这是应用机器学习的一个好教训!

尊敬的先生。

我应用了您的代码并成功用于预测。

与我上一个问题一样。我想再添加一个输出:房屋的年龄:例如,建于 5 年前、7 年前、10 年前……。价格和年龄是独立的。

据我所知,这不是一个分类问题。

所以,您会建议代码还是我下一步该怎么做来解决这个问题,请?

非常感谢

这个回归模型是否可以进行递归多步预测?

我不确定这段代码如何适应这一点。

prediction(t+1) = model(obs(t-1), obs(t-2), …, obs(t-n))

prediction(t+2) = model(prediction(t+1), obs(t-1), …, obs(t-n))

是的,也许这篇帖子可以作为模板。

https://machinelearning.org.cn/multi-step-time-series-forecasting-long-short-term-memory-networks-python/

嗨,Jason,

感谢您的教程。我刚刚尝试运行您第 2 部分的示例代码,但不幸的是得到了负 MSE,这显然没有意义。

结果:-57.82 (42.31) MSE

有什么想法吗?

代码完全相同,只有微小的改动,我不得不更改

model.compile(loss=’mean_square_error’,optimizer=’adam’)

推广到

model.compile(loss=’mse’,optimizer=’adam’)

谢谢

Toby

是的,sklearn 会反转最小化分数以使其最大化以便优化。只需取绝对值即可。

太感谢了。是的,我在提问后就知道了。

不错。

嗨,Jason,

感谢这个精彩的教程。我只想知道有什么方法可以预测神经网络对某些特定 X 值的输出,并通过绘制预测值和实际值来比较性能。

谢谢

Mohit

关于如何以及绘制什么,这确实取决于具体的应用。

嗨,Jason,

首先:感谢您和您所有其他精彩的教程。作为初学者,获得实际有用的建议对我帮助很大。

但是,我遇到了一个需要进一步建议的阶段——希望您能帮助我!

我理解回归和 MSE 的概念——在我的例子中,我试图根据各种其他参数预测两个值。这真的很简单,值之间的相关性也很清楚,所以我不认为这会是一个问题。

现在,当有一个预测值时,我不想知道 MSE,而是想知道预测值是否在原始值的一个特定范围内。

例如

‘可接受’范围:y +/- 0.1

y = 1

y^ = 1.08

y – y^ = |0.08| —> OK,因为它在 y +/- 0.1 范围内。

有没有办法在 Python 或 KERAS 中做到这一点?我刚刚开始使用它,所以任何建议都会有帮助。谢谢!

您可以为线性模型计算置信区间。

我在时间序列的线性回归示例可以为您提供一些思路。

https://machinelearning.org.cn/time-series-forecast-uncertainty-using-confidence-intervals-python/

谢谢!我会看看的。

嗨,Jason,

感谢您的教程。

我想知道

如果一个回归问题数据集有 10000 个特征,input_dim 如此之大……但所有特征都有意义(它是过程数据)且不能删除。

如何修改这个示例来处理我的问题,以及我应该注意什么,有什么技巧吗?

也许您可以使用投影,例如 PCA?SVD?或其他方法?

您好 Jason – 感谢所有这些教程。这些太棒了!!

由于 NN 架构是黑箱。是否有办法访问隐藏层数据进行调试?当我运行回归代码(如上)时,我得到的结果略有不同。再次感谢!

您每次在相同数据上运行相同算法时都会得到不同的数字,Steve。这是特性,不是 bug。

https://machinelearning.org.cn/randomness-in-machine-learning/

我认为您可以访问模型上的层,它们是一个数组:model.layers。

嗨,Jason,

调用 model.predict() 时,预测值在房屋价格方面没有意义。

例如,房价数据集的第 15 行

0.63796 0.00 8.140 0 0.5380 6.0960 84.50 4.4619 4 307.0 21.00 380.02 10.26 18.20

最后一个值 (18.20) 是房屋价格(以千美元为单位)。

Xnew= array([[ 0.63796, 0.00, 8.140, 0, 0.5380, 6.0960, 84.50, 4.4619, 4, 307.0, 21.00, 380.02, 10.26]])

ynew=model.predict(Xnew)

ynew

Out[114]: array([[-0.09053693]], dtype=float32)

-0.09053693 是什么意思?

您能否提供 predict 函数的完整代码?

也许您运行的示例在建模之前缩放了数据,如果是这样,您可以对预测值进行反向缩放,将其恢复到原始单位。

嗨,Jason,

是否可以为数据集中使用的每一列获取预测输出?例如,数据集由

12 1 22 45

2 34 55 8 组成。我能否让它为数据集中每一列输出一个数字?

是的,您可以调用 model.predict()。

但如何为数据集中多于一列进行预测?我的数据集有 6 列,我的输出总是只有 5 列。这让我认为它只是预测了一个列而不是全部 6 列。我能否通过将输出层设置为更多神经元来完成此操作?

您可以通过输出层中的神经元数量来配置模型以预测向量。

您可以通过编码器-解码器模型将模型输出一次一个列。

我在博客上有这两者的示例。

这正是我想要的。我在博客上找到了您的示例。非常感谢您 Jason。

很高兴听到这个消息。

嗨,Jason,

感谢您的教程!我不是程序员,事实上,我一生中从未写过一行代码。但我发现您的教程非常有帮助。

最近我遇到了一个回归问题,并尝试使用深度学习来解决它。所以我按照这篇文章一步一步地让 Keras 运行起来并得到结果。问题是我不知道如何调整和优化神经网络。我得到的结果远不能令人满意。我是否需要逐一调整模型的参数并观察结果,还是有更快捷的方法来优化神经网络?

另外,我看到这里有一个迷你课程,我尝试注册但没有收到邮件。也许是因为我来自中国或其他原因,我不知道。有没有什么速成班可以让我参加?因为我什么都不知道 Python……

干得好!

这篇帖子将向您展示如何调整网络。

https://machinelearning.org.cn/improve-deep-learning-performance/

您可以在这里访问迷你课程。

https://machinelearning.org.cn/applied-deep-learning-in-python-mini-course/

感谢您的回复。但我还有另一个问题。涉及‘estimator’的行是用于训练模型的,对吧?如何保存模型并用于预测?

请看这篇文章

https://machinelearning.org.cn/save-load-keras-deep-learning-models/

非常感谢!我学到了很多。在这个例子中,我可以使用 pipeline.fit(X,Y) 来训练模型,并使用 pipeline.predict(X) 进行预测,对吗?我认为教程中的‘pipeline’包括了标准化过程。所以当我使用 pipeline.predict(X) 时,我只需要输入原始数据就可以得到预测,而预测将是反标准化后的结果。我理解正确吗?

我相信是的。

您好,我需要询问关于这行 X = dataset[:,0:13],从数据集中可以看出它有 14 列(0 到 13),最后一列是标签列,那么这行代码应该是 X = dataset [:,0:12]。我说的对吗?

不。您可以在这里了解更多关于数组切片的信息。

https://machinelearning.org.cn/index-slice-reshape-numpy-arrays-machine-learning-python/

嗨,Jason,

我正在尝试将本教程中的代码应用于我的时间序列预测。但是从一开始,当我尝试将数据分割为 X 和 Y 时,我就会收到错误“TypeError: unhashable type: ‘slice’”。不幸的是,我找不到它的来源。

你能帮我吗?

提前感谢!

runfile(‘D:/LOCAL_DROPBOX/MasterArbeit_Sammlung_V01/Python/MasterArbeit/ARIMA/Test/BaselineRegressionKNN.py’, wdir=’D:/LOCAL_DROPBOX/MasterArbeit_Sammlung_V01/Python/MasterArbeit/ARIMA/Test’)

[[‘3,6’ ‘20,3’ ‘0’ …, 173 1136 0]

[‘11,4’ ‘18,8’ ‘15,2’ …, 105 1676 0]

[‘8,9’ ‘15,3’ ‘1,4’ …, 372 733 0]

……,

[‘-2,3’ ‘4,5’ ‘0’ …, 0 0 0]

[‘0,2’ ‘7,9’ ‘0’ …, 0 0 0]

[‘-3,5’ ‘4,4’ ‘0’ …, 0 0 0]]

回溯(最近一次调用)

File “”, line 1, in

runfile(‘D:/LOCAL_DROPBOX/MasterArbeit_Sammlung_V01/Python/MasterArbeit/ARIMA/Test/BaselineRegressionKNN.py’, wdir=’D:/LOCAL_DROPBOX/MasterArbeit_Sammlung_V01/Python/MasterArbeit/ARIMA/Test’)

File “C:\Users\Tanya\Anaconda3\lib\site-packages\spyder\utils\site\sitecustomize.py”, line 710, in runfile

execfile(filename, namespace)

File “C:\Users\Tanya\Anaconda3\lib\site-packages\spyder\utils\site\sitecustomize.py”, line 101, in execfile

exec(compile(f.read(), filename, 'exec'), namespace)

File “D:/LOCAL_DROPBOX/MasterArbeit_Sammlung_V01/Python/MasterArbeit/ARIMA/Test/BaselineRegressionKNN.py”, line 25, in

X = dataset[:,0:8]

File “C:\Users\Tanya\Anaconda3\lib\site-packages\pandas\core\frame.py”, line 2139, in __getitem__

return self._getitem_column(key)

File “C:\Users\Tanya\Anaconda3\lib\site-packages\pandas\core\frame.py”, line 2146, in _getitem_column

return self._get_item_cache(key)

File “C:\Users\Tanya\Anaconda3\lib\site-packages\pandas\core\generic.py”, line 1840, in _get_item_cache

res = cache.get(item)

TypeError: unhashable type: ‘slice’

您可以在这里了解更多关于数组切片的信息。

https://machinelearning.org.cn/index-slice-reshape-numpy-arrays-machine-learning-python/

你好,

关于“本节的进一步扩展将是类似地对输出变量应用重缩放,例如将其归一化到 0-1 的范围”。

我不知道如何让 StandardScaler 对象也对输出变量 Y 应用变换,而不是只对 X 应用。我做了以下操作。

results = cross_val_score(pipeline, preprocessing.scale(X), preprocessing.scale(Y), cv=kfold)

但是,这样预处理步骤是在 kfold 交叉验证之前完成的,而不是在您的先前示例中那样在每个折叠执行。

是的,数据准备必须在交叉验证之前进行。

我们如何绘制预期值与预测值之间的关系?

我推荐使用 matplotlib。

还有一个问题,如何将 k-fold 交叉验证与 CNN 模型一起使用?

与任何模型一样。您具体遇到什么问题?

我正在使用CNN来处理回归问题,并将数据分割为训练集、验证集和测试集,但我遇到了过拟合问题。所以,我正在考虑使用交叉验证,但我不知道如何操作。

我在这里展示了如何评估深度学习模型。

https://machinelearning.org.cn/evaluate-skill-deep-learning-models/

嗨,Jason

我在谷歌上搜索一些教程时,如果出现您的帖子,我总是先查看您的博客。

非常感谢。

我希望它们能帮到您。

嗨,Jason

输出层的激活函数是什么?您没有写。

谢谢。

线性,这是默认的。

你好 Jason,

我使用了您的代码,但得到了不同的结果。

结果:-114.64 (82.76) MSE

标准化:-29.57 (27.85) MSE

更大:-23.46 (27.29) MSE

更宽:-22.91 (29.25) MSE

为什么它们是负数?

干得不错。负数结果是由sklearn反转损失函数引起的。这是一个相对较新的功能。

这很令人困惑。结果差异很大!

如何以百分比形式解释这个错误?有办法吗?

我学习了Ng在deeplearning_dot_ai的课程,但他只介绍了分类问题。

如何理解回归问题中的误差好坏?对于向量回归(输出是向量)问题,与您的示例会有区别吗?

谢谢你。

是的,将模型的性能与基线模型(如零规则算法)进行比较。

改进是相对的,不是绝对的。

嗨,Jason,

在使用管道和k-fold cv时,如何获得用于绘图的预测y值?另外,假设有一个单独的X_test,如何从中预测y_hat?所以,我设想一个场景,您有一个训练集和一个单独的测试集(就像在Kaggle竞赛中一样)。您在训练集上构建管道和k-fold cv,并在测试集上进行预测。但是,您的训练集作为管道的一部分进行了缩放。如何将相同的缩放应用于X_test?

我们不使用CV进行预测,它只是一种估计模型技能的方法。在此了解更多。

https://machinelearning.org.cn/train-final-machine-learning-model/

嗨,Jason;

如何设计一个返回多个输出(例如4个)而不是单个输出的Keras模型用于回归问题?

您可以在输出层中使用多个单元来输出一个向量。

您的意思是,我应该通过编辑编译前的最后一行来更改模型设计:

model.add(Dense(1, kernel_initializer=’normal’))

推广到

model.add(Dense(4, kernel_initializer=’normal’))

?

是的。

我得到了与WonderingStranger类似的结果。我是深度学习新手。所以我不太明白您的回复是什么意思。如果能详细解释一下,我将不胜感激。

你好,我该如何保存权重?我查看了您关于保存的链接,但您在那个链接中没有使用管道方法。

我尝试了kfold.save_weigths,但出现了一个错误。

您可能需要保留对模型的引用(某种方式?)并使用Keras API来保存权重。

嗨,Jason,

有没有办法将标准化后的数据输入到lstm模型 (create_model) 中?原因是lstm的输入形状只允许3D。然而,标准化只能接受2D形状。希望得到您的回复……谢谢。

在重塑之前进行标准化。

谢谢Jason的回复……我很感激。

嗨,Jason,

我在这方面还是新手。

感谢您一步一步的解释。

我想询问housing.csv的详细信息以及如何进行预测。

例如,我们想预测数据集中最后一个属性的值。

通过使用estimator.predict。

谢谢你

您可以使用

yhat = model.predict(X)

这有帮助吗?

嗨,Jason,

感谢您精彩的教程。您的网站让我看起来更年轻了:)

有没有办法打印/导出实际房屋价格和预测房屋价格。

另外,您能否为R2提供一个可视化建议?

谢谢!

你可以按如下方式进行预测

yhat = model.predict(X)

X = dataset[:,0:11]

Y = dataset[:,11]

回溯(最近一次调用)

File “”, line 5, in

Y = dataset[:,11]

IndexError: index 11 is out of bounds for axis 1 with size 1

请帮助解决此问题。

感谢Jason发表这篇精彩的帖子。

请确保您复制了示例中的所有代码。

嗨,Jason!

感谢这篇很棒的教程。

我做了上面所有的例子,然后我尝试用