序列分类是一个预测建模问题,其中您有一些跨空间或时间的输入序列,任务是预测序列的类别。

这个问题很困难,因为序列的长度可能不同,可能包含非常大的输入符号词汇表,并且可能要求模型学习输入序列中符号之间的长期上下文或依赖关系。

在这篇文章中,您将了解如何使用 Keras 深度学习库在 Python 中为序列分类问题开发 LSTM 循环神经网络模型。

阅读本文后,你将了解:

- 如何为序列分类问题开发 LSTM 模型

- 如何通过使用 dropout 减少 LSTM 模型中的过拟合

- 如何将 LSTM 模型与擅长学习空间关系的卷积神经网络结合起来

通过我的新书《自然语言处理深度学习》启动您的项目,包括分步教程和所有示例的 Python 源代码文件。

让我们开始吧。

- 2016 年 7 月:首次发布

- 2016 年 10 月更新:更新了 Keras 1.1.0 和 TensorFlow 0.10.0 的示例

- 2017 年 3 月更新:更新了 Keras 2.0.2、TensorFlow 1.0.1 和 Theano 0.9.0 的示例

- 2018 年 5 月更新:更新了代码以使用最新的 Keras API,感谢 Jeremy Rutman

- 2022 年 7 月更新:更新了 TensorFlow 2.x 的代码,并添加了一个使用双向 LSTM 的示例

使用 Python 和 Keras 中的 LSTM 循环神经网络进行序列分类

图片由 photophilde 提供,保留部分权利。

问题描述

您将在本教程中用于演示序列学习的问题是 IMDB 电影评论情感分类问题。每个电影评论都是一个可变单词序列,必须对每个电影评论的情感进行分类。

大型电影评论数据集(通常称为 IMDB 数据集)包含 25,000 条高度两极分化的电影评论(好或坏)用于训练,以及相同数量的评论用于测试。问题是确定给定电影评论是积极情感还是消极情感。

该数据由 斯坦福大学研究人员收集,并用于 2011 年的一篇论文中,其中数据以 50/50 的比例用于训练和测试。准确率达到 88.89%。

Keras 提供了对 IMDB 数据集的内置访问。imdb.load_data() 函数允许您以适合在神经网络和深度学习模型中使用的格式加载数据集。

单词已被整数替换,这些整数表示数据集中每个单词的有序频率。因此,每个评论中的句子都由一个整数序列组成。

词嵌入

您将把每个电影评论映射到一个实数向量域,这是一种处理文本时流行的技术——称为词嵌入。这是一种将单词编码为高维空间中的实值向量的技术,其中单词在含义上的相似性转化为向量空间中的接近性。

Keras 提供了一种方便的方法,通过嵌入层将单词的正整数表示转换为词嵌入。

您将把每个单词映射到 32 长度的实值向量。您还将把我们感兴趣的建模单词总数限制在最常见的 5000 个单词之内,其余的归零。最后,每个评论中的序列长度(单词数)各不相同,因此您将把每个评论限制为 500 个单词,截断长评论并用零值填充短评论。

现在您已经定义了问题以及如何准备和建模数据,您已准备好开发一个 LSTM 模型来分类电影评论的情感。

需要 LSTM 帮助进行序列预测吗?

参加我的免费7天电子邮件课程,了解6种不同的LSTM架构(附代码)。

点击注册,同时获得该课程的免费PDF电子书版本。

用于序列分类的简单 LSTM

您可以为 IMDB 问题快速开发一个小型 LSTM,并获得良好的准确性。

让我们首先导入此模型所需的类和函数,并将随机数生成器初始化为常数值,以确保您可以轻松重现结果。

|

1 2 3 4 5 6 7 8 9 |

import tensorflow as tf from tensorflow.keras.datasets import imdb from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from tensorflow.keras.layers import LSTM from tensorflow.keras.layers import Embedding from tensorflow.keras.preprocessing import sequence # 设置随机种子以保证结果可复现 tf.random.set_seed(7) |

您需要加载 IMDB 数据集。您将数据集限制为前 5,000 个单词。您还将数据集分为训练集 (50%) 和测试集 (50%)。

|

1 2 3 |

# 加载数据集,但只保留前 n 个单词,其余归零 top_words = 5000 (X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=top_words) |

接下来,您需要截断并填充输入序列,使它们都具有相同的长度以进行建模。模型将学习零值不携带任何信息。序列在内容方面长度不同,但需要等长向量才能在 Keras 中执行计算。

|

1 2 3 4 |

# 截断并填充输入序列 max_review_length = 500 X_train = sequence.pad_sequences(X_train, maxlen=max_review_length) X_test = sequence.pad_sequences(X_test, maxlen=max_review_length) |

您现在可以定义、编译和拟合您的 LSTM 模型。

第一层是嵌入层,它使用 32 长度的向量来表示每个单词。下一层是具有 100 个记忆单元(智能神经元)的 LSTM 层。最后,因为这是一个分类问题,您将使用一个具有单个神经元和 sigmoid 激活函数的全连接输出层,用于问题中的两个类别(好和坏)进行 0 或 1 预测。

由于这是一个二元分类问题,因此使用对数损失作为损失函数(Keras 中的 binary_crossentropy)。使用高效的 ADAM 优化算法。模型只拟合了两个 epoch,因为它很快就会过度拟合问题。使用 64 条评论的大批量大小来分散权重更新。

|

1 2 3 4 5 6 7 8 9 |

# 创建模型 embedding_vecor_length = 32 model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(LSTM(100)) model.add(Dense(1, activation='sigmoid')) model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy']) print(model.summary()) model.fit(X_train, y_train, validation_data=(X_test, y_test), epochs=3, batch_size=64) |

一旦拟合,您可以评估模型在未见过评论上的性能。

|

1 2 3 |

# 模型的最终评估 scores = model.evaluate(X_test, y_test, verbose=0) print("Accuracy: %.2f%%" % (scores[1]*100)) |

为了完整性,这里是 IMDB 数据集上此 LSTM 网络的完整代码列表。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 |

# IMDB 数据集中的序列分类 LSTM import tensorflow as tf from tensorflow.keras.datasets import imdb from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from tensorflow.keras.layers import LSTM from tensorflow.keras.layers import Embedding from tensorflow.keras.preprocessing import sequence # 设置随机种子以保证结果可复现 tf.random.set_seed(7) # 加载数据集,但只保留前 n 个单词,其余归零 top_words = 5000 (X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=top_words) # 截断并填充输入序列 max_review_length = 500 X_train = sequence.pad_sequences(X_train, maxlen=max_review_length) X_test = sequence.pad_sequences(X_test, maxlen=max_review_length) # 创建模型 embedding_vecor_length = 32 model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(LSTM(100)) model.add(Dense(1, activation='sigmoid')) model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy']) print(model.summary()) model.fit(X_train, y_train, epochs=3, batch_size=64) # 模型的最终评估 scores = model.evaluate(X_test, y_test, verbose=0) print("Accuracy: %.2f%%" % (scores[1]*100)) |

注意:由于算法或评估过程的随机性,或数值精度的差异,您的结果可能会有所不同。考虑多次运行示例并比较平均结果。

运行此示例将产生以下输出。

|

1 2 3 4 5 6 7 |

Epoch 1/3 391/391 [==============================] - 124s 316ms/step - loss: 0.4525 - accuracy: 0.7794 Epoch 2/3 391/391 [==============================] - 124s 318ms/step - loss: 0.3117 - accuracy: 0.8706 Epoch 3/3 391/391 [==============================] - 126s 323ms/step - loss: 0.2526 - accuracy: 0.9003 准确率:86.83% |

您可以看到,这个经过少量调整的简单 LSTM 在 IMDB 问题上取得了接近最先进的结果。重要的是,这是一个模板,您可以用来将 LSTM 网络应用于您自己的序列分类问题。

现在,让我们看看这个简单模型的一些扩展,您可能也希望将它们应用于您自己的问题。

带有 Dropout 的 LSTM 用于序列分类

像 LSTM 这样的循环神经网络通常存在过拟合问题。

Dropout 可以使用 Dropout Keras 层在层之间应用。您可以通过在嵌入层和 LSTM 层之间以及 LSTM 和密集输出层之间添加新的 Dropout 层来轻松实现这一点。例如:

|

1 2 3 4 5 6 |

model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(Dropout(0.2)) model.add(LSTM(100)) model.add(Dropout(0.2)) model.add(Dense(1, activation='sigmoid')) |

上面带有 Dropout 层的完整代码示例如下:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 |

# 带有 Dropout 的 LSTM 用于 IMDB 数据集中的序列分类 import tensorflow as tf from tensorflow.keras.datasets import imdb from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from tensorflow.keras.layers import LSTM from tensorflow.keras.layers import Dropout from tensorflow.keras.layers import Embedding from tensorflow.keras.preprocessing import sequence # 设置随机种子以保证结果可复现 tf.random.set_seed(7) # 加载数据集,但只保留前 n 个单词,其余归零 top_words = 5000 (X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=top_words) # 截断并填充输入序列 max_review_length = 500 X_train = sequence.pad_sequences(X_train, maxlen=max_review_length) X_test = sequence.pad_sequences(X_test, maxlen=max_review_length) # 创建模型 embedding_vecor_length = 32 model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(Dropout(0.2)) model.add(LSTM(100)) model.add(Dropout(0.2)) model.add(Dense(1, activation='sigmoid')) model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy']) print(model.summary()) model.fit(X_train, y_train, epochs=3, batch_size=64) # 模型的最终评估 scores = model.evaluate(X_test, y_test, verbose=0) print("Accuracy: %.2f%%" % (scores[1]*100)) |

注意:由于算法或评估过程的随机性,或数值精度的差异,您的结果可能会有所不同。考虑多次运行示例并比较平均结果。

运行此示例会提供以下输出。

|

1 2 3 4 5 6 7 |

Epoch 1/3 391/391 [==============================] - 117s 297ms/step - loss: 0.4721 - accuracy: 0.7664 Epoch 2/3 391/391 [==============================] - 125s 319ms/step - loss: 0.2840 - accuracy: 0.8864 Epoch 3/3 391/391 [==============================] - 135s 346ms/step - loss: 0.3022 - accuracy: 0.8772 准确率:85.66% |

您可以看到 dropout 对训练产生了预期的影响,收敛趋势略慢,并且在这种情况下,最终准确率较低。模型可能需要再训练几个 epoch,并且可能会获得更高的技能(尝试一下看看)。

另外,可以将 dropout 精确地单独应用于内存单元的输入和循环连接。

Keras 通过 LSTM 层的参数提供了此功能,其中 **dropout** 用于配置输入 dropout,**recurrent_dropout** 用于配置循环 dropout。例如,您可以修改第一个示例以如下方式将 dropout 添加到输入和循环连接:

|

1 2 3 4 |

model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(LSTM(100, dropout=0.2, recurrent_dropout=0.2)) model.add(Dense(1, activation='sigmoid')) |

下面列出了带有更精确的 LSTM dropout 的完整代码,以供参考。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 |

# 带有 dropout 的 LSTM 用于 IMDB 数据集中的序列分类 import tensorflow as tf from tensorflow.keras.datasets import imdb from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from tensorflow.keras.layers import LSTM from tensorflow.keras.layers import Embedding from tensorflow.keras.preprocessing import sequence # 设置随机种子以保证结果可复现 tf.random.set_seed(7) # 加载数据集,但只保留前 n 个单词,其余归零 top_words = 5000 (X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=top_words) # 截断并填充输入序列 max_review_length = 500 X_train = sequence.pad_sequences(X_train, maxlen=max_review_length) X_test = sequence.pad_sequences(X_test, maxlen=max_review_length) # 创建模型 embedding_vecor_length = 32 model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(LSTM(100, dropout=0.2, recurrent_dropout=0.2)) model.add(Dense(1, activation='sigmoid')) model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy']) print(model.summary()) model.fit(X_train, y_train, epochs=3, batch_size=64) # 模型的最终评估 scores = model.evaluate(X_test, y_test, verbose=0) print("Accuracy: %.2f%%" % (scores[1]*100)) |

注意:由于算法或评估过程的随机性,或数值精度的差异,您的结果可能会有所不同。考虑多次运行示例并比较平均结果。

运行此示例会提供以下输出。

|

1 2 3 4 5 6 7 |

Epoch 1/3 391/391 [==============================] - 220s 560ms/step - loss: 0.4605 - accuracy: 0.7784 Epoch 2/3 391/391 [==============================] - 219s 560ms/step - loss: 0.3158 - accuracy: 0.8773 Epoch 3/3 391/391 [==============================] - 219s 559ms/step - loss: 0.2734 - accuracy: 0.8930 准确率:86.78% |

您可以看到,LSTM 特有的 dropout 对网络收敛的影响比层级 dropout 更显著。与上面一样,epoch 数量保持不变,并且可以增加以查看模型技能是否能进一步提升。

Dropout 是对抗 LSTM 模型过拟合的强大技术,两种方法都值得尝试。不过,您可能会通过 Keras 中提供的门控特定 dropout 获得更好的结果。

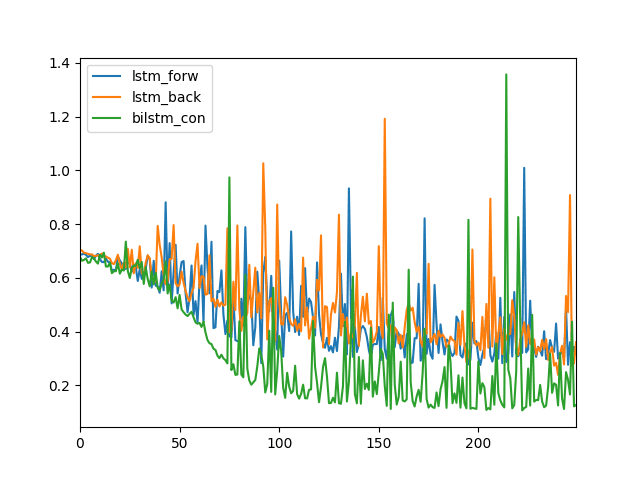

用于序列分类的双向 LSTM

有时,反向使用序列效果更好。在这种情况下,您只需在使用 Python 语法 `x[::-1]` 反转向量 `x`,然后再用它来训练您的 LSTM 网络。

有时,正向或反向顺序都不能完美地工作,但将它们结合起来会产生更好的结果。在这种情况下,您将需要一个**双向 LSTM 网络**。

双向 LSTM 网络只是两个独立的 LSTM 网络;一个使用正向序列输入,另一个使用反向序列输入。然后将两个 LSTM 网络的输出连接起来,然后馈送到网络的后续层。在 Keras 中,您可以使用 `Bidirectional()` 函数克隆一个 LSTM 层,用于正向-反向输入并连接它们的输出。例如:

|

1 2 3 4 |

model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(Bidirectional(LSTM(100, dropout=0.2, recurrent_dropout=0.2))) model.add(Dense(1, activation='sigmoid')) |

由于您创建了不止一个,而是两个各有 100 个单元的 LSTM,因此该网络的训练时间将是原来的两倍。根据问题,这种额外的成本可能是合理的。

下面列出了在最后一个示例中添加双向 LSTM 的完整代码,以供参考。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 |

# 带有 dropout 的 LSTM 用于 IMDB 数据集中的序列分类 import tensorflow as tf from tensorflow.keras.datasets import imdb from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from tensorflow.keras.layers import LSTM from tensorflow.keras.layers import Bidirectional from tensorflow.keras.layers import Embedding from tensorflow.keras.preprocessing import sequence # 设置随机种子以保证结果可复现 tf.random.set_seed(7) # 加载数据集,但只保留前 n 个单词,其余归零 top_words = 5000 (X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=top_words) # 截断并填充输入序列 max_review_length = 500 X_train = sequence.pad_sequences(X_train, maxlen=max_review_length) X_test = sequence.pad_sequences(X_test, maxlen=max_review_length) # 创建模型 embedding_vecor_length = 32 model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(Bidirectional(LSTM(100, dropout=0.2, recurrent_dropout=0.2))) model.add(Dense(1, activation='sigmoid')) model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy']) print(model.summary()) model.fit(X_train, y_train, epochs=3, batch_size=64) # 模型的最终评估 scores = model.evaluate(X_test, y_test, verbose=0) print("Accuracy: %.2f%%" % (scores[1]*100)) |

注意:由于算法或评估过程的随机性,或数值精度的差异,您的结果可能会有所不同。考虑多次运行示例并比较平均结果。

运行此示例会提供以下输出。

|

1 2 3 4 5 6 7 |

Epoch 1/3 391/391 [==============================] - 405s 1s/step - loss: 0.4960 - accuracy: 0.7532 Epoch 2/3 391/391 [==============================] - 439s 1s/step - loss: 0.3075 - accuracy: 0.8744 Epoch 3/3 391/391 [==============================] - 430s 1s/step - loss: 0.2551 - accuracy: 0.9014 准确率:87.69% |

似乎您只能获得轻微的改进,但训练时间显著延长。

LSTM 和卷积神经网络用于序列分类

卷积神经网络擅长学习输入数据的空间结构。

IMDB 评论数据在评论的单词序列中确实具有一维空间结构,CNN 可能能够识别出好坏情感的不变特征。然后,这些学习到的空间特征可能被 LSTM 层作为序列学习。

您可以轻松地在嵌入层之后添加一维 CNN 和最大池化层,然后将合并的特征馈送给 LSTM。您可以使用一组相对较小的 32 个特征和较小的滤波器长度 3。池化层可以使用标准长度 2 将特征图大小减半。

例如,您可以按如下方式创建模型:

|

1 2 3 4 5 6 |

model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(Conv1D(filters=32, kernel_size=3, padding='same', activation='relu')) model.add(MaxPooling1D(pool_size=2)) model.add(LSTM(100)) model.add(Dense(1, activation='sigmoid')) |

以下是包含 CNN 和 LSTM 层的完整代码列表,以供参考。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 |

# LSTM 和 CNN 用于 IMDB 数据集中的序列分类 import tensorflow as tf from tensorflow.keras.datasets import imdb from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from tensorflow.keras.layers import LSTM from tensorflow.keras.layers import Conv1D from tensorflow.keras.layers import MaxPooling1D from tensorflow.keras.layers import Embedding from tensorflow.keras.preprocessing import sequence # 设置随机种子以保证结果可复现 tf.random.set_seed(7) # 加载数据集,但只保留前 n 个单词,其余归零 top_words = 5000 (X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=top_words) # 截断并填充输入序列 max_review_length = 500 X_train = sequence.pad_sequences(X_train, maxlen=max_review_length) X_test = sequence.pad_sequences(X_test, maxlen=max_review_length) # 创建模型 embedding_vecor_length = 32 model = Sequential() model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length)) model.add(Conv1D(filters=32, kernel_size=3, padding='same', activation='relu')) model.add(MaxPooling1D(pool_size=2)) model.add(LSTM(100)) model.add(Dense(1, activation='sigmoid')) model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy']) print(model.summary()) model.fit(X_train, y_train, epochs=3, batch_size=64) # 模型的最终评估 scores = model.evaluate(X_test, y_test, verbose=0) print("Accuracy: %.2f%%" % (scores[1]*100)) |

注意:由于算法或评估过程的随机性,或数值精度的差异,您的结果可能会有所不同。考虑多次运行示例并比较平均结果。

运行此示例会提供以下输出。

|

1 2 3 4 5 6 7 |

Epoch 1/3 391/391 [==============================] - 65s 163ms/step - loss: 0.4213 - accuracy: 0.7950 Epoch 2/3 391/391 [==============================] - 66s 168ms/step - loss: 0.2490 - accuracy: 0.9026 Epoch 3/3 391/391 [==============================] - 73s 188ms/step - loss: 0.1979 - accuracy: 0.9261 准确率:88.45% |

您可以看到,您取得了比第一个示例稍好的结果,尽管权重更少,训练时间更快。

您可能会期望,如果这个示例进一步扩展以使用 dropout,甚至可以取得更好的结果。

资源

如果您有兴趣深入研究序列预测或此特定示例,以下是一些资源。

- 应用于 IMDB 数据集的 LSTMs 的 Theano 教程

- Keras 代码示例,用于在 IMDB 数据集上使用 LSTM 和 CNN。

- 带有循环神经网络的监督序列标注,Alex Graves 2012 年的书(和 PDF 预印本)。

总结

在这篇文章中,您学习了如何开发用于序列分类预测建模问题的 LSTM 网络模型。

具体来说,你学到了:

- 如何为 IMDB 电影评论情感分类问题开发一个简单的单层 LSTM 模型

- 如何使用层级和 LSTM 特定的 dropout 扩展您的 LSTM 模型以减少过拟合

- 如何将卷积神经网络的空间结构学习特性与 LSTM 的序列学习结合起来

您对使用 LSTM 进行序列分类或本文有任何疑问吗?请在评论中提出您的问题,我将尽力回答。

太棒了!

谢谢 Atlant。

您是如何得到 16,750 的?25,000 / 64 个批次是 390。

谢谢!

我对 LSTM 的输入/输出维度感到困惑,特别是在 keras 库中。为什么 keras 返回 2D 输出而其输入是 3D?我知道它可以使用“return_sequence = True”返回 3D 输出,但如果 return_sequence = False,它如何处理 3D 并生成 2D 输出?例如,如果输入数据形状为 (32, 16, 20),32 批量大小,16 时间步,20 特征,输出形状为 (32, 100),32 批量大小,100 隐藏状态;keras 如何处理 3d 输入并返回 2d 输出。此外,如果输入和隐藏状态没有精确的维度,如何连接它们?

嗨 Hajar…您可能会发现以下内容有帮助

https://machinelearning.org.cn/reshape-input-data-long-short-term-memory-networks-keras/

嗨,我有一个问题,如果有人能回答的话。我有表格数据。多个列(即 4 列)有文本数据。就像这里一样。https://github.com/IBM/KPA_2021_shared_task。我将如何将这些表格数据转换为矩阵并对其应用 lstm 模型。

LSTMs 不适用于表格数据,它们需要序列数据。

这可能有帮助

https://machinelearning.org.cn/faq/single-faq/what-is-the-difference-between-samples-timesteps-and-features-for-lstm-input

嗨,Jason,

祝贺兄弟,持续提供出色且易于适应/理解的课程。我只是好奇想了解无监督和强化神经网络,您有任何教程吗?

此致,

Sahil

谢谢 Sahil。

抱歉,目前还没有关于无监督学习或强化学习与神经网络的教程。不过很快就会有。

嗨,您在这里发布的东西很棒,谢谢。

这种网络架构是否适用于根据股票价格的时间序列数据预测股票的盈利能力。

例如,使用每日股票价格和交易量的 5 分钟间隔数据(从上午 9:30 到下午 1 点),并与当天剩余交易日股票价格上涨超过 0.5% 的“是”或“否”配对?

每个交易日是一个样本,整个数据集例如是过去 1000 个交易日。

如果这种网络架构不适用,您会建议测试其他哪些架构?

再次感谢这个超级资源。

谢谢 Søren。

当然,值得一试,但我不是股票市场专家。

那么,本教程的最终结果是一个模型。您能给我一个示例,说明如何使用此模型预测新的评论,特别是使用训练数据中不存在的新词汇吗?非常感谢。

Naufal,我没有示例,但新示例需要使用相同的整数对单词进行编码,并将这些整数嵌入到相同的单词映射中。

感谢 Jason 的精彩文章。

为了预测,我做了以下事情,如果我做错了请纠正。你说要嵌入……我没明白。如何做到这一点。

text = numpy.array(['this is excellent sentence'])

#print(text.shape)

tk = keras.preprocessing.text.Tokenizer( nb_words=2000, lower=True,split=" ")

tk.fit_on_texts(text)

prediction = model.predict(numpy.array(tk.texts_to_sequences(text)))

print(prediction)

感谢 Jason 的精彩文章。

为了预测,我做了以下事情,如果我做错了请纠正。你说要嵌入……我没明白。如何做到这一点。

text = numpy.array(['this is excellent sentence'])

#print(text.shape)

tk = keras.preprocessing.text.Tokenizer( nb_words=2000, lower=True,split=" ")

tk.fit_on_texts(text)

prediction = model.predict(sequence.pad_sequences(tk.texts_to_sequences(text),maxlen=max_review_length))

print(prediction)

您可以使用以下代码来预测新评论的情绪。

但是,它会简单地跳过词汇表之外的单词。

另外,您可以在训练前尝试增加“top_words”值,以便覆盖更多单词。

感谢分享!

Embed 指的是词嵌入层

https://keras.org.cn/layers/embeddings/

def conv_to_proper_format(sentence)

>>sentence=text.text_to_word_sequence(sentence,filters='!"#$%&()*+,-./:;?@[\\]^_`{|}~\t\n',lower=True,split=" ")

>>sentence=numpy.array([word_index[word] if word in word_index else 0 for word in sentence])#编码成整数序列

>>sentence[sentence>5000]=2

>>L=500-len(sentence)

>>sentence=numpy.pad(sentence, (L,0), 'constant')

>>sentence=sentence.reshape(1,-1)

>>return sentence

使用此函数将您的评论转换为正确的格式,然后 model.predict(review1) 将给出答案。

你好 Jason!很棒的教程!

当我尝试本教程时,我从 imdb.load_data 收到错误消息

TypeError: load_data() 接收到意外的关键字参数 'test_split'

我尝试复制粘贴整个源代码,但这一行仍然有相同的错误。

您能想到有什么根本原因导致它无法为我执行吗?

很抱歉听到这个消息,Joey。这看起来像是 Keras v1.0.7 的一个变化。

如果我使用 1.0.7 版本运行,也会遇到相同的错误。我看到 API 文档仍然在此处引用 test_split 参数:https://keras.org.cn/datasets/#imdb-movie-reviews-sentiment-classification

我看到该参数已从函数中删除

https://github.com/fchollet/keras/blob/master/keras/datasets/imdb.py

选项 1)您可以从函数中删除该参数以使用默认的测试 50/50 分割。

选项 2)您可以将 Keras 降级到 1.0.6 版本

请记住,您可以在命令行上检查您的 Keras 版本,方法是

我将考虑更新示例以使其与最新 Keras 兼容。

我成功了!非常感谢 Jason 的帮助!

很高兴听到这个消息,Joey。

我已将帖子中的示例更新为与 Keras 1.1.0 和 TensorFlow 0.10.0 匹配。

你好,Jason。

一个快速问题

根据我的理解,前面填充零就像标记“START”。否则就像标记“END”。我应该如何决定是“前”填充还是“后”填充?这有关系吗?

谢谢。

Chong,我想我不太明白这个问题,抱歉。

考虑在您的问题上尝试两种填充方法,看看哪种效果最好。

你好,Jason。

谢谢你的回复。

在“带有 Dropout 的 LSTM 序列分类”一节中,我还有另一个快速问题。

model.add(Embedding(top_words, embedding_vector_length, input_length=max_review_length, dropout=0.2))

model.add(Dropout(0.2))

…

这里我看到两个 dropout 层。第二个很容易理解:对于每个时间步,它只是随机停用输出嵌入向量中 20% 的数字。

第一个让我困惑:它对输入进行 dropout 吗?对于每个时间步,嵌入层的输入应该只是 top_words 的一个索引。换句话说,输入是一个单一数字。我们如何对其进行 dropout?(或者您的意思是丢弃 20% 时间步的输入索引?)

很好的问题,我相信它会从嵌入层到隐藏层的输入节点中删除权重。

您可以在此处了解有关 dropout 的更多信息

https://machinelearning.org.cn/dropout-regularization-deep-learning-models-keras/

Embedding 层中应用的 dropout 能否理解为随机删除句子中的某个词,从而强制分类不依赖于任何词?

我认为没有理由不能——一时兴起。

你为什么说输入是一个数字?它应该是一个转换为词嵌入的句子。例如,如果嵌入向量的长度是 50,句子最多有 500 个单词,这将是一个 (500,50) 矩阵。我认为,它所做的是从总共 50 个嵌入向量中删除一些特征。

你好,

这可能是一个迟来的回复,但我希望分享我对前向填充的思考。前向填充而不是后向填充的原因是,对于像 LSTM 这样的循环神经网络,根据链式法则,较早出现的词获得的更新较少,而最近出现的词对权重更新的影响更大。在序列开头填充零将使后面的内容更好地学习。

李

感谢分享!

嗨 Jason

感谢您对这些复杂主题提供如此简单的解释。

在本教程中,Embedding 层用作输入层,因为数据是单词序列。

我正在解决一个问题,其中我有一个图像序列作为示例,并且每个示例都分配了一个特定的标签。序列中的图像数量因示例而异。我有以下问题

1) 我可以使用 LSTM 层作为输入层吗?

2) 如果输入层是 LSTM 层,是否仍然需要指定 max_len(这是一个约束,说明一个示例可以拥有的最大图像数量)

提前感谢。

有趣的问题,Harish。

我建议您考虑多种不同的方式来表示这个问题,然后尝试几种看看哪种有效。

我的直觉是,在前端对图像数据使用 CNN,然后中间使用 LSTM,后端使用一些密集层来将表示转换为预测。

希望这能有所帮助。

非常感谢 Jason。

您能告诉我如何在不填充的情况下处理此问题中不同长度的序列吗?如果需要填充,如何选择填充图像序列的最大长度。

可变长度的序列需要填充。

根据您可用于评估的所有数据选择最大长度。

感谢您的时间和建议,Jason。

您能解释一下掩码输入层是什么意思以及如何在 Keras 中使用它来处理填充吗?

嗨 Harish,

我正在处理类似的问题,想知道您是否继续处理这个问题?什么奏效了,什么没有奏效?

提前感谢

嗨,Jason,

感谢本教程。太有帮助了!我想将它应用到我自己的问题中。我正在处理一个问题,其中我有一个声学样本序列。序列长度不同,我了解每个序列中产生信号的个体/实体的身份。由于这些序列具有时间元素(每个序列都是时间序列,属于同一序列的序列也与时间相关),我认为 LSTM 是可行的方法。

根据我的理解,本教程中的 Embedding 层用于为数据集添加额外的维度,因为 LSTM 层接收 3D 输入数据。

我的问题是,在我的问题中,将 LSTM 层用作第一层是否明智,因为 Embedding 不适用于我的非整数声学样本?我知道为了将 LSTM 用作我的第一层,我必须以有意义的方式重塑我的数据,以使其满足 LSTM 层的输入要求。我已经填充了我的序列,所以我的数据集目前是一个 2D 张量。然而,用零填充并不理想,因为一些原始声学样本值为零,表示零压级。所以我手动使用了不同的数字进行填充。

我计划在我的 Sequential 模型的末尾使用一组 LSTM 层和一个 Dense 层。

附:我是 Keras 新手。非常感谢您能提供的任何建议。

谢谢你

Gciniwe,我很高兴它有用。

很好的问题,很难回答。我建议您查阅一些关于基于音频的 LSTM 和 CNN 应用的文献,看看使用了哪些表示。我见过的示例(遗憾地)微不足道。

尝试将 LSTM 作为第一层,但也要尝试使用 CNN (1D) 然后 LSTM 以获得更多提取结构的机会。或许也可以尝试 Dense 然后 LSTM。我会在输出层使用一个或多个 Dense。

祝你好运,我非常期待听到你的成果。

嗨 Gciniwe

很高兴看到我也在处理类似的问题。我从事语音和图像处理。我有一个小疑问。请问您是如何选择填充值的?因为在图像中,我们也会有零,无法理解如何进行填充。

提前感谢

当我运行上面的代码时,我得到了以下错误

:MemoryError: 分配失败

导致错误的 Apply 节点:Alloc(TensorConstant{(1L, 1L, 1L) of 0.0}, TensorConstant{24}, Elemwise{Composite{((i0 * i1) // i2)}}[(0, 0)].0, TensorConstant{280})

拓扑排序索引:145

输入类型:[TensorType(float32, (True, True, True)), TensorType(int64, scalar), TensorType(int64, scalar), TensorType(int64, scalar)]

输入形状:[(1L, 1L, 1L), (), (), ()]

输入步幅:[(4L, 4L, 4L), (), (), ()]

输入值:[array([[[ 0.]]], dtype=float32), array(24L, dtype=int64), array(-450L, dtype=int64), array(280L, dtype=int64)]

输出客户端:[[IncSubtensor{Inc;:int64:}(Alloc.0, Subtensor{::int64}.0, Constant{24}), IncSubtensor{InplaceInc;int64::}(Alloc.0, IncSubtensor{Inc;:int64:}.0, Constant{0}), forall_inplace,cpu,grad_of_scan_fn}(TensorConstant{24}, Elemwise{tanh}.0, Subtensor{int64:int64:int64}.0, Alloc.0, Elemwise{Composite{(i0 – sqr(i1))}}.0, Subtensor{int64:int64:int64}.0, Subtensor{int64:int64:int64}.0,

有什么想法吗?我正在使用 theano 0.8.2 和 keras 1.0.8

Nick,很抱歉听到这个消息,我没有见过这个错误。

也许可以尝试 Theano 后端,看看是否有任何不同?

我遇到了同样的问题,我不知道如何解决它。

嗨,Jason,

我有一个问题。我可以使用 RNN LSTM 进行时间序列销售分析吗?我每天只有一年的销售额作为输入。所以总数据点约为 278 个,我想预测未来 6 个月。这么多的数据点是否足以使用 RNN 技术?您能否解释一下 LSTM 和 GRU 之间有什么区别,以及何时使用 LSTM 或 GRU?

Deepak 你好,我的建议是尝试在你的问题上使用 LSTM 看看。

您最好使用更简单的统计方法来预测 60 个月的销售数据。

杰森,这太棒了。谢谢!

我也很想看到一些无监督学习,了解它是如何工作的以及它的应用。

你好 Corne,

我倾向于不写关于无监督技术的教程(特征选择除外),因为我发现像聚类这样的方法在预测建模问题中并不实用。

感谢您撰写本教程。它非常有帮助。为什么 LSTM 不需要对其特征值进行归一化?

Jeff,很好的问题。

通常,当数据缩放到传递函数范围时,神经网络可以获得更好的性能。在这种情况下,我们在 LSTM 中使用 sigmoid 函数,因此我们发现通过将输入数据归一化到 0-1 范围可以获得更好的性能。

希望这能有所帮助。

嗨 Jason,感谢您的精彩教程!

我正在尝试对数据进行归一化,基本上将 X 中的每个元素除以最大值(在这种情况下为 5000),因为 X 在 [0, 5000] 范围内。我得到了更差的性能。有什么想法吗?谢谢!

不。尝试其他缩放方法。

嗨,Jason!您的教程非常有帮助。但我仍然对在 LSTM 单元中使用 dropout 有一个问题。dropout_W 和 dropout_U 的实际效果有什么区别?在大多数情况下,我应该将它们设置为相同的值吗?您能推荐一些与此主题相关的论文吗?非常感谢!

Lau,我建议你参考 API

https://keras.org.cn/layers/recurrent/#lstm

通常,我建议测试不同的值,看看哪个有效。在实践中,将它们设置为相同的值可能是一个很好的起点。

你好,

感谢这篇精彩的文章。我对数据编码有一个问题:“单词已被整数替换,这些整数表示数据集中每个单词的有序频率”。

“有序频率”到底是什么意思?例如,最常用的词最终被编码为 0 还是 4999?

很好的问题,Jeff。

我相信最常见的词是 1。

我认为 0 被保留用于填充或当我们想要截断低频词时。

感谢您非常有用的帖子。

我有一个问题。

在最后一个例子(CNN&LSTM)中,很明显我们获得了更快的训练时间,但是我们如何知道 CNN 适合这里作为 LSTM 的前置层呢?这里所谓的空间结构是什么意思?所以,如果我理解如何判断数据集 X 是否具有空间结构,那么这会是建议在基于序列的问题中在 LSTM 层之前使用 CNN 的合适线索吗?

谢谢,

Mazen

嗨 Mazen,

空间结构就是词的顺序。对于 CNN 来说,它们只是一串数字,但我们知道这个序列具有结构——词(用于表示词的数字)及其顺序很重要。

模型选择很困难。通常,您希望选择在性能和复杂性(易于理解、维护、再训练、投入生产使用)方面达到最佳平衡的模型。

是的,如果问题具有某种空间结构(图像、文本等),请尝试使用保留该结构的方法,例如卷积神经网络(CNN)。

嗨 Jason,很棒的帖子!

我一直在尝试使用您的实验来对来自几个博客的文本进行性别分类。然而,我得到的准确率很低,接近50%。您对如何预处理我的数据以适应模型有什么建议吗?每个博客文本大约有6000个单词,我正在研究如何预处理以应用于您的模型。

谢谢

哇,很酷的项目,Eduardo。

我想知道你是否可以将问题简化到只处理文章的第一句话或第一段。

我想知道你是否可以使用一个好的词嵌入。

我还想知道你是否可以使用CNN而不是LSTM来进行分类——或者至少比较一下单独的CNN与CNN + LSTM,并深入研究哪种效果最好。

总的来说,这里有很多关于提高深度学习问题性能的建议

https://machinelearning.org.cn/improve-deep-learning-performance/

嗨,Jason,

感谢您花费时间提供这个非常有用的教程。

我想知道您是否会考虑在每次训练迭代(epoch)之前随机打乱数据?

谢谢

嗨,Emma,

很好的问题。数据会在每次迭代(epoch)之前通过 fit() 函数自动打乱。

请在此处查看有关 fit() 函数中 shuffle 参数的更多信息

https://keras.org.cn/models/sequential/

嗨,Jason,

您能展示一下如何将所有单词转换为整数,以便它们可以输入 Keras 模型吗?

在 IMDB 中,它们直接使用整数,但我的问题是,我有很多行文本,我必须对它们进行分类(多类别问题)。

此外,在使用 LSTM+CNN 时,我遇到了一个错误

错误 (theano.gof.opt): 优化失败,原因:local_abstractconv_check

错误 (theano.gof.opt): 节点:AbstractConv2d{border_mode=’half’, subsample=(1, 1), filter_flip=True, imshp=(None, None, None, None), kshp=(None, None, None, None)}(DimShuffle{0,2,1,x}.0, DimShuffle{3,2,0,1}.0)

错误 (theano.gof.opt): 堆栈跟踪

错误 (theano.gof.opt): 堆栈跟踪 (最近一次调用)

文件 “C:\Anaconda2\lib\site-packages\theano\gof\opt.py”,第 1772 行,在 process_node 中

replacements = lopt.transform(node)

文件 “C:\Anaconda2\lib\site-packages\theano\tensor\nnet\opt.py”,第 402 行,在 local_abstractconv_check 中

node.op.__class__.__name__)

AssertionError: AbstractConv2d Theano 优化失败:没有可用的实现支持所请求的选项。您是否从优化器中排除了 “conv_dnn” 和 “conv_gemm”?如果在 GPU 上,cuDNN 是否可用并且 GPU 是否支持它?如果在 CPU 上,您是否安装了 Theano 可以链接的 BLAS 库?

我正在 Windows 上使用 Theano 后端和仅 CPU 运行 Keras。

谢谢

嗨,Jason,

您能告诉我IMDB数据库是如何存储数据的吗?是文本还是向量?

谢谢。

嗨,Thang Le,IMDB数据集最初是文本。

这些词被转换为整数(每个词一个整数),我们将数据建模为固定长度的整数向量。因为我们使用固定长度的向量,我们必须将数据截断和/或填充到这个固定长度。

谢谢你,Jason!

那么当我们调用 (X_train, y_train), (X_test, y_test) = imdb.load_data() 时,X_train[i] 会是一个向量。如果它是向量,我该如何将我的文本数据转换为向量以在此处使用?

嗨,Le Thang,好问题。

你可以将每个字符转换为一个整数。然后每个输入都将是一个整数向量。之后,你可以使用一个嵌入层将你的整数向量转换为投影空间中的实值向量。

嗨,Jason,

据我理解,X_train 是电影评论中作为输入的变长词序列,那么 Y_train 代表什么呢?

谢谢!

嗨,Quan Xiu,Y 是输出变量,Y_train 是训练数据集的输出变量。

对于这个数据集,输出值是电影情感值(正面或负面情感)。

谢谢你,Jason。

那么当我们把 X_test 作为输入时,输出会与 y_test 进行比较来计算准确率,对吗?

是的,Quan Xiu,模型做出的预测会与 y_test 进行比较。

这个LSTM网络的性能低于TFIDF + 逻辑回归

https://gist.github.com/prinsherbert/92313f15fc814d6eed1e36ab4df1f92d

你确定隐藏状态不是以非常昂贵的方式简单地计算单词吗?

确实如此,这个例子并没有针对最佳性能进行调优,Herbert。

这留下了一个相当重要的问题:它是否真的学习了比词频计数更复杂的特征?LSTM 通常会这样做吗?显然有关于这个主题的文献,但我认为你的帖子在 LSTM 的能力方面有些误导。如果能看到一个 LSTM 优于 TFIDF 的例子,并提供所需数据类型和大小的 ধারণা,那将是非常棒的。(尽管感谢您的快速回复 :)

LSTMs 只有在它们真正记住上下文信息时才有用,而不是仅仅拟合简单模型并花费很长时间来做这件事。

我同意,Herbert。

LSTMs 很难使用。最初,我想分享如何开始使用这项技术。我打算回到这个例子,测试新的配置,以便从该方法中获得更多/最大的收益。

那太棒了!如果能了解良好性能所需的数据大小(当然,还有成千上万的其他开放问题),那也会很不错 :)

非常感谢您的帖子,Jason。它很有帮助。

我有一些简短的问题。首先,我选择模型的超参数时感到紧张,例如向量长度(32)、嵌入单元数量(500)、LSTM单元数量(100)、最常用词数量(5000)。这取决于数据集,不是吗?我们如何选择参数?

其次,我有一个关于每日新闻的数据集,用于预测股票市场的价格走势。但是,每条新闻的单词数量似乎比IMDB数据集中的每个评论都多。平均每条新闻约2000个单词,您能推荐我如何选择近似的超参数吗?

谢谢,(附注:抱歉我的英语如有任何错误)

嗨,Huy,

我们必须做出选择。最佳实践是对这些参数中的每一个进行网格搜索,并选择最佳性能和模型鲁棒性。

也许你只使用最常见的 n 个词。

也许你可以使用文章的投影或嵌入。

也许你可以先对文本使用一些经典的 NLP 方法。

感谢您的快速回复,

我是深度学习新手,选择相关参数似乎真的很难。

您是如何得到 16,750 的?25,000 / 64 个批次是 390。

谢谢!

根据我的理解,训练时,迭代次数(epoch)通常超过100次才能评估监督机器学习结果。但是,在您的示例或 Keras 示例中,只有3-15次迭代。您能解释一下吗?

谢谢,

迭代次数因算法和问题而异。Huy,没有固定的规则,让结果来指导一切。

那么,我们如何选择合适的迭代次数(epochs)呢?

在你的问题上进行试错,并仔细观察训练和验证数据集的学习率。

我正在寻找 Keras 上 LSTM 网络在已知/公共数据集上的基准测试。

您能否分享此帖子中的示例是在何种硬件配置(GPU/CPU/RAM 等)上运行的?

谢谢

我使用了 AWS,配置为 g2.2xlarge。

在 Keras 中是否可能获取分类器在每个词通过网络传播时的输出?

嗨,Mike,你一次只能做一个预测。

不确定如何查看权重传播过程——我还没有用 Keras 这样做过。

你好,

要将您的二元分类模型用于多标签分类,需要进行哪些更改?

还有,如果输入数据是原始文本格式而不是像 IMDB 那样的数字格式,您会采取哪些步骤来处理数据集使其与 IMDB 兼容?

Jason,干得好。

我非常喜欢它……

如果您能告诉我如何使用 LSTM 循环神经网络进行序列聚类(无监督学习任务),我将不胜感激。

抱歉,我没有将 LSTM 用于聚类。我无法为您提供好的建议。

嗨,Jason,

您的书对我很有帮助。我有一个关于时间序列分类器的问题。假设我有 8 类时间序列数据,每类有 200 个训练数据和 50 个验证数据,我如何使用 scikit-learn 包或其他工具,根据每类所有 50 个验证数据来估计分类准确率(例如对数最大似然)?如果您能给我一些建议,我将不胜感激。提前非常感谢。

此致,

Ryan

嗨,Ryan,sklearn 支持的分类度量列表可能有助于作为起点

https://scikit-learn.cn/stable/modules/classes.html#classification-metrics

Logloss 是一个非常有用的度量,用于评估学习算法在多类分类问题上的性能

https://scikit-learn.cn/stable/modules/generated/sklearn.metrics.log_loss.html#sklearn.metrics.log_loss

希望这些能作为一个开始有所帮助。

嗨,Jason,非常感谢。我将尝试这个对数损失。

告诉我进展如何。

嗨,Jason,

对于将文本转换为整数以进行正确和更好的分类,词袋模型(Bags of words)还是词嵌入(word embedding)哪个方法更好?

我对此有点困惑。

提前感谢

嗨,Shashank,词嵌入目前很流行。我建议两种都试一试,看看哪种表示方法最适合你。

嗨 Jason,感谢您的教程,我发现它们非常清晰有用,但是当我想用它解决另一个问题设置时,我有一个小问题..

正如您在帖子中指出的,单词被嵌入为向量,我们将向量序列输入模型进行分类.. 正如您提到的 CNN 处理词向量内部的隐式空间关系(希望我理解正确),所以我有两个与此操作相关的问题

1. 嵌入层是特定于单词的吗,也就是说,Keras 有自己的词汇和相似性定义来处理我们输入的单词序列吗?

2. 如果我有一个二维矩阵序列,比如一张图像,我应该如何转换它们以满足 CNN 层或直接 LSTM 层的所需输入形状?例如,结合您关于时间序列数据的教程,我得到一个大小为 (5000, 5, 14, 13) 的 trainX,其中 5000 是样本长度,5 是 look_back(或 time_step),而这里我有一个矩阵而不是单个值,但我认为我应该在这里使用我特定的嵌入技术,这样我就可以在 CNN 或 LSTM 层之前传递一个矩阵而不是一个向量….

抱歉,如果我的问题描述不清,但我的意图确实是为了获取数据中存在的时空连接……所以我想将一个矩阵序列作为单个样本输入到我的模型中……并且输出将是一个矩阵……

感谢您的耐心!

33202176/33213513 [============================>.] – ETA: 0s 19800064/33213513 [================>………….] – ETA: 207s – ETA: 194s____________________________________________________________________________________________________

层(类型)输出形状参数 # 连接到

====================================================================================================

embedding_1 (嵌入) (None, 500, 32) 160000 embedding_input_1[0][0]

____________________________________________________________________________________________________

lstm_1 (LSTM) (None, 100) 53200 embedding_1[0][0]

____________________________________________________________________________________________________

dense_1 (密集) (None, 1) 101 lstm_1[0][0]

====================================================================================================

总参数:213301

____________________________________________________________________________________________________

无

Epoch 1/3

内核已终止,正在重启

pip install -U numpy

解决了问题

感谢分享!

嗨,Jason,

感谢这篇好文章。由于 IMDb 数据非常大,我尝试用垃圾邮件数据集替换它。我应该对原始代码进行哪些更改才能运行它?我已经在 stack-overflow 上问过这个问题,但目前还没有答案。http://stackoverflow.com/questions/41322243/how-to-use-keras-rnn-for-text-classification-in-a-dataset ?

有什么帮助吗?

好主意!

我建议您将每个单词编码为一个唯一的整数。然后您就可以将其用作嵌入层的输入。

嗨,Jason,

感谢您的帖子。它真的很有帮助。当我运行此代码时,我是否需要为 tensorflow 配置才能使用 GPU,或者它是否会自动选择 GPU(如果可用)?

这些示例很小,在 CPU 上运行速度很快,不需要 GPU。

我在 CPU 上试过,运行良好。我计划复制这个过程,并为不同的用例扩展您的方法。与此相比,它的维度更高。您有没有关于使用 GPU 的教程?我可以在 GPU 上实现相同的代码吗,还是格式完全不同?

相同的代码,后端的使用由您正在使用的 Theano 或 TensorFlow 后端控制。

Jason,

感谢有趣的教程!您对如何将训练用于分类序列的 LSTM 反过来用于生成新序列有什么想法吗?也就是说,既然它“知道”一个正面评论听起来像什么,能否用它来生成新的、原创的正面评论?(请忽略这种设置可能存在的邪恶用途 :)

有几个有趣的例子,LSTM 被训练来学习序列以生成新序列……但是,它们没有分类的概念,或者不理解什么是“好”序列与“坏”序列,不像您的模型。所以,我本质上对合并这两种方法感兴趣——用一些“好”和“坏”序列训练 LSTM,然后让它生成新的“好”序列。

任何想法或指点都将非常受欢迎!

我自己没有研究过这个。我没有任何现成的妙语,我认为这需要仔细思考。

这篇帖子可能有助于解决问题的另一方面,即文本生成

https://machinelearning.org.cn/text-generation-lstm-recurrent-neural-networks-python-keras/

我很乐意听听你的进展。

谢谢,如果你有任何疯狂的想法,请告诉我 :)

我正在考虑的一种普通的做法是,让分类器简单地“剔除”不想要的输入,然后只将想要的输入馈送到一个新的 LSTM 中,该 LSTM 可以使用您的另一篇帖子中的方法来生成更多类似的序列。

这似乎不太理想,因为它感觉我正在丢弃一些关于什么构成不想要的序列的知识……但是,另一方面,我在选择分类器算法方面有更大的自由度。

感谢您的本教程。

关于变长问题,尽管其他人已经问过,我还有一个问题。

如果我的数据集长度偏差很大,比如说,有些文本只有10个词,有些有100000个词。因此,如果我只选择1000作为我的maxlen,我会丢失很多信息。

如果我选择100000作为maxlen,我将消耗过多的计算能力。

有没有其他方法来处理这个问题?(不进行填充或截断)

另外,您能写一个关于如何在 RNN 中使用 word2vec 预训练嵌入的教程吗?

不是 word2vec 本身,而是如何使用 word2vec 的结果。

基于计数的词表示丢失了太多的语义信息。

很好的问题,Albert。

关于长序列问题,我目前没有现成的答案。这需要进一步研究。

很乐意尝试制作使用 word2vec 表示的教程。

我只有生物学背景,但我可以重现结果。太棒了。

很高兴听到,Charles。

嗨 Jason,我注意到您提到了针对 Tensorflow 0.10.0 更新的示例。我只能看到 Keras 代码,是不是我错过了什么?

谢谢。

嗨,Jax,

Keras 运行在 Theano 和 TensorFlow 之上。使用 Keras 需要其中一个。

我只是留下了一个注释,说明该示例已在更新版本的 Keras 上使用更新版本的 TensorFlow 后端进行了测试。

我不确定我是否理解这里的循环和序列如何工作。

我期望你会为每个评论输入一个序列的独热向量,其中每个独热向量代表一个单词。这样,你就不需要评论的最大长度(也不需要填充),我可以看到你如何一次一个词地使用循环。

但我理解你是一次性输入整个评论,所以它看起来像是前馈。

你能解释一下吗?

嗨,Kakaio,

是的,我们确实一次输入一个评论。这是我们用于多层感知机(MLP)的输入结构。

在内部,将 LSTM 网络视为根据评论中的词序列构建状态,并从该序列学习适当的情感。

LSTM 如何利用循环在词序列上建立状态?你是一次性将所有序列输入 LSTM,没有时间步。

嗨,Kakaop,完全正确。这个例子没有利用循环。

通过本教程,我如何预测测试值并将其写入文件?这些预测值是否以编码格式生成?

各位,这是一篇非常清晰实用的文章,感谢提供的 Keras 代码。但是我似乎找不到任何运行训练好的模型进行预测的示例代码。imdb.py 中没有,它只进行评估。有没有人能提供一些预测的示例代码?

嗨,Bruce,

你可以用所有训练数据拟合模型,然后使用以下方法预测新输入:

这有帮助吗?

那不是难点。不过,我可能已经弄清楚我需要知道什么了。那就是获取 model.predict 返回的结果,并将数组中的最后一个项作为分类。有没有人不同意?

嗨,这是一个很棒的教程。

我有一个关于你模型的问题。

我是 RNN 的新手,所以这个问题可能很愚蠢。

在你的设置中,输入词嵌入层对于序列分类而不是预测下一个词至关重要吗?

通常,词嵌入(或类似的投影)是 NLP 问题的良好表示。

嗨,Jason,

很棒的教程。对我帮助很大。

我注意到在第一部分,你在模型上调用了 fit(),其中包含 "validation_data=(X_test, y_test)"。这在最终代码摘要中没有。所以我想知道这只是一个错误,还是你后来忘记了。

但话又说回来,使用测试数据集进行验证对我来说似乎是错误的。你对此有何看法?

模型此时不使用测试数据,它只是在其上进行评估。这有助于了解模型的运行情况。

如果代码使用100个单元的LSTM,而句子长度为200,会发生什么?这意味着只有句子中的前100个词作为输入,而最后100个词将被忽略吗?

不,隐藏层中的单元数量和序列长度是不同的配置参数。

如果你愿意,可以使用1个单元和2K的序列长度,但模型不会学习它。

希望这能有所帮助。

嗨,Jason,

在最后一部分,LSTM层返回一个序列,对吗?之后密集层只接受一个参数。密集层怎么知道它应该接受最后一个参数?或者它甚至会接受最后一个参数吗?

不,在这种情况下,每个 LSTM 单元只返回一个值,而不是一个序列。

嗨,Jason,

非常有趣和有用的文章。感谢您撰写如此有用的文章。我有幸阅读了您其他非常有用的文章。

只是想问一下,我们如何编码新的测试数据,使其与程序所需的格式相同。我想转换过程中没有涉及字典。那么我们如何进行这种转换呢?例如,考虑一个样本句子“Very interesting article on sequence classification”。其编码后的数字表示是什么?

提前感谢

很好的问题。

您可以将字符编码为整数(整数编码),然后将整数编码为布尔向量(独热编码)。

Jason,很棒的文章。我想继续 Prashanth 的问题,如何预处理用户输入。如果我们使用 CountVectorizer(),当然,它会将其转换为所需的格式,但单词将不再与以前相同。甚至一个新单词也会创建额外的元素。您能否解释一下,如何预处理用户输入,使其与训练好的模型相似。提前感谢。

你可以分配一个包含100万个单词的字母表,所有整数从1到100万,然后对你看到的任何单词使用该编码。

其思想是在你的编码方案中有一个缓冲区。

另外,如果你删除所有低频词,这会给你更多的缓冲区。通常25K个词就足够了。

您的回答确实解开了我许多疑问。非常感谢您的快速回复。我现在对接下来该怎么做有了一些想法。

很高兴听到这个消息,Manish。

我的数据集只是一个向量特征,例如 [1, 0.5, 1, 1, 2, 1] -> y 只是 0,1 二进制或类别,例如 0,1,2,3。我想使用 LSTM 进行二进制或类别分类,我该怎么做呢?我只添加了 LSTM 和 Dense,但是 LSTM 需要 3 维输入,而 Dense 只需要 2 维。我知道我需要时间序列,我尝试了更多,但一无所获。你能解释并告诉我怎么做吗?拜托了,非常感谢

你可能需要考虑一个 seq2seq 结构,其中包含用于输入序列的编码器和用于输出序列的解码器。

像这样

我有一个关于这个的教程已计划发布。

希望这能有所帮助。

谢谢,我会努力找出答案,然后回复你。

不客气。

嗨,我在您的另一篇文章中有一个问题,关于为什么我使用函数 model.evaluate(x_test, y_test) 来获取模型在用训练数据集训练后的准确率分数,但在某些情况下它返回的结果 >1,我不知道为什么,这让我无法相信这个函数。您能为我解释一下原因吗?

抱歉,我不理解你的问题,你是否可以重新表述一下?

我不知道函数 evaluate 返回的结果大于 1,但我认为它应该只在 0 到 1 之间(model.evaluate(x_test, y_test),其中 model 是我之前用训练数据集训练过的)。

嗨,Jason,你能一步一步地解释你的代码吗?我跟着这个教程:https://blog.keras.org.cn/building-autoencoders-in-keras.html,但我有些困惑,不理解。:(。

如果您对该帖子有疑问,我建议您联系作者。

亲爱的 Joson

我是深度学习新手,打算在 keras 或 tensorflow 上进行语料库分析。您能帮助我或给我一些基本教程吗?

致敬

Mazhar Ali

抱歉,我只有 Keras 的教程

https://machinelearning.org.cn/start-here/#deeplearning

感谢您的友好解释。

我从您的书中得到了很多帮助。

您愿意在 IMDB LSTM 示例中添加 fit_generator 和批归一化的示例吗?

有人告诉我使用 fit_generator 函数来处理大量数据。

如果有一个例子,对购书者将非常有帮助。

我希望将来能添加这类示例。感谢您的建议。

嗨 Jason

我想知道在哪里可以读到更多关于 dropout 和 recurrent_dropout 的内容。你有没有一些论文或资料可以探索一下?

谢谢!

我这里有一个关于 dropout 的教程

https://machinelearning.org.cn/dropout-regularization-deep-learning-models-keras/

我计划很快在博客上发布一篇关于循环 dropout 的文章。

嗨,Jason,

我的数据集形状有问题

x_train = numpy.random.random((100, 3))

y_train = uti.to_categorical(numpy.random.randint(10, size=(100, 1)), num_classes=10)

model = Sequential()

model.add(Conv1D(2,2,activation=’relu’,input_shape=x_train.shape))

model.compile(loss=’binary_crossentropy’, optimizer=’adam’, metrics=[‘accuracy’])

model.fit(x_train,y_train, epochs=150)

我尝试创建随机数据集,并将其传递给 Conv1D,但我不知道为什么,Conv1D 接受了我的形状(我认为它自动设置了 None 值),但 fit 不接受(我认为是因为 Conv1D 接受了 3 维)。我收到此错误:

ValueError: Error when checking model input: expected conv1d_1_input to have 3 dimensions, but got array with shape (100, 3)

您的输入数据必须是3维的,即使其中一两个维度宽度为1。

嗨,Jason,

感谢这篇精彩的文章!

我想就我的数据集训练提供一些建议。我拥有的数据是按时间测量的一维数据,每个实例都有一个二进制标签。

感谢您的博客,我成功地构建了一个 LSTM,并且它在分类主导类方面做得很好。主要问题是 0 和 1 的比例非常高。1 的数量大约是 0 的 0.03 倍。在大多数情况下,当这些测量值很高时,1 就会出现。因此,我认为如果模型能够看到过去 “p” 次测量值,LSTM 模型就可以做出更好的预测。直观地,它会识别测量值异常增加并将其行为与输出 1 相关联。

了解一些这些基本背景知识后,您能否建议一个结构,该结构可能

1.) 有助于利用异常高测量值与输出 1 的结构

2.) 有助于处理低暴露的 1 实例

感谢任何帮助或参考资料!

祝好!

嗨,Len,

也许你可以使用一些用于不平衡数据集的重采样方法。

https://machinelearning.org.cn/tactics-to-combat-imbalanced-classes-in-your-machine-learning-dataset/

嗨,这是一个很棒的教程!

只是想知道:既然您用零填充,为什么不将 Embedding 层的 mask_zero 标志设置为 True 呢?

如果不这样做,填充符号会影响成本函数的计算,不是吗?

这是一个好建议。也许我写这个例子的时候那个标志还不存在。

如果你发现有益,请告诉我。

嗨,Jason,

很棒的教程!帮助很大。

不过我有一个理论问题。序列分类仅仅基于 LSTM 的最后一个状态,还是必须将密集层用于所有隐藏单元(在这种情况下是 100 个 LSTM)?序列分类仅仅基于最后一个状态是否可能?我看到的大多数实现都使用密集层和 softmax 进行序列分类。

我们确实需要密集层来解释 LSTM 所学到的东西。

LSTM 正在根据输入时间步和内部状态来建模问题。

嗨,Jason,

你能告诉我 LSTM 中的 time_step 吗?举个例子或者其他容易理解的方式。如果我的数据是 2 维的,[[1,2]…[1,3]] 输出:[1,…0],那么使用 keras,LSTM 层需要 3 维,所以我只能将输入数据重塑为 time_step = 1 的 3 维,可以这样训练吗?time_step > 1 会更好吗?我想知道 LSTM 中 time_step 的含义,非常感谢你阅读我的问题。

你可以这样做,但最好在时间步中提供序列信息。

LSTM 正在开发一个关于先前时间步观察值的函数。

嗨,Jason,

首先,感谢您的精彩解释。

我正在考虑根据您在另一篇文章中的解释设置一个 aws g2.2xlarge 实例。您是否有基准(例如,上述示例之一的 1 个 epoch 的时间),以便我可以与我当前的硬件进行比较?

抱歉,我没有任何执行时间基准。

在使用 LSTM 时,我通常从大型 AWS 实例中获得巨大收益,因为可以访问更多的内存(更大的数据集)。

在 GPU 上运行 CNNs 比在 GPU 上运行 LSTMs 收益更大。

嗨,Jason,

我也对填充问题感到好奇。我认为 pad_sequence 是获得固定长度序列的方法。然而,除了填充零,我们实际上可以缩放数据吗?

那么,问题是 1) 如果缩放序列会扭曲句子的含义,考虑到句子被表示为序列,以及 2) 如何选择一个好的缩放因子。

谢谢你。

很好的问题。

通常,缩短单词序列长度的好方法是首先删除低频词,然后将序列截断到所需的长度或填充到该长度。

对于使用 LSTM,为什么我们仍然需要将输入序列缩放为固定大小?为什么不构建像 seq2seq 这样的模型,只是多输入到一输出?

即使使用 seq2seq,你也必须将输入数据向量化。

我看到了从 IMDB 加载的数据,它已经被编码为数字。

为什么我们还需要另一个嵌入层来进行编码?

(X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=top_words)

print X_train[1]

输出如下:

[1, 194, 1153, 194, 2, 78, 228, 5, 6, 1463, 4369,…

嵌入是一种更具表现力的表示,可以带来更好的性能。

感谢 Jason 的文章和回答评论。我可以使用这种方法来解决我在 Stack Overflow 问题中描述的问题吗?请看一下。

http://stackoverflow.com/questions/43987060/pattern-recognition-or-named-entity-recognition-for-information-extraction-in-nl/43991328#43991328

也许吧,我建议寻找一些现有的研究来模板化解决方案。

感谢 Jason 的文章。我用 keras 实现了一个 CNN 后面接 LSTM 神经网络模型用于句子分类。但是经过 1 或 2 个 epoch 后,我的训练准确率和验证准确率停滞在某个数字,并且不再变化。就像它卡在某个局部最小值或其他原因一样。我该怎么做才能解决这个问题?如果我的模型只使用 CNN,那么训练和验证准确率都会收敛到很好的准确率。你能在这方面帮助我吗?我无法识别问题。

这是训练和验证准确率。

Epoch 1/20

1472/1500 [============================>.] -8s – loss: 0.5327 – acc: 0.8516 – val_loss: 0.3925 – val_acc: 0.8460

Epoch 2/20

1500/1500 [==============================] – 10s – loss: 0.3733 – acc: 0.8531 – val_loss: 0.3755 – val_acc: 0.8460

Epoch 3/20

1500/1500 [==============================] – 8s – loss: 0.3695 – acc: 0.8529 – val_loss: 0.3764 – val_acc: 0.8460

Epoch 4/20

1500/1500 [==============================] – 8s – loss: 0.3700 – acc: 0.8531 – val_loss: 0.3752 – val_acc: 0.8460

Epoch 5/20

1500/1500 [==============================] – 8s – loss: 0.3706 – acc: 0.8528 – val_loss: 0.3763 – val_acc: 0.8460

Epoch 6/20

1500/1500 [==============================] – 8s – loss: 0.3703 – acc: 0.8528 – val_loss: 0.3760 – val_acc: 0.8460

Epoch 7/20

1500/1500 [==============================] – 8s – loss: 0.3700 – acc: 0.8528 – val_loss: 0.3764 – val_acc: 0.8460

Epoch 8/20

1500/1500 [==============================] – 8s – loss: 0.3697 – acc: 0.8531 – val_loss: 0.3752 – val_acc: 0.8460

Epoch 9/20

1500/1500 [==============================] – 8s – loss: 0.3708 – acc: 0.8530 – val_loss: 0.3758 – val_acc: 0.8460

Epoch 10/20

1500/1500 [==============================] – 8s – loss: 0.3703 – acc: 0.8527 – val_loss: 0.3760 – val_acc: 0.8460

Epoch 11/20

1500/1500 [==============================] – 8s – loss: 0.3698 – acc: 0.8531 – val_loss: 0.3753 – val_acc: 0.8460

Epoch 12/20

1500/1500 [==============================] – 8s – loss: 0.3699 – acc: 0.8531 – val_loss: 0.3758 – val_acc: 0.8460

Epoch 13/20

1500/1500 [==============================] – 8s – loss: 0.3698 – acc: 0.8531 – val_loss: 0.3753 – val_acc: 0.8460

Epoch 14/20

1500/1500 [==============================] – 10s – loss: 0.3700 – acc: 0.8533 – val_loss: 0.3769 – val_acc: 0.8460

Epoch 15/20

1500/1500 [==============================] – 9s – loss: 0.3704 – acc: 0.8532 – val_loss: 0.3768 – val_acc: 0.8460

Epoch 16/20

1500/1500 [==============================] – 8s – loss: 0.3699 – acc: 0.8531 – val_loss: 0.3756 – val_acc: 0.8460

Epoch 17/20

1500/1500 [==============================] – 8s – loss: 0.3699 – acc: 0.8531 – val_loss: 0.3753 – val_acc: 0.8460

Epoch 18/20

1500/1500 [==============================] – 8s – loss: 0.3696 – acc: 0.8531 – val_loss: 0.3753 – val_acc: 0.8460

Epoch 19/20

1500/1500 [==============================] – 8s – loss: 0.3696 – acc: 0.8531 – val_loss: 0.3757 – val_acc: 0.8460

Epoch 20/20

1500/1500 [==============================] – 8s – loss: 0.3701 – acc: 0.8531 – val_loss: 0.3754 – val_acc: 0.8460

我在这里提供了一些想法,帮助您提高深度学习项目的性能。

https://machinelearning.org.cn/improve-deep-learning-performance/

Jason,感谢您的精彩帖子。

我是 DL 的初学者。

如果我需要将一些行为特征纳入此分析,例如:年龄、性别、邮政编码、时间 (DD:HH)、季节 (春/夏/秋/冬)… 您能给我一些实现提示吗?

不胜感激

每个都是输入数据上的不同特征。

请记住,输入数据必须结构化为 [样本数, 时间步数, 特征数]。

我的数据形状是 (8000,30),我需要使用 30 个时间步。

我这样做:

model.add(LSTM(200, input_shape=(timesteps,train.shape[1])))

但当我运行代码时,它给我一个错误:

ValueError: Error when checking input: expected lstm_20_input to have 3 dimensions, but got array with shape (8000, 30)

如何将训练数据的形状更改为您提到的格式

记住,输入数据必须是 [样本数, 时间步数, 特征数] 的结构。(8000,30,30)

这篇文章将帮助您处理 LSTM 数据形状的问题。

https://machinelearning.org.cn/reshape-input-data-long-short-term-memory-networks-keras/

你好,

我怎样才能使用我自己的数据,而不是 IMDB 来进行训练?

谢谢

Kadir

您需要将文本数据编码为整数。

你好杰森博士,

非常感谢您的博文。它们无疑是互联网上最好的文章之一。

不过我有一个疑问。在您描述的第一个例子中,为什么您使用验证数据集作为 x_test 和 y_test?我只是觉得有点困惑。

提前感谢

谢谢。

我这样做是为了在模型拟合时了解模型的技能。您不需要这样做。

我按照您说的在 CNN+RNN 上添加了 dropout,准确率达到了 87.65%。我仍然不清楚为什么将两者结合起来,因为我以为 CNN 是用于图像或视频等 2D+ 输入的。但无论如何,您的教程为我深入研究 RNN 提供了一个很好的起点。非常感谢!

很高兴听到这个消息。

感谢这篇帖子。

如果我理解正确,在嵌入层之后,训练数据中的每个样本(每个评论)都被转换为一个 32x500 的矩阵。从音频频谱图类比来看,它是一个 32 维的频谱,具有 500 个时间帧。

有了上述等效或类比,我可以使用音频原始频谱图作为输入和类别标签(无论是好是坏的音频质量)来执行音频波形分类,代码与此帖子中的完全相同(除了嵌入层)。这是正确的吗?

此外,我想知道为什么输入长度必须相同,即帖子中的 500。如果我在在线训练的背景下进行,每次只有一个样本被输入到模型中(批量大小为 1),那么应该不用担心样本长度不同对吧?也就是说,每个样本(长度不同,无需填充)及其目标被一个接一个地用于训练模型,并且不用担心长度不同。这仅仅是 Keras 中实现的问题,还是理论上每个样本的输入长度都应该相同?

你好 Fred,

是的,试试看。

向量化输入要求所有输入具有相同的长度(为了后端库的效率)。您可以使用零填充(甚至掩码)来满足此要求。

我认为大小参数在网络定义中是固定的。您可以从批量到批量进行操作,在过程中重新定义+编译您的网络,但这效率不高。

谢谢你的回复,我会尝试的。

我只是想知道 RNN 或 LSTM 在理论上是否要求每个输入都具有相同的长度。

据我所知,RNN 优于 DNN 的优势之一是它接受变长输入。

如果这个要求是为了 Keras 中的效率问题,并且零(如果使用零填充)被认为是零信息,那对我来说没什么困扰。在音频频谱图的情况下,您会推荐零填充原始波形(一维)还是频谱图(二维)?根据您帖子的类比,选择应该是前者。

你好 Fred,

理论上 LSTM 不需要填充,它只是高效实现的一个限制,需要向量化输入。

对于大多数应用程序来说,这可能是一个公平的权衡。

嗨,Jason,

在 RNN(Keras 实现)中是否有办法控制 LSTM 的注意力?

我有一个数据集,其中 100 个时间序列输入作为序列输入。我希望 LSTM 更重视最后 10 个时间序列输入。

可以做到吗?

提前感谢。

是的,但您必须编写一个自定义层来实现注意力。

我希望很快能介绍 LSTM 的注意力模型。

嗨,Jason,

构建并保存模型后,我想用它来对新文本进行预测,但我不知道如何预处理纯文本以便用于预测。我搜索了一下,找到了这种方法:

text = np.array([‘这是一个随机句子’])

tk = keras.preprocessing.text.Tokenizer( nb_words=2000, lower=True,split=" ")

predictions = loaded_model.predict(np.array(tk.fit_on_texts(text)))

但这对我不起作用,并显示以下错误:

ValueError: 检查时出错:embedding_1_input 需要有 2 个维度,但得到的数组形状为 ()

您能告诉我预处理文本的正确方法吗?任何帮助都将不胜感激。

谢谢

通常,您需要对单词进行整数编码。

谢谢回复

我这样转换了我的字符串:

text = ‘这是一部值得一看的好电影’

import keras.preprocessing.text

text = keras.preprocessing.text.one_hot(text, 5000, lower=True, split=” “)

text = [text]

text = sequence.pad_sequences(text, 500)

predictions = loaded_model.predict(text)

但得到的输出是:[[ 0.10996077]]

它不应该接近 1 吗?

非常感谢。

抱歉,我不明白。你为什么期望输出为 1?你预测的是什么?

我理解的是,1 是积极情绪的标签,由于我使用积极的陈述进行预测,所以我期望输出为 1。

我在上一个评论中犯了一个错误,使用了 model.predict() 来获取类别标签,获取标签的正确方法是 model.predict_classes(),但它仍然没有给出正确的类别标签。

所以我的问题是,我将文本转换为独热向量是否犯了错误,还是这样做的正确方法。

非常感谢。

只要您在数据准备和另一端的解释方面保持一致,就应该没问题。

您能做一个关于预处理文本数据集,然后使用词嵌入作为输入的教程吗?谢谢!

好建议。它在我的列表上名列前茅!

我们能否将序列标注问题应用于连续变量?我拥有客户在到期日内、缓冲期内和缓冲期外偿还债务的数据集。在此基础上,我想根据客户的好坏程度给他们打分。这是否可以使用序列标注来实现?

也许吧,我不确定我是否理解您的数据集。您能给出一个单案例示例吗?

你好 Jason,很棒的教程!

我有的数据如下

文本 字母数字 标签

“foo” A1034 A

“bar” A1234 B

我已经将 LSTM 模型从文本列映射到标签列。但是,我需要将字母数字列与文本作为额外特征添加到我的 LSTM 模型中。我如何在 Keras 中做到这一点?

考虑独热编码。

您好,这真的太棒了,很高兴这个教程是我在 LSTM 上的第一个实际项目。我需要在您的代码中使用 f-measure、假阳性和 AUC,而不是“准确率”。您有什么办法可以获取它们吗?

先谢谢您了。

Sajad,

您可以进行预测,然后使用预测数组和预期值来计算 sklearn 中的这些分数

https://scikit-learn.cn/stable/modules/classes.html#sklearn-metrics-metrics

我有一个关于 Keras 内置嵌入层的问题。

我用 word2vec 模型完成了词嵌入,该模型基于词语的语义相似性工作——在相同上下文中的词语更相似。我想知道 Keras 嵌入层是否也遵循 w2v 模型,还是有自己的算法将词语映射到向量?

它根据什么语义将词语映射到向量?

好问题,这里有更多相关内容

https://keras.org.cn/layers/embeddings/

谢谢 Jason!

我查阅了大部分关于这个的文档,但没有一个提到这种内置词嵌入过程背后的语义。

我想知道它,因为我现在一直认为这个方法内部的过程可能会导致准确率低下!

如果您找到任何相关信息,请随时告知我。

我建议阅读这里的代码

https://github.com/fchollet/keras/blob/master/keras/layers/embeddings.py#L11

嗨,Jason,

精彩的文章。我正在尝试使用 CNN 对时间序列数据进行建模,并将其输入到 LSTM 进行监督学习。我有一个二维矩阵,其中列代表之前的 n 个时间步,行代表每个时间步访问的不同价格水平。

价格 柱0 柱1 柱2 柱3 柱4 柱5 ...

0 0 0 1 1 0 0

1 1 0 1 1 0 1

2 1 1 1 1 1 1

3 1 1 0 1 1 0

4 0 0 0 0 1 0

…

这个矩阵将代表价格数据

高 低

柱0 3 1

柱1 3 2

柱2 2 0

柱3 3 0

柱4 4 2

柱5 2 1

您能告诉我如何将您的 1-d CNN 调整为 2-d CNN 吗?

嗨,Jason,

对我来说是很棒的帖子。

但我想问您:嵌入层中的向量长度,您说“第一层是嵌入层,使用 32 长度向量来表示每个单词”,为什么您选择 32 而不是其他数字,比如 64 或 128,您能给我一些最佳实践,或者您选择的原因吗?

非常感谢您。

反复试验。您可以尝试其他表示法,看看哪种最适合您的问题。

谢谢 Jason。

不客气。

@Jason,

“序列分类是一个预测建模问题,其中您有一些跨空间或时间的输入序列,任务是预测序列的类别。”

这很鼓舞人心。我正在考虑使用序列分类来处理 IRIS 数据集。

您认为它有效吗?

鸢尾花数据集不是一个序列分类问题。它只是一个分类问题。

@Jason,

你的意思是

我不能将 LSTM 用于 IRIS 分类吗?我正在研究类似 IRIS 的数据集。所以我正在探索所有可能的分类器。您的网站上就有一个。此外,

我尝试了 SKLearn 中的 RBM,它不起作用,因为我的输入不是像 MNIST 数据集那样的二元输入(即使在 SKLearn 的 preprocessing.binarizer() 函数之后)。我认为他们说 SKLearn 中的 RBM 适用于 [0,1] 范围内的数据是错误的,它只适用于 0 和 1。

(顺便说一下,我将我的代码发给您供参考)

我还尝试了概率神经网络(PNN),它只产生了 78% 的准确率,很低,而且无法增加 PNN 的层数,因为它是一个单层网络(来自 Neupy)。

现在我转向 RNN,但你这么说了。

不,鸢尾花数据集不是一个序列分类问题,LSTM 会很不合适。

@Jason,

您有什么建议吗?我需要您的专家意见。

我尝试了 sklearn 中的 RBM,但它不起作用。

你说 RNN 不会奏效。

我认为 CNN 显然也不适合。

还剩下 DBN 和 VAE 吗?

我希望以三种不同的方式对 IRIS 进行分类。我只做了一种。

考虑 SVM、CART 和 kNN。

@Jason,

谢谢你。我已经尝试了 kNN 和 SVM。它们都表现良好,取得了不错的结果。

我感觉深度学习方法能为我的数据集带来更好的结果。您在深度学习方面还有其他建议吗?这是我的数据集

https://www.dropbox.com/s/4xsshq7nnlhd31h/P7_all_Data.csv?dl=0

你可以尝试多层感知机神经网络。

Jason,

我确实尝试了多层感知机。结果很好。

我想使用超过 3 层的深度神经网络。

你认为卷积神经网络怎么样?

我最初认为这不可能。但是,现在我又重新考虑了。

你想怎么做都可以。CNN 是为空间输入设计的,而鸢尾花数据集没有空间输入。

你好 Jason,我想问一下 Dropout 的用途是什么,它会降低准确率,这是否意味着 Dropout 对机器学习不利?谢谢!

Dropout 可以在某些问题上提高模型的性能。

请参阅这篇关于 dropout 的文章

https://machinelearning.org.cn/dropout-regularization-deep-learning-models-keras/

嘿 Jason!很棒的帖子 :) 真的帮助我度过了这个夏天的实习期。我只想听听您对几件事的看法。

1. 我总共训练了大约 40 万份文档,准确率达到了 98% 左右。当我的模型表现“太好”时,我总是很警惕。这是否是由于庞大数据集造成的合理因果关系?

2. 当我想到 CNN + 最大池化词向量 (Glove) 时,我认为这个操作基本上是将 3 个词的词向量混合在一起(可能形成短语表示)。我的思考过程正确吗?

3. 我仍然不太清楚 LSTM 学习了什么。我知道它不是一个典型的 seq-2-seq 问题,那么那 100 个 LSTM 单元包含什么?

再次非常感谢您的精彩教程! :)

很高兴听到这个消息,Daniel。

也许您想在保留集上测试模型,以查看模型技能是真实的还是过拟合的。

差不多就是这样,池化会做一些很好的非线性事情,这些事情可能无法干净地与词向量/词语关联起来。

它们包含输入和输入序列中先前项的函数。这肯定很复杂。

你好 Jason,

我想知道 LSTM 层中的 100 个神经元如何能够接受 500 个向量/词?我以为 LSTM 层的大小应该与输入序列的长度相等!

好问题,不,层不需要具有相同数量的单元。

例如,如果我有一个长度为 5 的向量作为单个神经元的输入,那么该神经元将有 5 个权重,每个元素一个。我们不需要 5 个神经元来处理 5 个输入元素(尽管我们可以),这些考虑是分开且解耦的。

谢谢你的回复。

但在这里,我们已经将每个输入都视为一个向量而不是一个标量!这是否意味着在这种情况下,每个神经元将接收 5 个向量,每个向量都是 32 维的?那么每个神经元将有 5*32=160 个权重?如果是这样,这相对于让每个神经元只处理一个词/向量有什么优势?

对于 MLP,词向量如您所说地连接起来,每个神经元都会接收大量输入。

另一方面,LSTM 将每个词作为序列中的一个输入,并逐个处理它们。

这个想法被称为“分布式表示”,其中所有神经元接收所有输入,并且它们有选择地学习关注不同的部分。

这是神经网络的关键。

嗨,Jason,

假设我们有 500 个序列,每个序列包含 100 个元素。

如果我们将它嵌入到 32 维向量中,每个序列将得到一个 100*32 的矩阵。

现在假设我们的项目中只使用一个 LSTM 层(20)。我有点困惑在实践中。

我知道我们有一个隐藏层,其中有 20 个 LSTM 单元并行。我想知道 Keras 如何将序列提供给模型。它是否一次将相同的 32 维向量按顺序提供给所有 LSTM 单元,并且一次迭代在时间 [t+100] 结束?(这种方式我认为所有单元在训练后都会给出相同(复制)的值,并且这相当于只有一个单元),或者它是否将 32 维向量 20 个 20 个地按顺序提供给模型,并且迭代在时间 [t+5] 结束?

在此先感谢,

Sajad

好问题。

所以,这 100 个时间步作为输入传递给模型,包含 500 个样本和 1 个特征,类似 [500, 100, 1]。

嵌入层会将每个时间步转换为一个 32 维向量。

LSTM 将一次处理一个时间步的序列,即一次处理一个 32 维嵌入。

每个记忆单元都将获得完整的输入。它们都尝试对问题进行建模。从更深层传播的错误会促使隐藏的 LSTM 层以特定方式学习输入序列,例如对序列进行分类。每个单元将学习略有不同的东西。

这有帮助吗?

感谢您清晰的回答。

1) 我正在使用 LSTM 进行恶意软件检测,所以我有一系列恶意软件活动。另外,我想了解更多关于 Keras 中的 Embedding 层。在我的项目中,我需要将元素转换为整数数字以馈送 Keras 的 Embedding 层。我猜 Embedding 是一个冻结的神经网络层,以一种能体现不同元素之间有意义关系的方式,将序列的元素转换为向量,对吗?我想知道在我的项目中使用 Embedding 是否存在任何逻辑问题。

2) 你知道关于 Keras 中 Embedding 的任何参考资料(书籍、论文、网站等)(学术/非学术)吗?我需要绘制一个图来描述 Embedding 训练网络。

感谢您的耐心等待,

Sajad

Embedding 在模型拟合时会学习权重。

如果你愿意,可以使用 word2vec 或 glove 运行的预训练权重。为你的任务学习自定义权重通常会更好。

我计划下个月发布几篇关于学习到的嵌入层如何工作的文章。目前,这可能是一个很好的起点:

https://en.wikipedia.org/wiki/Word_embedding

Keras Embedding 层仅仅是权重——为输入词汇表中的每个词学习到的向量。非常简单明了。

谢谢你,Jason。

太棒了,我正在等待你关于嵌入的文章。

谢谢 Sajad。

嘿 Jason,这篇文章对我很有帮助。

我有一个问题,我想知道如何设置隐藏层中 LSTM 单元的数量?

样本数量(序列)和隐藏单元数量之间是否存在任何关系?

我有 400 个序列,每个序列包含 5000 个元素。我应该使用多少个 LSTM 单元?我知道我应该用不同数量的隐藏单元来测试模型,但我正在寻找隐藏单元数量的上限和下限。

Saho,

没有分析方法可以配置神经网络。我建议试错法、网格搜索、随机搜索或复制其他模型的配置。

干得好!如果我想将此代码应用于简单句子序列分类,该怎么做?我们该如何处理数据?

.

谢谢你

当然可以。

我建议花时间清理数据,然后将其整数编码以供模型使用。我建议在模型前端使用一个嵌入层。

谢谢……我如何用我自己的由简单句子组成的数据替换 IMDB 数据?我该如何相应地修改程序?

加载文本数据,清理文本数据,然后将您的词语编码为整数。

可以从 Keras Tokenizer 开始了解。

https://keras.org.cn/preprocessing/text/#tokenizer

嗨,Jason!首先感谢您精彩的网站!

现在问题来了:在我的案例中,我正在尝试解决一个任务分类问题。每个任务都由 57 条时间序列描述,每条时间序列有 74 个时间步。在训练阶段,我有 10 个不同类别的 100 个任务示例。

这样,我创建了一个 [100,74,57] 的输入和一个 [100,1] 的输出,其中包含每个任务的标签。

也就是说,我有一个多元时间序列到多标签分类的问题。

您会建议哪种学习结构?我意识到我可能需要收集/生成更多数据,但我对 Python 和深度学习都是新手,在为多元时间序列 -> 多标签分类创建小型运行示例时遇到了一些麻烦。

谢谢!

对于多类别分类,您需要对输出变量进行独热编码,以便维度为 [100,10],然后在输出层使用 softmax 激活函数来预测所有 10 个类别的输出概率。

对于具体的模型,可以尝试带滑动窗口的 MLPs,然后可能是一些 RNNs,比如 LSTMs,看看它们是否能表现更好。

感谢您的教程。我的问题是分类一个数据包(每次都捕获许多特征)是正常还是异常。我想将 LSTM 应用于我自己的问题。我的数据是矩阵:X_train(4000,41),Y_train(4000,1),X_test(1000,41),Y_test(1000,1) – Y 是标签。41 个特征中的一个时间特征,其他是输入变量。我认为,我必须从 41 个特征中提取时间特征,这正确吗?Keras 中有这个过程吗?

首先,我困惑如何以有意义的方式重塑数据,使其满足 LSTM 层输入的各项要求。我期望我的数据如下:

x_train.shape = (4000,1,41) #简单起见,我将时间步长设置为1,稍后会将其更改为 > 1,以便在时间步长内对多个数据包进行分类

y_train.shape = (4000,1,1)

如何将我的数据转换为上述结构?

其次,我认为 Embedding 层不适合我的问题,对吗?我的模型是这样构建的:

model = Sequential()

model.add(LSTM(64, input_dim=41, input_length=41)) # 例如,64 个 LSTM 单元

model.add(Dense(1, activation=’sigmoid’))

model.compile(loss=’binary_crossentropy’, optimizer=’adam’, metrics=[‘accuracy’])

model.fit(X_train, Y_train, epochs=20, batch_size=100)

我是 LSTM 新手,您能为我的问题提供一些建议吗?非常感谢!

听起来您有 40K 个时间步,这些时间步需要被分成 100 个样本,每个样本包含 400 个时间步的子序列。

那么您的输入将是:[100, 400, 41]。

输入形状将是 (400, 41)。

这有帮助吗?

谢谢 Jason。这意味着 batch_size=100。对吗?我可以这样设置我的第一层:

model.add(LSTM(64, input_dim=41, input_length=400)) #隐藏层1:64

或

model.add(LSTM(64, batch_input_shape=(100, 1, 41), stateful=True))

哪个是正确的?如何在第一行代码中设置 time_step。

你能帮我解决这个问题吗?非常感谢

您可以这样设置数据的时间步 (x) 和特征 (y) 的形状:

input_shape=(x, y)

感谢您的热情,

我尝试按照您的评论使用我的数据构建模型,但我遇到了错误

timesteps=2

train_x=np.array([train_x[i:i+timesteps] for i in range(len(train_x)-timesteps)]) #train_x.shape=(119998, 2, 41)

train_y=np.array([train_y[i:i+timesteps] for i in range(len(train_y)-timesteps)]) #train_y.shape=(119998, 2, 1)

input_dim=41 #特征

#1.定义网络

model=Sequential()

model.add(LSTM(100,input_shape=(timesteps,input_dim)))

model.add(Dense(1,activation=’sigmoid’))

#2.编译网络

model.compile(loss=’binary_crossentropy’,optimizer=’adam’,metrics=[‘accuracy’])

#3.拟合模型

model.fit(train_x,train_y, epochs=100, batch_size=10,)

错误

文件“test_data.py”,第53行,位于

model.fit(train_x,train_y, nb_epoch=100, batch_size=10,)

文件“/home/keras/models.py”,第870行,位于fit

initial_epoch=initial_epoch)

文件“/home/keras/engine/training.py”,第1435行,位于fit

batch_size=batch_size)

文件“/home/keras/engine/training.py”,第1315行,位于_standardize_user_data

exception_prefix=’target’)

文件“/home/engine/training.py”,第127行,位于_standardize_input_data

str(array.shape))

ValueError:检查目标时出错:dense_1 预期有 2 个维度,但得到形状为 (119998, 2, 1) 的数组

可能我的输出形状有问题?我该如何修复?

谢谢你

您的网络输出需要 1 个特征。将 y 重塑为 (119998, 1)。

嗨,Jason,

我将我的输出形状替换为

train_y=np.array(train_y[:119998]) #train_y.shape=(119998, 1)

终于成功了!

我还有个问题,Keras 支持在 GPU 上实现吗?

谢谢

很高兴听到。

Keras 运行在 Theano 和 TensorFlow 之上。这些底层数学库提供了对 GPU 的支持。

你好,Jason。

我认为我准备 LSTM 输入数据时可能错了。

我的输入和标签如下:train_x(4000,41) 和 train_y(4000,1)

之前,我用了

timesteps=2

train_x=np.array([train_x[i:i+timesteps] for i in range(len(train_x)-timesteps)]) #train_x.shape=(119998, 2, 41)

train_y=np.array(train_y[:119998]) #train_y.shape=(119998, 1)

===> 这是错误的,因为行是重叠的,并且 train_y 可能被错误地取了。

现在,我这样纠正了

train_x = reshape(int(train_x.shape[0]/timesteps), timesteps, train_x.shape[1])

在我的数据中,每个实例都有多个特征,所以我想保持特征不变,这意味着在同一时间有多个特征。

请帮我纠正我对输入数据的误解。

train_y = reshape(int(train_y.shape[0]/timesteps), train_y.shape[1]) # 错误:IndexError: tuple index out of range ???

我还在考虑时间特征是否包含在输入数据中(因为我读过一篇文章:https://machinelearning.org.cn/time-series-prediction-lstm-recurrent-neural-networks-python-keras/)。

我读了您在 machinelearningmastery.com 上的许多文章,所以我可能有些困惑。

非常感谢

抱歉,我不太明白您的序列预测问题。

您能给我一个简单的例子吗,比如一个样本?

我的数据有 n 个数据包,每个数据包有 f 个特征(其中一个特征是时间),例如:

f1 f2 f3 … 标签

pkt1 2 3 3 0

pkt2 1 3 5 1

pkt3 2 3 2 1

pkt4 5 3 1 0

pkt5 5 3 2 1

....

例如:timesteps=2,每个子序列有2行。形状调整后,像这样:

[[[2 3 3 0]

[3 5 1 1]]

[[3 5 1 1]

[2 3 2 1]]

…. ]

或者:分离

[[[2 3 3 0]

[3 5 1 1]]

[[2 3 2 1]

[5 3 1 0]]

… ]

当从该输入数据中分离标签时,我看到如果 timesteps=1,标签将与每一行匹配,很容易获取。但是如果 timesteps > 1,哪个标签将被用于匹配每个子序列(在第一行还是第二行)?

您能帮我澄清这个困惑吗?(2个问题:重叠还是分离?以及如何获取标签)

非常感谢

也许这篇文章会帮助您准备数据。

https://machinelearning.org.cn/convert-time-series-supervised-learning-problem-python/

谢谢 Jason。

我知道那篇文章。这意味着为预测模型和分类模型准备数据是一样的吗?

该方法将有助于一般地准备序列数据,而不仅仅是时间序列。

嗨 Jason

在仔细考虑了 Keras 中 LSTM 的数据准备后,我意识到“特征”一词并不意味着其原始含义(也称为数据集中的属性、字段),实际上它是将多变量时间序列转换为监督学习数据后列的数量。它是基于真实特征和 look_back 计算的,计算方式是真实特征乘以 look_back。我说的对吗?

我遵循了 https://machinelearning.org.cn/multivariate-time-series-forecasting-lstms-keras/

.

谢谢 Jason 和 machinelearningmastery.com

在时间序列中,并行序列将是“特征”,一个序列的滞后观测值将是 LSTM 的时间步长。

嗨 Jason,不错的文章。我有一个问题。进行多类别分类而不是二元分类,我需要做哪些更改?

好问题。

更改输出层,使其每个类别有一个神经元,将输出层的激活函数更改为 softmax,并将损失函数更改为 categorical_crossentropy。

感谢您的精彩回复。最后一个问题,我可以使用负值进行 LSTM 和 CNN 吗?我有一些数据,其中一列既有正值也有负值。如何处理这种情况?提前感谢。

是的。

通常,我建议您在将数据传递给 LSTM 层之前将其重新缩放到 0-1 的范围。

嗨,Jason,

我似乎在使用“model.add(LSTM(100))”这一行时遇到了问题(操作系统:MAC)

TypeError 是:预期 int32,却得到了类型为 'Variable' 的变量。

非常感谢!!!!!!!

这是一个奇怪的错误,你确定是在那一行吗?它没有道理。

也许请确保你已经复制了所有行并且间距/缩进正确?

嗨,Jason,感谢您的帖子。它真的很有帮助。

我有一些问题,希望您能帮忙。

1. 我正在尝试对一个包含用户评论的数据集进行意图分类。评论对应着几种意图。但是我的语言不是英语。所以我明白我必须将数据集构建成类似于 IMDb 的。但我该怎么做?您是否有任何关于如何构建此类数据集的说明/指南?

2. 除了数据集,我想我还必须为我自己的语言构建嵌入向量。我该怎么做?

提前感谢。希望很快能收到您的回复。

我应该很快会发布一些关于这个主题的文章。

通常,你需要清理数据(标点符号、大小写、词汇表),然后将其整数编码以用于词嵌入。Keras 的 Tokenizer 类是一个很好的起点。

Embedding 层将学习您的数据的权重。您可以尝试训练一个 word2vec 模型并使用预训练的权重以获得更好的性能,但我建议首先使用学习到的嵌入层作为第一步。

您好,Jason,

感谢您的出色帖子。

谷歌有其 NLP API:https://cloud.google.com/natural-language/docs/basics

您可以承认他们给我们情感极性范围是 (-1, 1)。他们称之为“分数”。

您可能对如何在情感分析中使用 Keras 实现相同的输出有快速的想法吗?

据我所知,这不再是一个分类器问题。有什么想法吗?

当然,我安排了一些关于这个主题的帖子,将在本月晚些时候/下个月发布。

哎呀,我把回复发错帖子了。抱歉。我已经更正了。

嗨,Jason,

感谢您在这个网站上的出色工作。

我的问题是:在什么情况下 RNN 比 LSTM 效果更好?我知道 LSTM 源于 RNN,并试图消除 RNN 中梯度消失的问题。但是,在我的案例中,我使用的是恶意软件行为序列,我得到了这个 TPR 和 FPR 图表:https://imgur.com/fnYxGwK,图表显示了隐藏层中不同单元数量的 TPR 和 FPR。

你知道为什么 RNN 在我的项目中效果更好吗?

LSTM 是一种 RNN。

嗨,Jason,

首先,很棒的教程。喜欢您提供的所有内容。

我正在处理一个分类任务,涉及评估一个可能长达 27500 个单词的特征。我的问题是,我还需要将其他特征输入到我的 RNN-LSTM 中。我曾想过将长文本特征和其他特征合并到一个文件中——当然特征之间用列分隔,但我不认为这会奏效?相反,我正在考虑将长文本特征分离到一个单独的文件中,并独立地通过 RNN 运行它,然后再获取其他特征。您能给我一些关于如何设计应对我面临的这个挑战的层的指导吗?

您需要将序列分成最多 200-400 个时间步的子序列。

我在这里提供了一些想法

https://machinelearning.org.cn/handle-long-sequences-long-short-term-memory-recurrent-neural-networks/

您好,Jason Brownlee 博士。感谢您精彩的网站。我是一名深度学习初学者。我复制了您的代码并运行它,在加载 imdb 数据集时遇到了问题。消息如下:

回溯(最近一次调用)

文件“F:\Study\0-MyProject\Test\SimpleLSTM.py”,第 13 行,位于

(X_train, y_train),(X_test, y_test) = imdb.load_data(num_words = top_words)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\site-packages\keras\datasets\imdb.py”,第 51 行,位于 load_data

path = get_file(path, origin=’https://s3.amazonaws.com/text-datasets/imdb.npz’)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\site-packages\keras\utils\data_utils.py”,第 220 行,位于 get_file

urlretrieve(origin, fpath, dl_progress)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\urllib\request.py”,第 217 行,位于 urlretrieve

block = fp.read(bs)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\http\client.py”,第 448 行,位于 read

n = self.readinto(b)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\http\client.py”,第 488 行,位于 readinto

n = self.fp.readinto(b)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\socket.py”,第 575 行,位于 readinto

return self._sock.recv_into(b)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\ssl.py”,第 929 行,位于 recv_into

return self.read(nbytes, buffer)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\ssl.py”,第 791 行,位于 read

return self._sslobj.read(len, buffer)

文件“C:\Users\llfor\AppData\Local\Programs\Python\Python35\lib\ssl.py”,第 575 行,位于 read

v = self._sslobj.read(len, buffer)

TimeoutError: [WinError 10060] 由于连接方在一段时间后没有正确答复或连接的主机没有反应,连接尝试失败。

此外,有时它只是说“在 https://s3.amazonaws.com/text-datasets/imdb.npz 上获取失败”。

是因为 imdb 数据源不可用还是网络不稳定?

实际上,我已经从 https://s3.amazonaws.com/text-datasets/imdb.npz 手动下载了数据。

那么如果我无法在线加载数据,我如何处理我手动下载的数据以使用它呢?

我尝试了另一段代码来加载数据:(X_train, y_train),(X_test, y_test) = imdb.load_data(path = “imdb_full.pkl”),但也没有奏效。

期待您的回复。再次感谢!

看起来您可能遇到了互联网连接问题。

请尝试删除 ~/.keras/datasets/ 中未完全下载的文件(如果存在)并重试。

谢谢您的回复。现在我可以加载数据集了。我还有两个问题需要您的帮助

(1)您提到我们可以通过使用代码“numpy.random.seed(7)”来“重现结果”,但我每次仍然得到不同的准确度。我对代码“numpy.random.seed(7)”的理解是否正确?

(2)我得到的结果总是大约50.6%,低于您的。为什么差距这么大?

谢谢您,期待您的回复~

也许这篇博文会有助于重现性

https://machinelearning.org.cn/reproducible-results-neural-networks-keras/

很遗憾听到这个消息,通常神经网络是随机的,评估它们的最佳方法是这个过程

https://machinelearning.org.cn/evaluate-skill-deep-learning-models/

嗨,Jason,

这是一篇很棒的帖子。我是神经网络的新手,现在我有一个问题。

我不明白你为什么要为这种语义分析选择LSTM和RNN。明确地说,我不明白哪里有允许我们使用RNN和LSTM的序列部分。

我想知道你是否能解释一下。

我还想知道我们是否可以将LSTM用于实体提取(NLP),以及哪里有好的数据集来训练我们的模型。

当然,请查看这篇关于序列预测的帖子

https://machinelearning.org.cn/sequence-prediction/

还可以看看这篇关于RNN前景的帖子

https://machinelearning.org.cn/promise-recurrent-neural-networks-time-series-forecasting/

我确信LSTMs可以用于实体提取,我没有示例。我的建议是搜索谷歌学术。

嗨,Jason,

在这种情况下特征缩放也会有帮助吗?由于评论被分词,值可能会根据使用的最大词数从低到高变化。

当然可以。

感谢分享模型和代码,以及您热情地回答所有问题。我根据您的cnn+lstm模型构建了我的句子分类模型,它运行良好。我是神经网络的新手,因此我正在努力学习如何解释不同层如何交互,特别是数据形状是什么样的。因此,根据上面的例子,假设我们的数据集有1000条电影评论,使用批大小为64,对于每个批次,请纠正我

嵌入层:输出 – 64(样本大小)x 500(词)x 32(每个词的特征)

conv1d:输入 – 同上;输出 – 对于*每个词*,32个特征图 x (32/3)个特征,其中3是核大小。

maxpooling1d:输入 – 同上;输出 – 对于*每个词*,以及对于*每个特征图*,一个32/3/2特征向量

lstm:输入 – 这是我难以理解的地方… 64是样本大小,500是步长,所以应该是64 x 500 x FEATURES,但是FEATURES=32/3/2,还是32 x (32/3/2),其中第一个32是来自conv1d的特征图?

输出 – 对于*每个样本*,一个100维特征向量

听起来不错。

我鼓励您在您的问题上尝试一系列模型,看看哪个效果最好。

您好,阅读您的博客后觉得非常有帮助,不过您能否指导我一个代码示例,说明如何精确地对文本进行one-hot编码以进行训练,我有20,000条评论需要训练。

或者我可以直接使用哈希技术,其中每个词都表示一个整数吗?

所以就像;

我觉得这家店不错。

我觉得不错。

表示为;

1 2 3 4 5

1 2 5

因为用整数表示每个字符会非常耗时!

然后我就可以继续进行填充等步骤了?

在这种情况下,我将如何预测包含一些新词的新句子?

(这让我重新思考是否应该将每个字符分配给一个整数)如果是这样,您能给我一个示例吗?

我建议对文本使用整数编码。

此外,您可以计算每个单词的出现次数,并将词汇量大小减少到只包含最常用的单词。

我很快会在博客上发布关于如何做到这一点的文章。

我尝试使用 Keras 在 seq2seq 中创建文本摘要模型。效果不佳。预测结果显示的是按频率排列的顶部词汇。我尝试将英文中的常用词('a', 'an', 'the' 等)列入黑名单。结果仍然不理想。有人说 2016 年 Keras 不适合文本摘要。想知道缺少了什么。

这是一个难题,至少需要100万个示例和一个大型模型。

我有一个关于文本摘要的教程,计划在圣诞节前后发布。

您好,我是Asad。我想知道如何加载一个.text文件中的电影评论文本数据集,然后如何在循环神经网络中使用它?

请告诉我完整的步骤。请记住,数据在我本地电脑上。

这篇帖子将向您展示如何编码文本以用于LSTM

https://machinelearning.org.cn/prepare-text-data-deep-learning-keras/

嗨,Jason,

谢谢这篇帖子。我刚将此方法应用于我们的用例,这与电影评论情感分类非常相似。模型的准确率非常高,约为94%。

但是

我将所有频率替换为随机数,令我惊讶的是,准确率仍然非常高。(~94)。标签也相同。

您对此有什么想法吗?

谢谢,

您到底是什么意思?我没明白您改变了什么。

嗨,Jason,

惊人的工作,而且非常及时。

我想问您,您认为这个序列分类模型可以用来预测一个非常长的数字序列的类别吗,而不是单词??

是的。不过,对于非常长的序列(>400个时间步),您可能需要将它们分成子序列以适应您的模型。

请看这篇文章

https://machinelearning.org.cn/handle-long-sequences-long-short-term-memory-recurrent-neural-networks/

多谢,我会试一试的!

嗨,Jason,

我真的很困惑。我似乎是唯一一个无法运行您提供的代码的人。

我使用的是python 2.7,Keras-2.0.8,Tensorflow-0.12。我在以下行遇到了错误

model.add(LSTM(100))。

TypeError: 预期int32,但得到包含类型为’_Message’的张量的列表。

您能告诉我您使用的python、keras、tensorflow版本吗?

谢谢!

看来您需要将您的 TensorFlow 版本升级到至少 1.3 或更高版本。

你好 jason,

我想告诉您,我按照您的逐步机器学习项目编写了我的第一个机器学习代码。我正在使用一个非线性数据集(nsl-kdd)。我的数据集是CSV格式。我想使用LSTM对我的数据集进行建模和训练。

对于MNIST数据集,我有一个代码,

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

from tensorflow.python.ops import rnn, rnn_cell

mnist = input_data.read_data_sets(“/tmp/data/”, one_hot = True)

hm_epochs = 3

n_classes = 10

batch_size = 128

chunk_size = 28

n_chunks = 28

rnn_size = 128

我的问题是,根据我的数据集,如何为我的数据集定义块大小、块数和rnn大小作为新变量。

因为我是新手,所以真的不知道如何使用lstm对我的数据集进行建模和训练以找到准确性。我想使用LSTM作为分类器。我不知道我对您的问题是否正确。

我非常感谢您的帮助。

抱歉,我没有直接使用 TensorFlow 的示例。我无法给您好的建议。

是否可以将相同的代码用于简单的神经网络进行文本处理?

使用 Keras 进行文本处理是最佳方式吗?或者还有其他库可以实现用于文本处理的神经网络?

是的,也许可以从这篇帖子开始准备您的文本数据

https://machinelearning.org.cn/prepare-text-data-deep-learning-keras/

嗨,Jason,

这篇帖子和评论对我帮助巨大。谢谢!我有一个关于这句话的问题 –

“IMDB评论数据在评论词序中确实具有一维空间结构,CNN可能能够识别出良好和不良情感的不变特征。然后,这些学习到的空间特征可以通过LSTM层作为序列学习。”

我无法想象CNN将如何处理单词。另外,您能解释一下单词的空间结构吗?

单词在句子或段落中是有序的,这就是空间结构。

对于序列到序列挖掘,哪种神经网络性能更好?

LSTMs。

我读过关于神经网络中的序列到序列学习,我们需要LSTMS层,第一个用于输入序列,第二个用于输出序列,在这里我们必须将输入序列向量以相反的顺序发送到LSTM层。

我的疑问是,LSTM层会以相反的顺序接收输入,还是我们必须以相反的顺序提供输入?

是的,您可以通过 LSTM 层的 `go_backwards` 参数反转顺序。

https://keras.org.cn/layers/recurrent/#lstm

对于序列到序列回归模型,输出节点我应该给一个还是应该给出最大可变长度的输出向量?

最终我们将得到输出向量,我们如何将这些输出向量转换为文本,Keras中是否有任何方法,就像在嵌入层中我们进行字符串到向量的转换,类似向量到整数的转换。

要输出文本,您可以使用 softmax 输出每个字符或单词的概率,然后取 argmax 得到一个整数,并将该整数映射回您词汇表中的值。

我很快会在博客上发布关于如何做到这一点的示例。

问题陈述:我的模型应该根据使用Keras的序列到序列建模,根据给定指令生成脚本文件。

示例:输入:从控制台获取两个整数,将两个整数相加,在控制台上打印两个整数的和。

输出:类似于上述输入指令的Python脚本文件。

请给我解决这个问题的任何联系点,我如何进一步解决这个问题。

这里有一个例子

https://machinelearning.org.cn/learn-add-numbers-seq2seq-recurrent-neural-networks/

是否可以使用机器学习将自然语言翻译成编程语言,例如C、PHP或Python?请推荐我任何可用于完成此任务的库。

也许可以。

你可以考虑使用LSTM作为文本生成器进行序列到序列学习。从这里开始

https://machinelearning.org.cn/start-here/#lstm

Brownlee博士,我无法表达我对您网站内容的珍视!如此易懂,切中要害,且富有启发。您正在改变世界。谢谢您。

谢谢 Tamir!

很棒的教程!

但是如何使用这个网络来分类几个不同的类别呢?例如14个类别。

我理解是否正确——我只需要将 model.add(Dense(1, activation='sigmoid'))

改为 model.add(Dense(13, activation='sigmoid'))

还是需要使用 Conv2D?

以及如何将我的文本数据转换为词嵌入(如IMDB所用)?

要将示例更改为适用于多类别分类问题,请将输出层更改为每个类别一个神经元,并使用 categorical_crossentropy 损失函数。

感谢您精彩的示例!

我在模型过拟合方面遇到了一些麻烦 –

在训练中,我使用的是俄语文本数据(语言本身并不重要,因为文本包含大量特殊专业术语,很遗憾无法使用现有的word2vec)。

我的训练数据参数如下:文章最大长度 – 969个词;词汇量大小 – 53886;标签数量 – 12(不幸的是,它们分布很不均匀,例如,第一个标签有大约5000个示例,而第二个标签只有1500个示例)。

训练数据集数量 – 仅9876条。这是最大的问题,因为遗憾的是我无法以任何方式增加训练集的大小(唯一的办法是再等一年☻,但即使这样也只能使训练数据量翻倍,而即使翻倍也不够)。

这是我的代码 –

x, x_test, y, y_test = train_test_split(x_, y_, test_size=0.1)

x_train, x_dev, y_train, y_dev = train_test_split(x, y, test_size=0.1)

embedding_vecor_length = 100

model = Sequential()

model.add(Embedding(top_words, embedding_vecor_length, input_length=max_review_length))

model.add(Conv1D(filters=32, kernel_size=3, padding='same', activation='relu'))

model.add(MaxPooling1D(pool_size=2))

model.add(keras.layers.Dropout(0.3))

model.add(Conv1D(filters=32, kernel_size=4, padding='same', activation='relu'))

model.add(MaxPooling1D(pool_size=2))

model.add(keras.layers.Dropout(0.3))

model.add(Conv1D(filters=32, kernel_size=5, padding='same', activation='relu'))

model.add(MaxPooling1D(pool_size=2))

model.add(keras.layers.Dropout(0.3))

model.add(Conv1D(filters=32, kernel_size=7, padding='same', activation='relu'))

model.add(MaxPooling1D(pool_size=2))

model.add(keras.layers.Dropout(0.3))

model.add(Conv1D(filters=32, kernel_size=9, padding='same', activation='relu'))

model.add(MaxPooling1D(pool_size=2))

model.add(keras.layers.Dropout(0.3))

model.add(Conv1D(filters=32, kernel_size=12, padding='same', activation='relu'))

model.add(MaxPooling1D(pool_size=2))

model.add(keras.layers.Dropout(0.3))

model.add(Conv1D(filters=32, kernel_size=15, padding='same', activation='relu'))

model.add(MaxPooling1D(pool_size=2))

model.add(keras.layers.Dropout(0.3))

model.add(LSTM(200,dropout=0.3, recurrent_dropout=0.3))

model.add(Dense(labels_count, activation='softmax'))

model.compile(loss=’categorical_crossentropy’, optimizer=’adam’, metrics=[‘accuracy’])

打印(model.summary())

model.fit(x_train, y_train, epochs=25, batch_size=30)

scores = model.evaluate(x_, y_)

我尝试了不同的参数,训练准确率非常高(高达98%),但在测试集上表现很差。我最多只能达到约74%,通常结果约为64%。最好的结果是在小的 embedding_vecor_length 和小的 batch_size 下实现的。

我知道我的测试集只占训练集的10%,而且总数据集是最大的问题,但我想找到解决这个问题的方法。

所以我的问题是 – 1) 这个模型是否正确地用于文本分类?(它有效)我需要同时进行卷积并合并结果吗?我只是不明白在具有不同滤波器大小的卷积过程中(如我的示例中)文本信息是如何不丢失的。您能解释一下卷积如何处理文本数据吗?主要有关于图像识别的文章……

2) 我显然遇到了模型过拟合的问题。如何提高性能?我已经添加了Dropout层。接下来我能做什么?

3) 也许我需要一些不同的东西?我的意思是纯粹的RNN而不是卷积?

也许可以尝试使用交叉验证来获得更可靠的模型技能估计。

或许可以探索更简单的基于CNN的方法,这是一个好的开始

https://machinelearning.org.cn/develop-word-embedding-model-predicting-movie-review-sentiment/

或许可以探索通用的深度学习调优方法

https://machinelearning.org.cn/improve-deep-learning-performance/

希望这些能作为一个开始有所帮助。

如果没有涉及词汇,您将如何进行序列分类?例如,我想将一个看起来像 [0, 0, 0.4, 0.5, 0.9, 0, 0.4] 的序列分类为0或1,但我不知道我的数据应该采用什么格式才能馈入LSTM。

也许可以从这里开始,Alex

https://machinelearning.org.cn/start-here/#lstm

你好,

如果我们想对数字序列进行分类,这个例子是否适用?我需要嵌入层吗?您能推荐一个您在博客或其他地方的例子,以便我能更深入地理解吗?谢谢。

不需要嵌入层。

您好。

不错的教程,伙计。你能展示一下如何将这个LSTM网络用于二元分类问题吗(就像你关于神经网络的教程——印度原住民糖尿病)。

请您帮帮我……

它不适合该数据集,因为没有序列信息。

您可以从这里开始学习 LSTMs

https://machinelearning.org.cn/start-here/#lstm

谢谢 Jason

你好,

我尝试了序列分类,但无法在嵌入层之上添加LSTM层。

您是否遇到过类似的问题?

这是我遇到的问题:https://stackoverflow.com/questions/47464256/unable-to-add-lstm-layer-on-top-of-embedded-layer-on-gpu-keras-with-tensorflow

这是使用函数式API的示例

取自这里

https://machinelearning.org.cn/develop-a-caption-generation-model-in-keras/

嗨,Jason,

感谢您的教程。但是,当您说

“我们可以看到,我们取得了与第一个示例相似的结果,尽管权重更少,训练时间更快。”

当您说权重更少时,您具体指的是什么?因为当您运行model.summary时,带有卷积层的模型有21.6万个参数,而原始模型有21.3万个参数,从技术上讲,有更多的参数需要训练。

您是不是说,使用卷积+池化层,LTSM层的输入来自250个隐藏层节点,而原始模型是500个?我猜LTSM层更难训练,从而导致拟合时间减少?

谢谢

嗨

我尝试了文本分类。我有一组推文数据集,我必须训练一个模型来判断作者是开心还是难过。我使用了您的“简单LSTM序列分类”代码。但我想要知道在使用您的代码之前,我应该用什么来替换单词。

以前我使用“sequences = tokenizer.texts_to_sequences(tweets_dict["train"])”将文本转换为向量,之后我使用了您的代码。这样做正确吗?

请看这个例子

https://machinelearning.org.cn/develop-word-embedding-model-predicting-movie-review-sentiment/

真正信息丰富且内容结构精巧,

现在它非常用户友好(:。

谢谢!

如果您允许我引用您的几篇文章,只要我提供

出处和来源链接到您的网站,您介意吗?我的博客网站与您的网站属于同一兴趣领域,我的用户将真正受益于

您在此处提供的大量信息。

请告诉我这是否可以。非常感谢!

当然,只要您不逐字复制帖子(例如,只复制少量引用)并清楚注明来源即可。

非常好的文章。您能告诉我如何进行单个预测吗?例如,对于给定的文本,我们必须进行预测。

例如,“Very nice movie”作为单个输入,输出“positive”。

是的,请看这篇文章

https://machinelearning.org.cn/make-predictions-long-short-term-memory-models-keras/

嗨,Jason,

在我的问题中,我对每个样本(10000个样本)进行了大小为256的独热编码。嵌入层是必要的吗?我做的第一层是

model.add(LSTM(256, input_shape=(10000, 256), activation = ‘relu’))

您也使用了model.add(LSTM(100))。它与embedding_vecor_length有任何关系吗?它必须大于embedding_vecor_length = 32吗?我正在使用256,但没有任何想法。谢谢。

或许可以尝试有嵌入和无嵌入的模型,看看它如何影响模型性能。

先生,感谢您提供如此精彩的教程。我正在进行序列分类。我的数据集包含41个特征,每个特征都是浮点数,Y是5个类别。

问题1:我需要嵌入吗?

问题2:我已经对数据进行了归一化,那么我需要top_words吗?

问题3:嵌入向量长度可能是多少?

问题4:最大评论长度可能是多少?

问题5:所有示例都包含41个特征,我需要填充吗?

我对嵌入层不是很清楚。您的建议对我来说将非常有用。

一个评论里问题太多了!

一般来说,我无法告诉您哪种方法最适合您的问题,您必须通过实验来发现最有效的方法。请参阅此帖子

https://machinelearning.org.cn/applied-machine-learning-as-a-search-problem/

你好,suman,我遇到了和你一样的情况

我的数据集有8个特征和100,000个观测值,我必须将这些序列数据分类

到4个不同的类别。

但我对嵌入的“向量长度”、“最大评论长度”等一无所知。

如果你解决了你的问题,你能告诉我你是怎么解决的吗?

任何评论或建议都将不胜感激。

以下是一些处理超长序列的方法

https://machinelearning.org.cn/handle-long-sequences-long-short-term-memory-recurrent-neural-networks/

我有一个小疑问。您正在使用IMDB数据集。如果我想使用不同的数据集,那么如何预处理数据集以准备单词整数矩阵来执行以下操作

# 加载数据集,但只保留前 n 个单词,其余归零

top_words = 5000

(X_train, y_train), (X_test, y_test) = imdb.load_data(num_words=top_words)

# 截断并填充输入序列

max_review_length = 500

X_train = sequence.pad_sequences(X_train, maxlen=max_review_length)

X_test = sequence.pad_sequences(X_test, maxlen=max_review_length)

我的数据(.csv格式的两列:推文和类别/手动标注)看起来像这样

奥巴马总统说,美国需要做更多的事情来帮助阻止埃博拉疫情成为全球危机。行动起来,不要空谈。风险

我很难过也很生气,因为托马斯·埃里克·邓肯谎报他接触过埃博拉,让我们所有人都面临感染这种致命疾病的风险。风险

埃博拉通过血液和唾液传播,所以我最好不要再那么用力地揍我的仇人,也不要再亲吻所有这些美丽的女人。传播

他得到了最好的治疗——比利比里亚更好——但我仍然不相信他不知道自己得了埃博拉,又是种族牌。治疗

奥巴马和疾控中心说他们将在非洲抗击埃博拉,今天的新闻是埃博拉死亡人数急剧上升,他们到底什么时候才能抗击它呢?治疗

妈的这真的很难,不知道我是否有勇气和胆量每天面对死亡和埃博拉。风险

对于埃博拉这种该死的东西,需要采取更严肃的措施。机场和他所在的小镇需要被隔离,我受够了被预防

如果你有埃博拉症状,或者认识有埃博拉症状的人,请拥抱并亲吻奥巴马先生,向他表示尊重,他会很感激。症状

只有当您与埃博拉患者的体液频繁接触并出现症状时,您才会感染。传播

请看这里的示例

https://machinelearning.org.cn/develop-word-embedding-model-predicting-movie-review-sentiment/

嗨,Jason,我想知道在构建了一个使用机器学习或深度学习的模型之后,如何使用该模型自动分类未标记的语料库?有没有示例?

此致

是的,在此处了解有关最终模型的更多信息

https://machinelearning.org.cn/train-final-machine-learning-model/

在此处学习如何保存和加载深度学习模型

https://machinelearning.org.cn/save-load-keras-deep-learning-models/

嗨,Jason,

感谢您的巨大努力,

我正在尝试使用Keras LSTM,但我不知道数据格式。

我有一个FAQ列表,问题被认为是样本,答案被认为是类别。那么我如何将lstm分类器用于此数据集?

先谢谢了

请看这篇文章

https://machinelearning.org.cn/reshape-input-data-long-short-term-memory-networks-keras/

嗨,Jason,

我有一个需要两种输入进行分类的问题。

第一个输入是在线活动的序列,我可以使用上述模型来处理。

第二个输入是每个活动与上次活动之间的时间差(分钟)向量。在这种情况下,我希望我的模型也能考虑时间对决策的影响。

我的问题是如何最好地将第二个输入合并到上述模型中?

我所做的是在第二个输入上也使用了一个LSTM层,并将输出与上面的输出合并。但这似乎不对,因为第二个输入是连续值而不是离散索引。

那么我应该使用什么样的层来应用于这些实值向量呢?

或许可以尝试一系列模型,看看哪种最有效。

或许多头模型是一个不错的方法。

嗨,Jason,

如何在此模型中处理两种类型的输入?

一个是线上活动的序列,第二个输入是每个活动与上一个活动之间的时间差。

我应该使用多模态层来合并它们吗?

我是否也应该用LSTM层处理第二个输入?(这似乎不对,因为该向量的元素是连续值)

祝好,

R

请参阅此帖子中的示例

https://machinelearning.org.cn/keras-functional-api-deep-learning/

谢谢您的回复。我明白如何合并两个层,但我的问题是,我应该在哪一层合并在线活动及其近期分数?

例如,我可以对在线活动应用一个LSTM层,然后将LSTM层的输出(最后一个隐藏状态输出)与它们的近期分数序列连接起来。但这没有意义。

或者我可以将嵌入输出与它们的近期分数序列相乘,然后将输出放入LSTM层。但我不知道这是否正确。

您能给我一些建议吗?

谢谢,

雷

我的直觉可能会引导您走上错误的道路。也许可以尝试几种设计,看看哪种最适合您的特定问题。

目前这方面更多的是艺术而非科学。

很公平。不过还是非常感谢。当我必须向我的教授汇报进展时,我会以此作为借口。😀

你好,

我可以使用LSTM从视频生成标签吗?例如使用youtube2text?

谢谢

当然可以。

我可以用它进行唇语识别吗?我正在考虑将一系列帧分类为特定单词。比如整个视频将被分类为hello、how等。

你能告诉我该怎么做吗?

听起来不错。抱歉,我没有任何唇语识别模型的示例。

嗨,Jason:您的教学技能远超许多“大牌”教学专家。

作为一个实验,我在您的“简单”LSTM示例中的模型中添加了一行。

model.layers[0].trainable = True # 通过嵌入层进行训练(反向传播)

虽然可训练参数的数量显著增加(从53,301增加到1,660,501),但准确率没有变化。

想听听您对这个实验的看法。

该层默认是可训练的。赋值应该没有效果。我很惊讶。

Jason,

感谢您精彩的解释。

我修改了您的代码,以便在测试数据上获得更高的准确性,最终,我在测试数据集上获得了88.60%的准确性。

我的问题是,除了我盲目地修改这些超参数之外,我们还能做些什么来提高测试数据上的预测准确性?或者如何克服过拟合以在测试数据上获得更高的预测准确性?我发现很容易在训练数据上获得更高的预测准确性,但令人惊讶的是很难在测试数据集(或验证数据集)上实现相同的结果。我修改的代码如下,供其他人参考:

谢谢!

Clock ZHONG

做得好,这里还有一些想法

https://machinelearning.org.cn/improve-deep-learning-performance/

谢谢,Jason,您写的那篇文章,我半年前就已经仔细阅读过了。它也很完美,但我仍然觉得我们没有一个清晰的指南来如何提高测试数据集上的预测准确性。

我们总是说

1. 更多的训练和测试数据可以获得更好的性能,但并非总是如此。

2. 神经网络中更深的层可以获得更好的性能,但仍然并非总是如此;

3. 微调超参数可以获得更好的性能,是的,它是,但除了时间消耗之外,这种工作只能非常非常少地提高性能(根据我的经验)。

4. 尝试更多其他架构的神经网络算法。是的,有时这可能会奏效,但很快我们又会达到上限,并立即面临同样的问题:然后如何改进它?

克服过拟合在神经网络中确实是一项有趣但困难的工作,我觉得未来我们可以找到一些更好的方法来解决这个问题。

我仍然感谢您的文章和回复。祝您周末愉快。

谢谢

Clock ZHONG

是的,这很难,而且是经验性的。这就是这份工作的本质。

没有明确的答案,没有人能告诉您如何为给定数据集获得最佳结果。您必须自己发现。

非常感谢Jason的精彩帖子。我很难理解LSTM如何记住长期依赖关系。或者也许,我误解了“记住依赖关系”的含义。它记住特定训练数据内的不同部分还是不同训练数据之间的不同部分?

例如,如果我们有100个训练数据,它会通过记住之前的训练数据来从第81个数据中学习吗?

提前非常感谢您的时间和帮助,

我有一个例子可以清楚地说明这一点。

https://machinelearning.org.cn/memory-in-a-long-short-term-memory-network/

我会阅读的,非常感谢。

Jason

很棒的文章!它对我帮助很大。

但是,我不明白为什么Dropout在降低准确率的同时却被认为发挥了积极作用。

这通常会有帮助,在这篇文章中我们正在演示如何实现它。

你好,

谢谢这篇文章。您能提供一个关于如何将LSTM应用于手写图像识别的思路吗?我有一个手写字母数据集,图像大小为50*50。

如果我能知道LSTM如何帮助手写文本识别,也会很有帮助

谢谢你,

当然,请看这篇帖子

使用卷积神经网络和 Python Keras 进行手写数字识别

谢谢你的帮助

1.该代码使用卷积神经网络。我应该做哪些更改才能使用循环神经网络(LSTM)?

2.如何加载自定义图像数据集进行训练和测试,而不是MNIST数据集。

LSTM可以用于图像序列,但前端仍将使用CNN。

请参阅此帖子了解CNN LSTM

https://machinelearning.org.cn/cnn-long-short-term-memory-networks/

感谢您这项伟大的工作!我们能将其应用于法语吗?

当然可以。

你好,

好文章。我有一个比较基本的问题。据我所知,这里每个样本都是长度为“max_review_length”的序列。然而,如果我有一个一维序列,每个样本都是序列的一部分。我的问题是,如何告诉算法序列发生在哪个维度。

在这里,我们输入的是本身不是序列一部分但包含序列的样本。但在其他用例中,我们似乎是按序列输入样本,而样本本身构成序列。我们甚至可以输入多维序列,例如多个并行时间序列,它们只在第一维是序列。

我对此有点困惑,在我看来,算法应该只识别沿一个维度的序列,如果您能澄清一下就太好了。

谢谢

我不确定我是否理解。

也许这篇帖子能让LSTM的输入更清晰

https://machinelearning.org.cn/reshape-input-data-long-short-term-memory-networks-keras/

好的,我来澄清一下。假设我们有一个包含5个值的序列。我们可以逐个输入序列,形状为(5,1,1),或者一次性输入所有5个点(1,5,1)作为长度为5的向量。然而,这两种情况都被认为是序列吗?

在我看来,第一个是长度为5的序列,而第二个是5个长度为1的并行序列。这很重要,因为在情感分析的例子中,我们有N个长度为“max_lenght”的样本,即形状为(N, max_lenght, 1)。或者如果使用嵌入,可能是(N, max_lenght, embedding_dim)。

如果序列在第一个维度,即N的维度,那么LSTM就没有意义,因为不同评论之间不应该存在序列关系。

谢谢

不,第一个是5个序列,第二个是1个序列。无论如何,LSTM一次只处理一个时间步的数据作为输入。

一个批次由1个或多个序列(样本,第一维度)组成。

权重更新在每个批次结束时发生,此时内部状态被清除。这意味着,序列之间存在知识。如果需要的话,也可以有。

好的,我明白了。谢谢你的澄清。继续努力。

不客气。

嗨,Jason,

我刚开始学习机器学习,并在keras上尝试了一些示例项目。这篇文章是一个非常好的学习示例。

我有一个关于分类问题的问题。现在,我正在尝试一个二分类序列分类问题。我按照这个教程建立了模型,损失函数为二元交叉熵。然后我将输出层改为2个单元,将损失函数改为分类交叉熵,并将y_training改为独热编码。我期望这两种方法能给出相同的准确率,但实际上,分类交叉熵似乎更准确。你有什么想法为什么会这样吗?据我理解,二元交叉熵与2分类别的分类交叉熵是相同的,所以这两种方法应该给出相同的结果。

另一个问题。我读了你网站上的另一篇文章,并将输入层改为LSTM。然后我截断了训练数据。我使用完整的训练数据进行验证。截断的训练数据在验证时给出了比使用完整训练数据构建的模型更高的准确率。我在这里使用了二元交叉熵方法。这与我的预期不符。我还想知道如何决定输入层的类型?

如果你能花时间回答我的问题,我将不胜感激。

它可能允许模型更具表达力(例如,在输出计算中有更多的权重)。

我不确定我是否理解第二个问题,也许你能给出一个非常简短的例子?

这个模型适合预测用户是否执行了这项活动吗?因为我想开发一个模型来预测用户是否执行了这项活动。我想在用户活动(比如跳跃)上训练模型,然后测试用户是否在跳跃。这个模型能帮到我吗,或者你有什么代码可以帮助我吗?谢谢你的帮助,此致,Sardar Khan。

也许可以尝试一下。

你能给我一个例子吗。

抱歉,我没有你问题的示例。

我无法清楚地理解这里二分类是如何发生的?我正在试图弄清楚以下问题:

对于分类,LSTM的最终单词的最终输出是否被提供给单神经元密集层?如果是这样,在你另一篇关于“使用LSTM生成文本”的文章中,你似乎创建了一个输出密集层,其神经元数量等于词汇量中的单词数量。但在文本生成的情况下,你需要输出,使得给定的记忆单元预测下一个合适的单词。那么密集层到底是如何连接到LSTM层的,它是如何工作的(因为LSTM层似乎只给出最终单词的最终输出)??请帮助我回答这两个问题。

是的,Jason,这也是我困扰的问题。你能解释一下在这两种不同情况(“序列分类”和“文本生成”)中,密集层是如何与LSTM层“连接”的吗?

提前感谢你

安基塔

这个例子是将词序列分类为好/坏情绪。

它与生成文本(输出一个词序列)不同。

这有帮助吗?

谢谢你的回复,Jason。

但是你能解释一下在这两种情况下,LSTM层和密集层之间的连接到底有何不同吗?

你具体是什么意思?

嗨 ..

干得好..但我们如何输入单个评论并获得其预测结果呢?

您必须像处理任何训练数据一样准备单个输入。

这里有一些伪代码可以帮助你

嗨,Jason,

感谢这篇精彩的文章。我正在尝试实现一个类似您的分类器,但在不同的数据(日志文件)上进行训练,并使用另一种输入形状。我得到了多行数据,每行有9个特征,每个特征都填充到MAX_FEATURE_LEN。这对于LSTM层来说工作正常,但只要我添加Embedding或Dense层,就会出现类似以下的错误:

Error when checking target: expected dense_1 to have 2 dimensions, but got array with shape (2000, 9, 256)我目前的模型

features = 9

MAX_FEATURE_LEN = 256

model = Sequential()

model.add(Embedding(file_len(TRAIN_PATH), features, input_length=MAX_FEATURE_LEN))

model.add(Dropout(0.2))

model.add(LSTM(100, return_sequences=True))

model.add(Dropout(0.2))

model.add(Dense(1, activation='sigmoid'))

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

我尝试了几种方法,它对LSTMs有效,所以我不知道Dense层和LSTMs在input_shape方面有什么区别。

提前感谢你

阿德里安

也许可以退一步,学习一下NLP中的LSTM。

https://machinelearning.org.cn/start-here/#nlp

这篇博文非常棒,对使用Keras实现LSTM-CNN的指南也很易读。

最近我正在处理一个二分类任务,该任务从多个传感器获取实数数据。我受到了你的文章启发,想知道是否可以把这些数据排列成图像一样的矩阵,其中每一行是一个传感器的向量,多行代表不同传感器的数据,然后使用你文章中的LSTM、CNN或LSTM+CNN模型对数据进行分类。

你觉得这种模型可行吗?或者?再次感谢你的文章!

也许多个1D CNN会更有意义?

我建议尝试一下,而不是过多地考虑它是否可行,例如,Keras非常容易,你可以在几分钟内将其原型化。

不错的教程,Jason。它让我开始在Keras中使用LSTMs!

对于分类问题,使用多少个LSTM单元有什么经验法则吗?输入序列的长度对这个数字有影响吗?

好问题。

没有关于配置单元数量或层数的良好启发式方法。输入长度与隐藏层中的单元数量没有关系。

我建议仔细和系统地进行实验,以了解哪种方法最适合您的特定数据集。

nb_words 已被 num_words 取代

谢谢,已修正。

nb_epoch 也被 epochs 取代了

谢谢,已修正。

菜鸟问题:这个模型能预测序列的特定模式吗?比如x, x^2, x^3, sin(x)等等这些序列的所有组合?

一个模型或许可以被训练来学习这些序列。

亲爱的 Jason,

请问您能帮我如何在Keras中“上传我自己的数据集”吗?因为我想使用自己的数据集。谢谢您的时间。