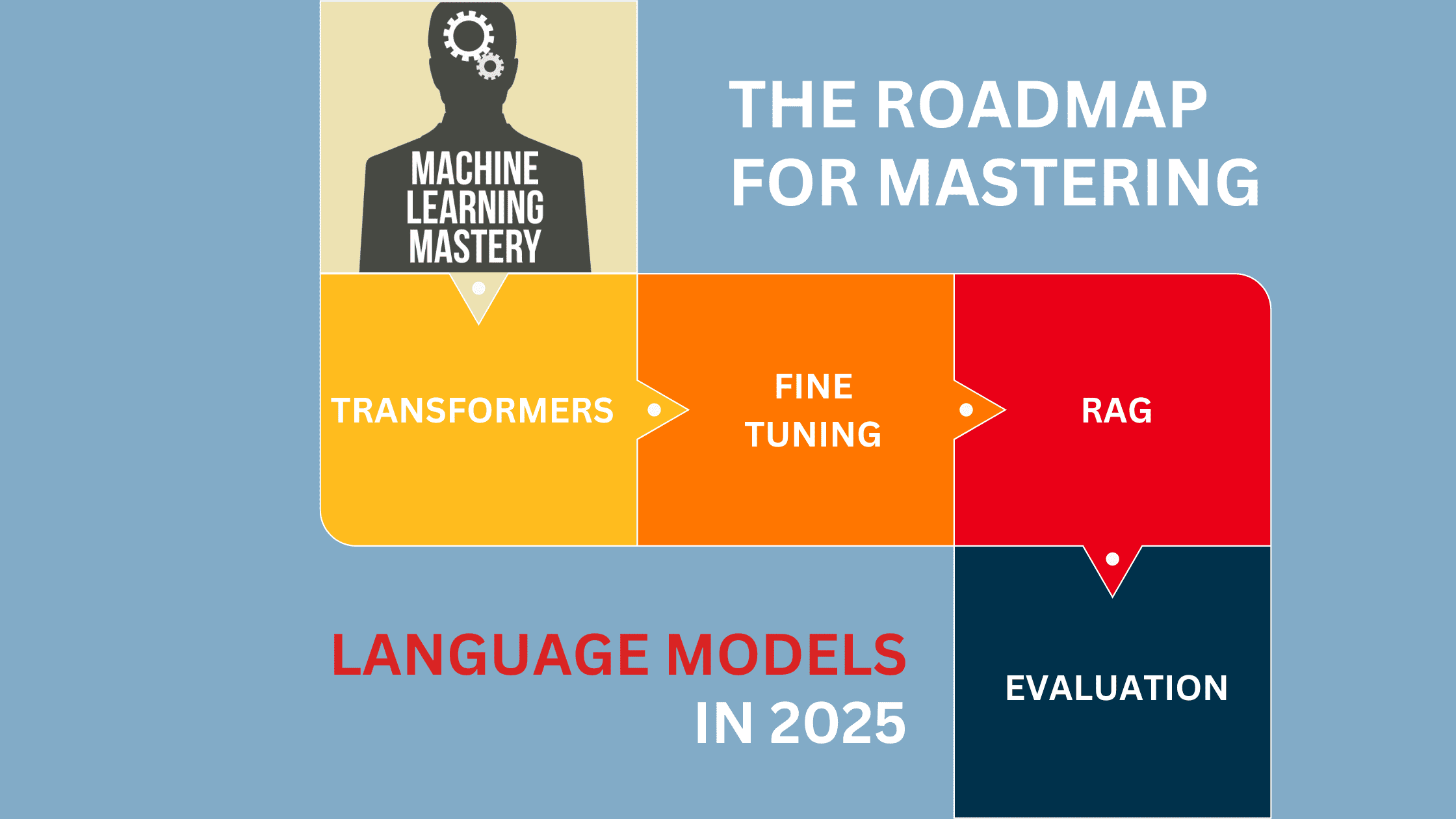

2025 年精通语言模型学习路线图

图片来源:编辑 | Midjourney

大型语言模型(LLM)是人工智能领域的一大飞跃。它们能够预测和生成听起来像人类书写的文本。LLM可以学习语言的规则,如语法和含义,这使它们能够执行许多任务。它们可以回答问题,总结长文本,甚至创作故事。对自动生成和组织内容日益增长的需求正在推动大型语言模型市场的扩张。据一份报告显示,大型语言模型(LLM)市场规模与预测

“全球LLM市场目前正经历强劲增长,据估计市场规模将大幅增加。预计市场价值将从2024年的64亿美元增长到2030年的361亿美元,在预测期内的复合年增长率(CAGR)将达到33.2%。”

这意味着2025年可能是开始学习LLM的最佳年份。学习LLM的高级概念包括结构化的、循序渐进的方法,涵盖概念、模型、训练和优化,以及部署和高级检索方法。本路线图提供了一个循序渐进的方法来获得LLM方面的专业知识。那么,让我们开始吧。

第一步:掌握基础知识

如果您已经掌握了编程、机器学习和自然语言处理的基础知识,则可以跳过此步骤。但是,如果您是这些概念的新手,请考虑从以下资源中学习它们。

- 编程:您需要学习Python的基础知识,Python是机器学习中最流行的编程语言。这些资源可以帮助您学习Python。

学习Python – 初学者完整课程[教程] – YouTube (推荐)

Python入门快速入门 – YouTube

教科书:Python硬核学习法 - 机器学习:学习编程后,在继续学习LLM之前,您必须掌握机器学习的基本概念。关键在于关注概念,如监督学习与无监督学习、回归、分类、聚类和模型评估。我发现学习ML基础的最佳课程是

吴恩达的机器学习专项课程 | Coursera

这是一门付费课程,如果您需要认证,可以购买,但幸运的是,我在YouTube上也找到了免费版本。

吴恩达教授的机器学习 - 自然语言处理:如果您想学习LLM,学习NLP的基础主题非常重要。关注关键概念:分词、词嵌入、注意力机制等。我提供了一些可能有助于您学习NLP的资源。

Coursera:DeepLearning.AI 自然语言处理专项课程 – 专注于NLP技术和应用 (推荐)

斯坦福CS224n (YouTube):深度学习自然语言处理 – 关于深度学习NLP的综合讲座系列。

第二步:理解大型语言模型背后的核心架构

大型语言模型依赖于各种架构,其中Transformer是最重要的基础。理解这些不同的架构方法对于有效地处理现代LLM至关重要。以下是增强您理解的关键主题和资源。

- 理解Transformer架构,并重点关注理解自注意力、多头注意力和位置编码。

- 从《Attention Is All You Need》开始,然后探索不同的架构变体:仅解码器模型(GPT系列)、仅编码器模型(BERT)以及编码器-解码器模型(T5、BART)。

- 使用Hugging Face的Transformers等库来访问和实现各种模型架构。

- 练习针对分类、生成和摘要等特定任务对不同架构进行微调。

推荐学习资源

- 图解Transformer(博客与视觉指南):必须阅读的Transformer模型视觉化解释。

- Transformer解释 – Yannic Kilcher:解释“Attention is All You Need”的实现:对Transformer论文的易于理解的分解 (推荐)。

- 语言模型是少样本学习者 – 仅解码器架构(GPT系列)。

- BERT:用于语言理解的深度双向 Transformer 预训练.

- 探索统一文本到文本Transformer的迁移学习极限 – T5。

- Hugging Face教程(2024) – 这个全面的指南涵盖了各种NLP任务,包括使用Hugging Face构建情感分析模型 (推荐)。

- 微调BERT进行文本分类 – 一个视频指南,解释如何使用示例对BERT进行微调以对网络钓鱼URL进行分类 (推荐)。

- 微调 GPT2 | Transformers huggingface | 对话式聊天机器人 | GPT2LMHeadModel – 一个视频指南,解释如何微调GPT2模型以创建对话式聊天机器人。

第三步:专注于大型语言模型

在打好基础之后,就可以专注于LLM了。这些课程旨在加深您对其架构、道德影响和实际应用的理解。

- LLM大学 – Cohere (推荐):为新来者提供了顺序性学习路径,也为经验丰富的专业人士提供了非顺序性、以应用为中心的路径。它对LLM的理论和实践方面进行了结构化探索。

- 斯坦福CS324:大型语言模型 (推荐):一门综合课程,探讨LLM的理论、伦理和实践。您将学习如何构建和评估LLM。

- Maxime Labonne指南 (推荐):本指南为两条职业道路提供了清晰的路线图:LLM科学家和LLM工程师。LLM科学家路径适合那些希望使用最新技术构建先进语言模型的人。LLM工程师路径侧重于创建和部署使用LLM的应用程序。它还包括《LLM工程师手册》,该手册将逐步指导您完成设计和发布基于LLM的应用程序。

- 普林斯顿COS597G:理解大型语言模型:一门研究生课程,涵盖BERT、GPT、T5等模型。它非常适合那些旨在进行深入技术研究的人,本课程探讨了LLM的能力和局限性。

- 微调LLM模型 – 生成式AI课程在使用LLM时,您将需要微调LLM,因此请考虑学习高效的微调技术,如LoRA和QLoRA,以及模型量化技术。这些方法可以帮助减小模型大小和计算需求,同时保持性能。本课程将教您使用QLoRA和LoRA进行微调,以及使用LLama2、Gradient和Google Gemma模型进行量化。

- 使用Huggingface和Pytorch微调LLMs以教授它们任何东西 | 分步教程:提供了一个使用Hugging Face和PyTorch微调LLMs的全面指南。它涵盖了从数据准备到模型训练和评估的整个过程,使观众能够针对特定任务或领域调整LLMs。

第四步:构建、部署和运行LLM应用程序

理论上学习一个概念是一回事;实践应用是另一回事。前者加强了您对基本思想的理解,而后者使您能够将这些概念转化为实际解决方案。本节重点介绍使用流行的框架、API以及在生产和本地环境中部署和管理LLM的最佳实践来将大型语言模型集成到项目中。通过掌握这些工具,您将能够高效地构建应用程序、扩展部署,并实施LLMOps策略进行监控、优化和维护。

- 应用程序开发:学习如何将LLM集成到面向用户的应用程序或服务中。

- LangChain:LangChain是LLM项目的快速高效框架。学习如何使用LangChain构建应用程序。

- API集成:探索如何连接各种API,例如OpenAI的API,以向您的项目添加高级功能。

- 本地LLM部署:学习在本地计算机上设置和运行LLM。

- LLMOps实践:学习在生产环境中部署、监控和维护LLM的方法。

推荐的学习资源和项目

构建LLM应用程序

- LangChain入门快速入门课程 | LangChain教程 – 关于使用LangChain构建应用程序的实用指南。

- LangChain大师班 2024 – 涵盖20多个LangChain的实际用例。(推荐)

- OpenAI API入门快速入门课程 | 使用OpenAI API的财务数据提取工具 – 本教程包括使用OpenAI API构建项目的分步说明。(推荐)

- 从零开始构建您自己的LLM聊天机器人 | 端到端生成式AI | 端到端LLM | Mistral 7B LLM – 提供了一个关于使用Mistral 7B大型语言模型(LLM)创建聊天机器人的全面分步指南。

- LLM课程 – 构建语义图书推荐器(Python、OpenAI、LangChain、Gradio) – 关于构建语义图书推荐器的详细指南。

- YouTube免费播放列表,包含LLM端到端项目 – 一个免费的YouTube播放列表,包含20多个LLM端到端项目。(推荐)

本地LLM部署

- 如何在自己的机器上部署LLM – 在本地部署大型语言模型,涵盖设置和集成。

- 如何在本地运行任何开源大型语言模型 – 在本地硬件上设置和运行开源LLM。

- 本地大型语言模型基础 – 由杜克大学提供,本课程教您如何设置本地环境来运行各种LLM,并通过Web界面和API与之交互。

- LLM入门Llamafile – 学习使用llama.cpp框架将大型语言模型作为生产级Web API提供服务。

容器化LLM驱动的应用程序:聊天机器人部署 – 使用Docker部署本地LLM的分步指南。

在生产环境中部署和管理LLM应用程序

- 如何使用Hugging Face + AWS将LLM(大型语言模型)部署为API – 涵盖在云中将LLM部署为API。

- LLMOps教学视频系列 – 一个全面的5部分系列,在Azure AI Studio中提供现场演示,指导您完成LLMOps的各个方面。

- 大型语言模型运维(LLMOps)专项课程 – 由杜克大学提供的Coursera专项课程,涵盖在Azure、AWS、Databricks和本地基础设施等平台上部署、管理和优化LLM。

- 在几分钟内简化LLMOps并构建LLM管道 – 一个关于如何使用Vext平台简化LLMOps和构建高效LLM管道的教程。

GitHub存储库

- Awesome-LLM:它是一个精选的论文、框架、工具、课程、教程和资源集合,专注于大型语言模型(LLM),并特别强调ChatGPT。

- Awesome-langchain:该存储库是跟踪与LangChain生态系统相关的倡议和项目的中心。

第五步:RAG和向量数据库

检索增强生成(RAG)是一种结合信息检索和文本生成的混合方法。RAG不是仅依赖预训练知识,而是在生成响应之前从外部来源检索相关文档。这提高了准确性,减少了幻觉,并使模型在知识密集型任务中更有用。

- 理解RAG及其架构(例如,标准RAG、层次化RAG、混合RAG)

- 向量数据库 – 了解如何将向量数据库与RAG集成。向量数据库根据语义含义而不是精确的关键词匹配来存储和检索信息。这使得它们成为基于RAG的应用程序的理想选择,因为它们可以快速高效地检索相关文档。

- 检索策略 – 实现密集检索、稀疏检索和混合搜索,以实现更好的文档匹配。

- LlamaIndex和LangChain – 了解这些框架如何促进RAG。

- 为企业应用程序扩展RAG – 了解分布式检索、缓存和延迟优化,以处理大规模文档检索。

推荐的学习资源和项目

基础基础课程

- 向量数据库:Faiss – 相似性搜索入门 – 本视频涵盖了FAISS的基础知识,并解释了它如何改进相似性搜索。

- Chroma – 用于LLM应用的向量数据库 | OpenAI集成 – 了解ChromaDB如何帮助您为基于检索的应用管理向量数据。

- 从零开始学习RAG – 来自LangChain工程师的Python AI教程 – 这个Python课程教您如何使用RAG将您自己的自定义数据与大型语言模型(LLM)集成。(推荐)

- Python LlamaIndex入门(2024) – 涵盖如何使用LlamaIndex在Python中进行高效的数据检索和与LLM的集成。

- 检索增强生成(RAG)入门 | Coursera – RAG入门,教您如何将外部数据与LLM集成以提高准确性和减少幻觉。(推荐)

高级RAG架构和实现

- 检索增强生成(RAG)模式和最佳实践 – 本视频教授不同的RAG架构、模式和最佳实践,以优化检索和生成过程。(推荐)

- 使用RAG和LangChain的AI代理基础 – 学习高级RAG技术、提示工程以及使用LangChain构建AI代理。

- HybridRAG:终极RAG引擎 – 知识图谱+向量检索 – YouTube – 探讨知识图谱与向量检索的集成,以创建高级RAG系统。(推荐)

- 检索增强生成LlamaIndex和LangChain课程 – 本课程教授如何使用现代工具构建高效的RAG系统,涵盖向量数据库、嵌入和实际应用。

企业级RAG和扩展

- RAG:构建企业级检索增强生成应用程序 – YouTube – 这个YouTube播放列表提供了构建和优化RAG系统的全面指南,涵盖了概念、架构和实际实现。

- 使用Vertex AI Gemini API进行多模态RAG – Coursera – 这个项目驱动的课程教授如何使用Google的Vertex AI Gemini API执行多模态RAG,重点关注企业级应用程序。(推荐)

- 向Zain学习高级RAG技巧 – YouTube – 一场关于用于企业应用的高级RAG技术的会议。

第六步:优化LLM推理

优化推理对于使LLM驱动的应用程序高效、经济高效和可扩展至关重要。此步骤侧重于减少延迟、改善响应时间和最小化计算开销的技术。

关键主题

- 模型量化:使用8位和4位量化等技术(例如GPTQ、AWQ)减小模型大小并提高速度。

- 高效服务:使用vLLM、TGI(文本生成推理)和DeepSpeed等框架高效部署模型。

- LoRA和QLoRA:使用参数高效的微调方法,在不产生高昂资源成本的情况下提高模型性能。

- 批处理和缓存:通过批处理和缓存策略优化API调用和内存使用。

- 设备端推理:使用GGUF(用于llama.cpp)和ONNX、TensorRT等优化运行时在边缘设备上运行LLM。

推荐学习资源

- 高效服务LLMs – Coursera – 一个关于优化和高效部署大型语言模型以用于实际应用的指导项目。

- 掌握LLM推理优化:从理论到成本效益部署 – YouTube – 一个讨论LLM推理中的挑战和解决方案的教程。它侧重于可扩展性、性能和成本管理。(推荐)

- MIT 6.5940 2024年秋季TinyML和高效深度学习计算 – 它涵盖了模型压缩、量化和优化技术,以在资源受限的设备上高效部署深度学习模型。(推荐)

- 推理优化教程(KDD)– 使模型运行更快 – YouTube – 来自Amazon AWS团队的教程,介绍了加速LLM运行时性能的方法。

- 使用ONNX Runtime进行大型语言模型推理(Kunal Vaishnavi) – 一个关于使用ONNX Runtime优化LLM推理以实现更快、更高效执行的指南。

- CPU上本地运行Llama 2,无需GPU GGUF量化模型 Colab Notebook演示 – 一个关于使用GGUF量化在CPU上本地运行LLaMA 2模型的步骤指南。

- LLM量化教程(w/ QLoRA、GPTQ和Llamacpp、LLama 2) – 涵盖了QLoRA和GPTQ等各种量化技术。

- 推理、服务、PagedAttention和vLLM – 解释了推理优化技术,包括PagedAttention和vLLM,以加快LLM服务。

总结

本指南涵盖了2025年学习和掌握LLM的全面路线图。我知道它乍一看可能令人望而生畏,但请相信我——如果您遵循这个循序渐进的方法,您将很快掌握所有内容。如果您有任何问题或需要更多帮助,请评论。

深入学习所有材料需要多长时间?诚实的问题。

你好chema……请澄清你的问题。你是问需要投入多少时间来学习吗?